Backlink-Effekt mit Server-Logs nachweisen, bevor Rankings sich ändern

Belegen Sie Backlink-Effekte mit Server-Logs, indem Sie Googlebot-Crawl-Spitzen, Bot-Pfade und Abrufhäufigkeit verfolgen, um Link-Wirkung zu bestätigen, bevor Rankings sich ändern.

Was Sie mit Logs nachweisen können, bevor sich Rankings ändern

Rankings hinken oft hinterher. Google muss Seiten neu crawlen, Signale verarbeiten, den Index aktualisieren und dann entscheiden, ob sich Positionen ändern sollen. Diese Verzögerung erklärt, warum gute Arbeit manchmal Tage oder Wochen lang keine Bewegung in Rank-Trackern zeigt.

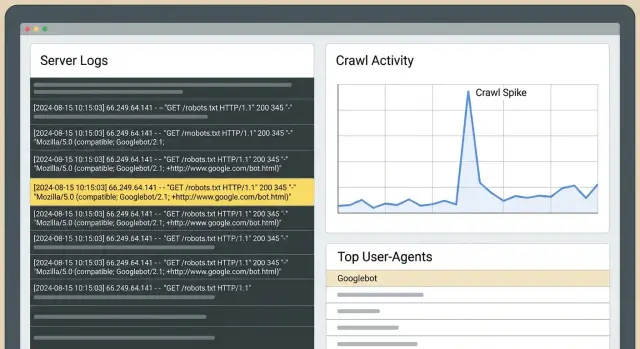

Server-Logs sitzen früher in dieser Kette. Sie beantworten eine einfachere Frage: Hat Googlebot sein Verhalten auf Ihrer Seite geändert, nachdem die Links live gingen? Wenn die Antwort ja ist, haben Sie einen Beleg dafür, dass etwas Reales passiert ist, auch wenn Traffic und Rankings noch gleich bleiben.

Die schnellsten, sichtbarsten Verschiebungen in den Logs sehen üblicherweise so aus:

- Die verlinkte Seite wird häufiger gecrawlt oder überhaupt erst gecrawlt.

- Googlebot besucht diese Seite früher wieder (kürzere Abstände zwischen Abrufen).

- Googlebot nutzt diese Seite als Einstiegspunkt und folgt internen Links tiefer in die Seite.

- Sie sehen Crawl-Bursts kurz nach der Platzierung, besonders wenn die verlinkende Seite selbst oft gecrawlt wird.

Das unterscheidet sich von Search Console und Rank-Trackern. Search Console ist nützlich, aber verzögert und aggregiert. Tracker zeigen Ergebnisse, nicht Ursachen. Logs zeigen rohes Verhalten: jede Anfrage, mit Zeitstempel, inklusive welcher Bot welche URL aufgerufen hat und welchen Statuscode Ihr Server zurückgegeben hat.

Die Kernmethode ist unkompliziert: Wählen Sie ein sauberes „Vorher“-Fenster und ein „Nachher“-Fenster und vergleichen Sie dann die Googlebot-Aktivität für die spezifischen URLs, die Sie angezielt haben. Wenn die „Nachher“-Periode eine höhere Crawl-Rate und zielgerichtetere Pfade zeigt, können Sie sagen, dass die Links Googles Aufmerksamkeit verändert haben.

Beispiel: Sie zeigen mit einem neuen Backlink auf eine Produktseite. Zwei Tage später zeigen die Logs, dass Googlebot diese Seite wiederholt abruft und dann die Specs- und Pricing-Seite anfragt, auf die sie verlinkt. Rankings bewegen sich vielleicht noch nicht, aber Google verbringt offensichtlich Crawl-Budget dort. Das ist oft der erste sichtbare Schritt vor breiteren Gewinnen.

Server-Logs-Grundlagen (einfach erklärt)

Ein Server-Log ist ein Tagebuch der Anfragen an Ihre Seite. Jedes Mal, wenn ein Browser, eine App oder eine Suchmaschinen-Bot eine Seite oder Datei anfordert, zeichnet Ihr Server (oder CDN) eine Zeile auf.

Für SEO-Checks sind die wichtigsten Felder: Zeitstempel, angeforderte URL, User-Agent (wie Googlebot), Statuscode (200, 301, 404) und meist eine IP-Adresse. Sie müssen nicht jede Spalte auswendig kennen. Jede Zeile beantwortet: Wer hat was wann angefordert und was ist passiert.

Welche Logs sollten Sie verwenden?

Beginnen Sie mit Origin-Access-Logs, wenn möglich. Sie sind der „Ground Truth“ am nächsten und enthalten die exakten URLs und Response-Codes.

Wenn Sie ein CDN/WAF oder eine Bot-Protection-Schicht nutzen, können deren Logs Kontext hinzufügen (geblockte Requests, Challenges), aber sie können Traffic filtern oder kennzeichnen und damit Teile des Bildes verbergen. Halten Sie nach Möglichkeit beide Logs und notieren Sie Filterregeln, die das Ergebnis verändern könnten.

Wie lange sollten Sie Logs aufbewahren?

Retention ist wichtig für Vorher-Nachher-Vergleiche. 30 Tage sind ein praktikables Minimum. 60 bis 90 Tage sind besser, wenn Sie Links in Wellen bauen oder häufig veröffentlichen. Sie wollen genug „Vorher“-Daten, um normales Crawling zu verstehen, und genug „Nachher“-Daten, um zu sehen, ob Besuchshäufigkeit und Crawl-Routen tatsächlich verschoben wurden.

Zum Thema Datenschutz: Speichern Sie nur, was nötig ist, beschränken Sie den Zugriff und löschen Sie nach einem Plan. Wenn Logs personenbezogene Daten enthalten (z. B. vollständige IPs oder Query-Strings mit E-Mails), maskieren oder entfernen Sie diese Felder. Für diese Analyse sind Bot-Verhalten, Statuscodes und Seitenpfade relevant.

Echtes Googlebot-Verhalten von Rauschen unterscheiden

Bevor Sie irgendeinen „Spike“ interpretieren, vergewissern Sie sich, dass der Googlebot-Traffic in Ihren Logs wirklich Google ist. Fake-Bots kopieren oft Googles User-Agent. Zählen Sie diese mit, können Sie einen Crawl-Anstieg „beweisen“, der nie stattgefunden hat.

User-Agent-Strings sind ein guter Start (Googlebot, Googlebot-Image, AdsBot-Google), aber kein Beweis.

Warum Fake-Bots auftauchen

Das Spoofing von Google hilft Scrape-Tools, Sperren zu umgehen, Seiten auszutesten oder Inhalte in großem Umfang zu ziehen. Sie können auch Anfragen zu bestimmten URLs aufblähen und es so aussehen lassen, als hätte Google direkt nach einer Link-Platzierung Interesse gezeigt.

Einfache Wege, Googlebot zu validieren

Wählen Sie einen Ansatz und nutzen Sie ihn konsistent:

- Reverse-DNS-Validierung: Die IP sollte zu einem Google-eigenen Hostnamen aufgelöst werden, und dieser Hostname sollte zurück auf dieselbe IP auflösen.

- Muster-Sanity-Checks: Echter Googlebot zeigt oft gleichmäßiges Verhalten (regelmäßige robots.txt-Abrufe, sinnvolle Navigation).

Wenn möglich, trennen Sie Googlebot Smartphone von Googlebot Desktop. Sie verhalten sich oft unterschiedlich. Eine Änderung kann bei Smartphone zuerst sichtbar sein, während Desktop stabil bleibt.

Vier Log-Signale, die darauf hindeuten, dass Links Verhalten verändert haben

Rankings hinken dem hinterher, was Googlebot bereits tut. Nach einer Platzierung sind diese frühen Log-Signale die Blickpunkte:

Signal 1: Anhaltender Crawl-Anstieg auf der Zielseite

Ein starkes Zeichen ist ein deutlicher Anstieg der Googlebot-Anfragen zur Seite, auf die Sie verlinkt haben, über mehrere Tage hinweg. Vergleichen Sie gleich zu gleich (gleiche Wochentage), damit Sie normale Wochenmuster nicht fälschlich als „Gewinn“ werten.

Signal 2: Höhere Abruf-Frequenz (kürzere Revisit-Zyklen)

Wenn Google mehr Interesse zeigt, kommt es oft schneller zurück. In den Logs sehen Sie kürzere Abstände zwischen Treffern auf dieselbe URL. Das kann lange vor einem Ranking-Schub passieren, besonders bei Seiten, die zuvor kaum gecrawlt wurden.

Signal 3: Erweiterte Bot-Pfade ausgehend von der Landing-Page

Nachdem Googlebot die verlinkte Seite aufruft, prüfen Sie, was es innerhalb derselben Session oder in einem kurzen Zeitfenster als Nächstes anfragt. Wenn die Entdeckung besser wurde, sehen Sie mehr konsistente Bewegung von der Zielseite zu verwandten URLs (Kategorie-Seiten, unterstützende Artikel, wichtige Produktseiten).

Signal 4: Erstmalige Crawls für nahegelegene URLs

Wenn die Zielseite auf andere Seiten verweist, die zuvor wenig gecrawlt wurden, achten Sie auf Erstabrufe dieser URLs. Dieses „Ausfächern“-Muster deutet meist darauf hin, dass Googlebot erkundet und nicht nur eine Seite erneut prüft.

Bei allen vier Signalen entscheiden Statuscodes, ob das Crawling nützlich ist:

- 200 bedeutet, Googlebot hat Inhalt erhalten, den es bewerten kann.

- 301 ist nicht immer schlecht, aber lange Redirect-Ketten verschwenden Crawl-Budget.

- 404 erzeugt oft lautes, aber wertloses Aktivitätsrauschen.

- 5xx-Fehler führen häufig später zu Crawl-Rückgängen.

Richten Sie einen vertrauenswürdigen Vorher-Nachher-Vergleich ein

Das größte Risiko bei Log-basierter Validierung ist ein unordentlicher Vergleich. Googlebot ändert sein Verhalten aus vielen Gründen, daher sollte Ihre Einrichtung das „Link ging live“ zur Hauptvariablen machen.

Verwenden Sie zwei gleiche Fenster: üblich sind 14 bis 28 Tage vor dem Link (Baseline) und dieselbe Anzahl Tage danach.

Verfolgen Sie dann eine kleine, spezifische Menge an Seiten:

- Die URL, die den neuen Link erhalten hat.

- Die Seite, die Ihnen letztlich wichtig ist (falls anders).

- 2–3 eng verwandte Seiten im gleichen Abschnitt der Site.

- Eine Kontrollseite im gleichen Template/Ordner, die keine neuen Links bekam.

Für jede Seite verfolgen Sie tägliche Googlebot-Treffer, eindeutige URLs, die in diesem Cluster gecrawlt wurden, und die Median-Zeit zwischen Abrufen. Der Median ist stabiler als der Durchschnitt, wenn Crawl-Bursts die Daten verzerren.

Vor dem Vergleich führen Sie schnelle Checks durch: Bestätigen Sie, dass der Link im „Nachher“-Fenster live und indexierbar ist, halten Sie größere Site-Änderungen außerhalb der Fenster (Migrationen, große Template-Änderungen), wenden Sie dieselben Bot-Validierungs- und Filterregeln an und sorgen Sie dafür, dass Ihre Kontrollseite vergleichbar ist.

Schritt für Schritt: Link-Einfluss aus Logs validieren

Sie brauchen keine Ranking-Veränderungen, um frühe Verhaltensänderungen zu sehen. Wenn der Link entdeckt und als sinnvolles Signal behandelt wurde, zeigen es die Logs meist zuerst.

Ein praktischer Workflow:

- Ziehen Sie rohe Logs für ein sauberes „Vorher“-Fenster und ein passendes „Nachher“-Fenster.

- Filtern Sie auf verifizierte Googlebot-Requests und trennen Sie Smartphone vs Desktop, falls verfügbar.

- Gruppieren Sie nach URL und Tag. Suchen Sie nach konzentrierten Anstiegen auf den Seiten, die Sie gezielt haben — nicht nur nach siteweiten Erhöhungen.

- Überprüfen Sie Pfade: Welche URLs fordert Googlebot nach dem Abruf der verlinkten Seite an?

- Schreiben Sie pro Seite einen Fazit-Satz mit derselben Vorlage.

Halten Sie die Schlussfolgerungen strikt und testbar. Beispiel: „Nachdem der Link live ging, erhöhte Googlebot Smartphone die Abrufe von /pricing von 3 pro Woche auf 11 pro Woche und crawlte dann innerhalb von 10 Minuten /features und /checkout — das trat im Baseline-Fenster nicht auf.“

Wenn Sie keinen klaren Satz wie diesen formulieren können, ist das Vergleichsfenster wahrscheinlich zu verrauscht oder Sie mischen Googlebot mit anderen Crawlern.

Bot-Pfade interpretieren: Was Googlebot macht, nachdem es einen Link findet

Wenn ein neuer Backlink entdeckt wird, ändert Googlebot selten Rankings über Nacht. Häufig ändert sich zuerst seine Route durch Ihre Seite. Pfadanalyse heißt nur, Googlebots Fußspuren zu lesen: Was es zuerst anfragt, was danach kommt und wie oft es zurückkehrt.

Trennen Sie zwei URLs in Ihrer Vorstellung:

- Die verlinkte URL (wo der Backlink hinzeigt).

- Die „Money“-Seite (die Seite, die Sie gewinnen möchten).

Oft wird die verlinkte URL zuerst warm, und dann wird Aufmerksamkeit über interne Links weitergegeben.

Ein nützlicher Vergleich sind Einstiegsseiten. Vor dem Link betrat Googlebot Ihre Site vielleicht über die Startseite oder Sitemap. Nach dem Link sehen Sie eventuell, dass Googlebot direkt auf der verlinkten URL landet und dann tiefer über interne Links navigiert.

Achten Sie auf diese Änderungen:

- Häufigere Treffer auf der verlinkten URL.

- Tiefere Seiten werden früher und konsistenter gecrawlt.

- Kürzere Refresh-Zyklen bei Seiten in diesem Cluster.

- Spitzen bei Parameter- oder Duplicate-URLs (oft ein Zeichen für Crawl-Waste, nicht für Fortschritt).

Wenn Parameter-URLs ansteigen (z. B. ?sort= oder Paginierung), hilft der Backlink vielleicht trotzdem, aber die Logs sagen Ihnen auch, dass Sie Crawl-Traps bereinigen sollten, damit Googlebot mehr Zeit auf Ihren wichtigen Seiten verbringt.

Häufige Fehler, die zu falschen Schlussfolgerungen führen

Logs können frühe Belege liefern, aber sie können auch normales Rauschen vergrößern.

Der häufigste Fehler ist, zwei Perioden zu vergleichen, die gar nicht vergleichbar sind. Crawl-Anstiege können durch Redesigns, Navigationsänderungen, neue Seiten, robots.txt-Edits, WAF/Firewall-Regeln und Statuscode-Probleme (Redirect-Ketten, 404-Spitzen, 5xx-Fehler) verursacht werden.

Ein weiterer häufiger Fehler ist, alle Bots zu zählen, einschließlich gefälschter User-Agents.

Bevor Sie einem „Gewinn“ vertrauen, prüfen Sie die Basics: Vergleichen Sie dieselben Wochentage, überprüfen Sie robots- und Indexierungsänderungen im Fenster, brechen Sie Ergebnisse nach Statuscode auf (200 vs 3xx vs 4xx/5xx), filtern Sie auf verifizierten Googlebot und suchen Sie nach einem anhaltenden Anstieg statt einem Ein-Tages-Peak.

Beispiel: Sie kaufen einen Backlink auf /pricing und zwei Tage später ruft Googlebot /pricing fünfmal häufiger ab. Wenn Sie jedoch gleichzeitig ein Redesign mit Header-Links zu /pricing live gesetzt haben, kann der Anstieg interne Entdeckung sein, nicht der Backlink.

Schnell-Checkliste: Haben die neuen Links Googles Verhalten verändert?

Verwenden Sie dasselbe Zeitfenster auf beiden Seiten (z. B. 14 Tage vor Placement vs 14 Tage danach). Filtern Sie auf verifizierte Googlebot-Requests und beantworten Sie diese Fragen:

- Sind die Anfragen zur verlinkten Ziel-URL merklich gestiegen?

- Wurde das Crawling über die Woche gleichmäßiger statt nur ein zufälliger Peak?

- Ist die typische Zeit zwischen Abrufen für die Ziel-URL und ihre engsten Unterstützungsseiten gesunken?

- Blieben die Fehlerquoten stabil, während das Crawling zunahm?

- Blieb eine vergleichbare Kontrollseite ungefähr konstant?

Wenn Sie drei oder mehr „Ja“-Antworten haben, hat sich Googles Crawl-Verhalten wahrscheinlich geändert, auch wenn die Positionen sich noch nicht bewegt haben.

Zwei zusätzliche Checks halten das Ergebnis ehrlich: Stellen Sie sicher, dass die Änderung nicht siteweit ist und dass das Timing passt (beginnt kurz nach der Platzierung und bleibt erhöht).

Beispiel-Szenario: Wirkung für eine Seite in 3 Wochen nachweisen

Ein SaaS-Unternehmen hat eine Feature-Seite, die gut konvertiert, aber noch wenig organischen Traffic bekommt. Sie fügen drei neue Backlinks direkt auf diese Seite. Sie wollen einen Beleg, dass sich etwas verändert hat, ohne auf Rankings zu warten.

Vor dem Livegang ziehen sie eine Baseline aus den Server-Logs für diese URL: Googlebot-Treffer pro Tag, Zeitlücken zwischen Treffern und welche URLs Googlebot direkt danach besucht.

Woche 1: Innerhalb weniger Tage zeigen die Logs einen Crawl-Anstieg. Wichtiger: Googlebot bleibt nicht bei der Feature-Seite stehen. Er beginnt, tiefer benachbarte Pfade zu erkunden, wie Pricing, Integrationen und unterstützende Artikel. Dieses „Ausfächern“-Verhalten signalisiert oft einen neuen Einstiegspunkt.

Woche 2–3: Die Wiederabrufrate steigt und die Crawl-Lücken werden kleiner. Sie sehen vielleicht mehr 304-Responses (Not Modified), was normal ist, wenn Google öfter nachschaut und der Inhalt sich nicht geändert hat.

Erklären Sie das einem Stakeholder ohne Rankings zu nennen, indem Sie das Verhaltensänderung zeigen: Vorher vs Nachher tägliche Anfragen zur Feature-Seite, mediane Stunden zwischen Besuchen und die häufigsten Next-URLs nach der Feature-Seite.

Wenn die Logs nach 2–3 Wochen keine Änderung zeigen, schließen Sie nicht sofort auf ein Scheitern der Links. Prüfen Sie Blocker (robots.txt, noindex, 4xx/5xx), verstärken Sie interne Verlinkung zur Seite und überlegen Sie, ob das Link-Target eher eine Hub-Seite sein sollte.

Nächste Schritte: Machen Sie Log-Nachweise zu einem wiederholbaren Prozess

Sobald Sie Link-Effekte in Logs validieren können, machen Sie es monatlich zur Routine. Halten Sie ein konsistentes Fenster (z. B. die letzten 30 Tage) und berichten Sie dieselben Metriken jedes Mal: Welche Seiten erhielten die meisten Googlebot-Treffer, wo konzentrierten sich Crawl-Lifts nach Linkarbeiten, wie änderten sich mediane Abruf-Lücken auf Schlüssel-Seiten, welche Pfade tauchten auf oder wurden stärker und welche Fehler verschwendeten Crawl-Budget.

Wenn Sie einen Anbieter wie SEOBoosty (seoboosty.com) nutzen, protokollieren Sie genaue Go-Live-Daten und Ziel-URLs. Sauberes Timing macht Vorher-/Nachher-Log-Vergleiche viel vertrauenswürdiger.

FAQ

Why can logs show progress even when rankings don’t move?

Rankings erfordern erneutes Crawlen, Signalverarbeitung, Index-Aktualisierungen und anschließende Neu-Bewertung der Positionen. Logs sitzen früher in dieser Kette und können daher zeigen, ob Googlebot sein Crawl-Verhalten kurz nach dem Livegang eines Links verändert hat — auch wenn Rank-Tracker noch nichts anzeigen.

What’s the clearest log sign that a new backlink was noticed?

Achten Sie auf einen anhaltenden Anstieg verifizierter Googlebot-Anfragen zur exakt verlinkten URL sowie kürzere Abstände zwischen den Abrufen. Die stärkste Bestätigung ist, wenn Googlebot auf der verlinkten Seite landet und dann konsistent tieferliegende, für Sie wichtige Seiten crawlt.

How long should my “before” and “after” windows be?

Verwenden Sie gleiche Zeitfenster auf beiden Seiten des Go-Live-Datums, üblich sind 14–28 Tage davor und die gleiche Dauer danach. Vergleichen Sie Wochentage gleich, da Crawl-Muster an Wochenenden anders sein können als an Werktagen.

Which logs should I use: origin logs or CDN/WAF logs?

Beginnen Sie mit Origin-Access-Logs, weil sie am ehesten die tatsächlichen Antworten Ihres Servers mit präzisen Statuscodes zeigen. CDN-, WAF- oder Bot-Protection-Logs sind ergänzend nützlich, können aber Requests filtern oder anders kennzeichnen.

How do I make sure “Googlebot” in my logs is actually Google?

Verlassen Sie sich nicht nur auf den User-Agent, da Fake-Bots diesen kopieren. Praktisch ist die Reverse-DNS-Validierung: Die IP sollte auf einen Google-eigenen Hostnamen aufgelöst werden und dieser Hostname wieder auf dieselbe IP zurückauflösen, damit Sie echten Googlebot zählen.

Should I separate Googlebot Smartphone vs Desktop in analysis?

Trennen Sie Googlebot Smartphone und Googlebot Desktop, wenn möglich — sie crawlen oft unterschiedlich, und Änderungen können in einem der beiden zuerst sichtbar werden. Eine kombinierte Ansicht kann echte Verschiebungen verwässern.

How do I tell a real crawl lift from normal noise?

Eine echte Verschiebung ist in der Regel über mehrere Tage anhaltend und konzentriert sich auf die gezielten Seiten, nicht nur auf einen einmaligen Peak. Prüfen Sie außerdem, ob das Timing mit dem Livegang übereinstimmt und ob Ihre Kontrollseite stabil blieb.

Which status codes matter most when judging crawl changes?

Ein 200 bedeutet, dass Googlebot Inhalt erhalten hat, den es bewerten kann — Crawling-Zunahmen sind dann nützlich. Häufige 301s und lange Redirect-Ketten verschwenden Crawl-Budget, 404-Spitzen erzeugen irreführende Aktivität, und 5xx-Fehler können später zu Crawl-Rückgängen führen.

How do I analyze bot paths after the linked page gets crawled?

Verfolgen Sie Einstiegsseiten und was Googlebot kurz nach dem Besuch der verlinkten URL anfragt. Wenn die verlinkte Seite zu einem konsistenten Einstiegspunkt wird und Googlebot anschließend verwandte Seiten (z. B. Pricing, Specs oder unterstützende Inhalte) crawlt, ist das ein starkes Zeichen dafür, dass die Entdeckung verbessert wurde.

What’s the best way to report backlink impact from logs to a stakeholder?

Formulieren Sie pro Ziel-URL einen strengen, testbaren Satz, der Vorher- vs Nachher-Änderung im Abrufvolumen und in der Wiederabruf-Zeit nennt, und fügen Sie eine beobachtete Pfänderung hinzu, falls vorhanden. Wenn Sie einen Anbieter wie SEOBoosty nutzen, protokollieren Sie genaue Go-Live-Daten und Ziel-URLs, damit Ihre Vergleichsfenster sauber bleiben.