Backlinks zu geo-variierenden Seiten: Sorge dafür, dass Googlebot eine einheitliche Seite sieht

Lerne, wie du Backlinks zu geo-variierenden Seiten prüfst, sodass Googlebot stabile Inhalte sieht, deine Canonical-Signale klar bleiben und Link-Equity nicht verwässert wird.

Das Problem: eine URL, unterschiedlicher Inhalt

Eine personalisierte Seite ändert sich je nachdem, wer sie betrachtet. Manchmal ist es nur eine kleine Änderung (eine andere Überschrift für wiederkehrende Besucher). Manchmal ist es groß (ein anderes Angebot, andere Preise oder standortbezogene Details).

Geo-Swapping ist eine häufige Form der Personalisierung. Die URL bleibt gleich, aber der Inhalt ändert sich basierend auf dem Standort des Besuchers, meist ermittelt über IP, Geräteortung oder Browsereinstellungen.

Stell dir eine Service-Seite vor: example.com/plumbing. Jemand in Austin sieht „Plumber in Austin“, eine Austin-Telefonnummer und Austin-Bewertungen. Jemand in Miami ruft dieselbe URL auf und sieht „Plumber in Miami“, eine andere Telefonnummer und andere Testimonials.

Das kann für Nutzer nützlich sein, ist aber riskant für SEO. Google muss entscheiden, worum es auf dieser URL wirklich geht, welche Version indexiert werden soll und welcher Text zur Seitenerkennung verwendet wird. Wenn die Seite stark variiert, kann Google sie als instabil oder unklar einordnen.

Backlinks werden in diesem Setup kompliziert. Links verweisen auf eine URL, aber Googlebot kann eine andere Version crawlen als viele Nutzer sehen oder unterschiedliche Versionen zu verschiedenen Zeiten. Wenn die Seite nicht konsistent ist, können die Signale aus diesen Links verwässert werden, weil Google nicht immer sicher ist, dieselbe Seite zu bewerten.

Das Ziel ist einfach: eine indexierbare Version der Seite, die für Crawler stabil bleibt und zu dem passt, was deine Backlinks unterstützen sollen. Du kannst weiterhin für Nutzer personalisieren, aber die „Kernseite“, die Google indexiert, sollte bei jedem Besuch von Googlebot gleich aussehen.

Wie inkonsistente Seiten Backlink-Wert verschwenden

Backlinks übertragen Wert (oft Link Equity genannt) über eine URL. Damit sich dieser Wert konzentriert, muss Google die URL als eine klare Seite mit einer Hauptabsicht sehen.

Wenn dieselbe URL je nach Standort, Gerät, Cookies oder Tageszeit unterschiedlichen Inhalt zeigt, fällt es Google schwer zu verstehen, worum die Seite wirklich geht. Deine besten Links könnten auf eine Seite zeigen, die instabil wirkt: unterschiedliche Überschriften, anderen Fließtext, verschiedene interne Links oder sogar ein anderes Angebot, je nachdem, wann und wo Googlebot crawlt.

Diese Instabilität kann auch zu Canonical-Verwirrung führen. Du könntest den Canonical auf /services setzen, aber weil der Inhalt ständig wechselt, könnte Google eine stabilere URL (wie /services/nyc) als bessere Repräsentation wählen. Dann unterstützen deine Backlinks eine URL, die du nicht beabsichtigt hast zu ranken.

Anzeichen dafür, dass Linkwert verwässert statt gebündelt wird:

- Rankings stagnieren, obwohl du starke Backlinks erhalten hast

- Der indexierte Title/Snippet ändert sich oft für dieselbe URL

- Google crawlt häufig, aber die Seite gewinnt nicht an Boden

- Manche Standorte ranken, andere bewegen sich nie

Beispiel: Du baust Links zu einer „Plumbing Services“-Seite, aber Nutzer in Chicago sehen „Chicago Plumbing“, während Nutzer in Dallas „Dallas Plumbing“ sehen, mit unterschiedlichen FAQs und Überschriften. Google kann diese Signale dann nicht zu einer starken Seite konsolidieren.

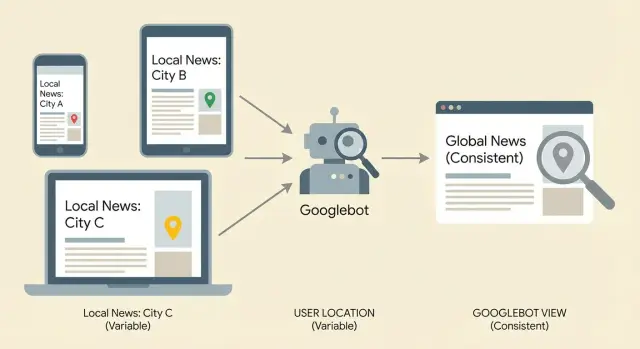

Was Googlebot wahrscheinlich sieht (und warum es variiert)

Wenn Googlebot eine URL besucht, lädt es meist mehr als nur das HTML. Es kann die Seite wie ein Browser rendern (inklusive JavaScript-Änderungen), sie mit früheren Crawls vergleichen und entscheiden, welche Version indexiert wird.

Googlebot crawlt außerdem nicht von einem festen Standort. Google verwendet viele IP-Bereiche und Rechenzentren. Wenn dein Server Inhalte basierend auf IP, Cookies, Headern oder Timing ändert, kann Googlebot unterschiedliche Seitenversionen für dieselbe URL erhalten.

Wiederholte Crawls zeigen oft das Problem. Ein Crawl könnte auf einen warmen Cache treffen und die Standardversion liefern. Ein anderer Crawl Tage später kann einen anderen Edge-Node oder eine andere Geo-Regel treffen und die getauschte Version liefern. Mit der Zeit sieht Google die Abweichungen und indexiert möglicherweise die „falsche“ Version oder behandelt die Seite als instabil.

Häufige Gründe, warum dieselbe URL Googlebot unterschiedlich erscheinen kann:

- IP-basiertes Geo-Swapping (Server ändert die Seite)

- Cookie- oder Login-Personalisierung (Googlebot erhält eine andere „Gast“-Version)

- JavaScript-Änderungen nach dem Laden (gerenderter Inhalt unterscheidet sich vom Roh-HTML)

- A/B-Tests (Inhalt variiert je nach Anfrage)

- CDN-/Cache-Abweichungen (verschiedene Edge-Regeln, verschiedene Ausgaben)

Wenn du Backlinks auf geo-variierende Seiten aufbaust, ist der sicherste Ansatz, die Crawler-Version langweilig und konsistent zu machen, selbst wenn Nutzer leichte Anpassungen sehen.

Schritt für Schritt: Bestätige, dass die Seite für Crawler stabil ist

Beginne damit, eine URL auszuwählen, die jeder Backlink stärken soll. Wenn du mehrere Versionen hast (Stadtseiten, Parameter, alternative Pfade), wähle die, die du tatsächlich ranken möchtest, und behandle alles andere als unterstützend.

Prüfe dann, was ein „neutraler“ Besucher sieht. Nutze ein privates Fenster, bleibe ausgeloggt und lehne Standortberechtigungen ab. Wenn deine Seite Sprache oder Währung nach Browsereinstellungen ändert, setze diese auf eine schlichte Standard-Option und lade die Seite neu.

Vergleiche das mit dem, was ein Crawler wahrscheinlich bekommt. Nutze einen Crawler, der sich als Googlebot ausweist, oder die Fetch-Funktion deiner SEO-Plattform (z. B. die URL-Prüfung in der Search Console), um das gerenderte HTML und die Ressourcen zu sehen.

Eine Routine, die die meisten Geo-Swaps erkennt:

- Lade die URL in einer neutralen Sitzung und speichere den sichtbaren Text.

- Lade sie erneut aus mindestens zwei verschiedenen Regionen (VPN oder Remote-Browser).

- Hole die URL als Bot und erfasse die gerenderte Ausgabe.

- Vergleiche Title, H1, Haupttext und primäre interne Links.

Konzentriere dich auf Änderungen, die verändern, worum es auf der Seite geht. Wenn Stadtnamen, Leistungsumfang, Preise oder Produktverfügbarkeit wechseln, kann Google die URL als inkonsistent behandeln. Kleine UI-Änderungen (wie eine lokale Telefonnummer im Header) sind in der Regel weniger riskant.

Signale, die du prüfen solltest: Weiterleitungen, Statuscodes, Canonicals

Geo-Swapping bricht oft Linkwert, weil dieselbe URL sich je nach Besucher unterschiedlich verhält. Das kann Signale auf mehrere URLs aufteilen oder widersprüchliche Anweisungen an Crawler senden.

Beginne mit Weiterleitungen. Eine Weiterleitung, die sich nach Land, Bundesstaat oder Sprache ändert, ist ein Warnsignal, außer du meinst es sehr bewusst. Teste dieselbe URL aus verschiedenen Standorten oder Spracheinstellungen und notiere, wo sie landet.

Bestätige dann, dass der Statuscode stabil ist. Eine Seite, die manchmal 200 und manchmal 302 (oder schlimmer, 404) zurückgibt, kann Linkwert verlieren, weil Crawler sie als unzuverlässig ansehen.

Auf der Seite, die Google letztlich indexieren soll, überprüfe:

- Die Antwort ist konstant 200.

- Jede Weiterleitung ist konsistent und endet bei einer vorgesehenen URL.

- Der Canonical-Tag zeigt immer auf dieselbe beabsichtigte URL.

- Weiterleitungsziele und Canonicals stimmen überein (kein „Canonical zu A“, aber „Redirect zu B“).

- Parameter (wie

?city=,?lang=, Tracking-Tags) erzeugen keine mehrfach indexierbaren Versionen.

Canonicals sind besonders wichtig bei personalisierten Seiten. Wenn der Canonical je nach Standort, Gerät oder Cookie wechselt, sagst du Google, dass verschiedene Versionen jeweils „die echte“ sind — das verwässert die Signale.

Personalisierung, ohne dass es eine andere Seite wird

Wenn dieselbe URL Googlebot deutlich anderes HTML zeigt als realen Nutzern, riskierst du mehr als nur „verwirrende Signale“. Es kann wie Cloaking wirken und dazu führen, dass Google eine eigentlich einzelne Seite als mehrere Versionen behandelt.

Ein sichereres Ziel: Bewahre die Kernbotschaft für alle gleich und personalisiere nur am Rand. Denke an „hilfreiche Hinweise“, nicht an „eine andere Seite“. Du kannst zum Beispiel die Stadt des Besuchers erkennen und in einem kleinen Banner „Heute in Austin aktiv“ anzeigen, während H1, Kernabsätze, Preise und interne Links gleich bleiben.

Ein praktisches Muster ist, kritische Inhalte im initialen HTML zu belassen und kleine Standorthinweise nach dem Laden hinzuzufügen. So erhält Googlebot weiterhin eine stabile, indexierbare Seite, und Nutzer bekommen trotzdem ein lokales Gefühl.

Sichere Personalisierungs-Checkliste

Personalisierung nicht-kritisch halten:

- Hauptüberschrift, Hauptangebot und Kerntext konsistent halten.

- Interne Links und Navigation standortübergreifend konsistent halten.

- Kleine Abschnitte personalisieren (Banner, Sidebar, Reihenfolge von Testimonials), nicht das Hauptangebot.

- Vermeide das Austauschen ganzer Keyword-fokussierter Textblöcke per IP.

- Stelle sicher, dass wichtiger Text nicht nur in Skripten steckt, die eventuell nicht gerendert werden.

JavaScript ist nicht automatisch „schlecht“, aber es ist ein häufiger Fehlerpunkt. Wenn dein Haupttext oder Calls-to-Action erst nach Ausführung eines Skripts erscheinen, kann eine Rendering-Verzögerung oder eine blockierte Ressource Googlebot eine dünne Version der Seite liefern.

Geo-Targeting-Muster, die besser funktionieren

Wenn sich Inhalte wirklich nach Region unterscheiden, sind separate URLs meist sicherer, als Inhalte innerhalb einer URL zu tauschen. Googlebot kann dann ein konsistentes Dokument crawlen, und deine Links verweisen auf etwas, das nicht „Form ändert“.

Separate regionale Seiten lohnen sich, wenn es echte Unterschiede gibt: Preise, rechtliche Bedingungen, Versandregeln, Filialstandorte oder Sprache. Wenn es nur eine kleine Begrüßung ist, behalte eine Seite und verzichte auf Geo-Logik.

Ein Muster, das oft gut funktioniert:

- Eine Hauptversion, die für alle zugänglich ist und zuverlässig von Google gecrawlt werden kann

- Dedizierte URLs für größere Regionen oder Sprachen (z. B.

/en/und/fr/) - Eine sichtbare Option für Nutzer, die Region selbst zu wechseln

- Optionale Erkennung, die eine bessere Version vorschlägt, ohne zu zwingen

Wie hreflang passt

Hreflang-Annotationen sagen Suchmaschinen, welche Seite für welche Sprache oder Region gedacht ist und helfen, die richtige Version in den Ergebnissen zu zeigen. Verwende sie, wenn du mehrere sehr ähnliche Versionen hast, die für unterschiedliche Zielgruppen gedacht sind (z. B. English US vs English UK oder English vs Spanish). Es ist kein Ranking-Boost an sich, reduziert aber die Chance, dass die falsche Version angezeigt wird.

Ein häufiger Fehler ist, Besucher aufgrund ihrer IP auf eine andere URL zu zwingen. Das kann Googlebot blockieren, Nutzer mit VPNs verwirren und Signale verwässern, wenn manche Links auf eine URL zeigen, die Leute sofort woandershin weiterleitet.

Häufige Fallen, die still Link-Equity zerstören

Die meisten Probleme mit geo-variierenden Seiten sind keine offensichtlichen Fehler. Die Seite lädt im Browser einwandfrei, aber Googlebot sieht etwas anderes oder mehrere Versionen über verschiedene Crawls.

Edge-Logik ist ein häufiger Verursacher. Ein CDN oder Proxy kann Inhalte basierend auf IP-Standort, Headern oder Gerät umschreiben. Wenn der Edge H1, interne Links oder Body-Text tauscht, während die URL gleich bleibt, kann Google die Seite bei jedem Besuch anders behandeln.

Weitere Fallen, die still Schaden anrichten:

- A/B-Tests, die Bots einschließen, sodass Googlebot rotierende Titles oder Überschriften sieht

- Geo-Redirect-Loops (oder -Ketten), bei denen Crawler keine konsistente finale Seite erreichen

- Mehrere Canonical-Tags, die aus widersprüchlichen Templates oder Plugins kommen

- Standort-Query-Strings wie

?city=, die indexiert werden und Nahe-Duplikate erzeugen

Wenn du in Linkbuilding investierst, können diese Probleme starke Links in schwächere Signale verwandeln. Behebe zuerst die Auslieferung, dann skaliere.

Schnellchecks, bevor du mehr Backlinks setzt

Bevor du neue Backlinks auf eine geo-variierende URL richtest, stelle sicher, dass Googlebot eine stabile Version der Seite sehen kann. Wenn du dasselbe Ergebnis nicht zweimal reproduzieren kannst, spielst du mit dem Link-Equity.

Prüfe die Seite aus ein paar Standorten (und mit Standort-Einstellungen aus/anz) und bestätige, dass folgende Elemente im Wesentlichen konsistent bleiben:

- Title-Tag und Meta-Description (kleine Anpassungen sind okay, aber kein neues Thema)

- Eine klare H1, die zum Zweck der Seite passt

- Haupttext (tausche nicht das gesamte Angebot oder die Serviceliste aus)

- Interne Links im Hauptinhalt (gleiche Ziele, gleiche Struktur)

- Wichtige strukturierte Elemente wie FAQs oder Produkt-/Serviceblöcke

Dann mache einen kurzen technischen Check:

- Die finale Seite gibt einen 200-Status zurück (keine Redirect-Kette)

- Keine automatische IP-Weiterleitung, die Crawler an eine andere Stadt/Land-URL schickt

- Du prüfst die gerenderte Seite, nicht nur das Roh-HTML

- Du kannst die gleiche gerenderte Ausgabe bei Wiederholungen reproduzieren

Führe ein einfaches Logbuch: Zeitstempel, Standort/Testmethode, finale URL, Statuscode, Canonical und was sich geändert hat (falls etwas). So lässt sich nach Deploys oder Änderungen schnell nachprüfen.

Beispiel: Eine lokale Service-Seite mit stadtbasiertem Tausch

Ein gängiges Setup: eine URL wie /services/plumbing, bei der Geo-Erkennung den Stadtnamen, die Telefonnummer und Testimonials tauscht. Austin-Besucher sehen „Austin emergency plumber“ mit Austin-Bewertungen. Dallas-Besucher sehen „Dallas emergency plumber“ mit Dallas-Bewertungen.

Fügst du nun Backlinks hinzu, verlinkt ein Partner auf diese eine URL. Der Link bürgt damit für das, was Googlebot beim Crawl sieht. Wenn Googlebot manchmal Austin und manchmal Dallas sieht (oder eine generische Version), ist das Ziel nicht stabil.

Die Lösung besteht darin, zu entscheiden, was gleich bleiben muss und was sicher geändert werden kann. In den meisten Fällen bleibt der Kern stabil: Leistungsbeschreibung, Preisstruktur, Vertrauenssignale und die Hauptüberschrift sollten nicht zwischen Städten wechseln. Personalisiere kleine UI-Elemente, die die Bedeutung nicht verändern.

Eine praktische Behebung ist eine stabile Kernseite plus ein optionales Standort-Modul:

- Behalte eine kanonische Service-Seite mit demselben Haupttext für alle

- Füge ein kleines Standort-Banner hinzu, das auf Nutzerwahl basiert

- Lade lokale Testimonials in ein klar getrenntes Modul (und begrenze, wie viel Text es hinzufügt)

- Wenn du echte Stadseiten brauchst, erstelle separate URLs pro Stadt und verlinke auf diese

Erfolg sieht so aus: Crawls zeigen bei jedem Mal dasselbe Haupt-HTML, der Canonical ist konsistent und der indexierte Snippet wechselt nicht mehr zwischen Städten.

Nächste Schritte: Seite sichern, dann Links aufbauen

Sobald du bestätigt hast, was Googlebot sieht, behandle diese Version als die offizielle Seite und schütze sie. Geo-Swapping kann nach einem Deploy, einer CDN-Regeländerung oder einem scheinbar harmlosen A/B-Test wieder einschleichen.

Überprüfe direkt nach Releases und nochmal 24–48 Stunden später, wenn Caches sich aufgeheizt haben. Vergleiche Statuscode, finale URL, Canonical und Hauptinhalt gegen deine letzte Basislinie.

Skaliere Linkaufbau nur, wenn das Ziel stabil ist. Andernfalls können Backlinks zu geo-variierenden Seiten auf mehrere Varianten landen und Link-Equity über ungewollte Versionen verteilen.

Wenn du eine verwaltete Link-Quelle nutzt, ist Stabilität noch wichtiger, weil du Autorität gezielt auf eine URL konzentrieren willst. Zum Beispiel fokussiert SEOBoosty (seoboosty.com) darauf, Backlink-Platzierungen auf autoritativen Seiten zu sichern — es lohnt sich also, das Ziel vorher zu validieren, damit diese Signale sich konsolidieren statt sich über getauschte Varianten zu verteilen.

Behebe zuerst die Auslieferung, dann verdiene und verfolge Backlinks.

FAQ

Warum sind Backlinks riskant, wenn dieselbe URL je nach Standort unterschiedliche Inhalte zeigt?

Wähle eine URL, die du wirklich ranken lassen willst, und stelle sicher, dass diese URL Googlebot bei jedem Crawl dieselbe Kernauslieferung liefert. Du kannst kleinere UI-Elemente für Nutzer personalisieren, aber die indexierte Version sollte über Crawls stabil bleiben, damit Backlink-Signale sich bündeln und nicht aufgespalten werden.

Was bedeutet es, wenn Link-Equity auf einer geo-variierenden Seite „verwässert“ wird?

Backlinks stärken eine URL als eine Einheit, und Google muss diese URL als eine klare Seite mit einem Hauptthema verstehen. Wenn Title, H1, Body-Text oder interne Links zwischen Besuchen stark variieren, kann Google die Seite als instabil ansehen und der Wert der Links wird verwässert.

Wie kann ich schnell erkennen, ob Googlebot eine andere Version sieht als Nutzer?

Teste wiederholt unter neutralen und variierenden Bedingungen und vergleiche die Ergebnisse. Lade die Seite im privaten Fenster aus eingeloggt-freiem Zustand, lade sie aus mindestens zwei Regionen und hole die gerenderte Version als Bot. Wenn sich Haupttext und Zweck ändern, ist die Seite für Crawler nicht stabil.

Welche Seitenelemente sind für SEO-Stabilität auf personalisierten Seiten am wichtigsten?

Konzentriere dich auf die inhaltlich entscheidenden Elemente: Title-Tag, H1, Haupttext, primäre interne Links und wichtige Blöcke wie FAQs oder Service-Listen. Kleine Änderungen wie eine lokale Telefonnummer im Header sind normalerweise weniger riskant als das Ersetzen des Stadtnamens im H1 und das Umschreiben des gesamten Angebots.

Warum sieht Googlebot bei unterschiedlichen Crawls manchmal verschiedene Inhalte?

Googlebot crawlt nicht von einem festen Ort und rendert oft JavaScript. Wenn dein Server, CDN, Cache, A/B-Test oder Skripte je nach IP, Cookies, Headern oder Timing unterschiedlich ausgeben, kann Googlebot bei verschiedenen Crawls verschiedene Seitenversionen erhalten.

Welche Redirect- und Canonical-Fehler brechen häufig das Backlink-Value bei geo-variierenden URLs?

Stelle sicher, dass die finale Seite konsistent einen 200-Status zurückgibt und auf eine einzige beabsichtigte URL aufgelöst wird, ohne standortbasierte Redirect-Variationen. Bestätige außerdem, dass der Canonical-Tag immer auf dieselbe URL zeigt; wenn Redirects oder Canonicals je nach Standort oder Cookie variieren, sendest du gemischte Signale, die Ranking-Kredit trennen können.

Wie personalisiere ich eine Seite, ohne dass sie für SEO zu einer anderen Seite wird?

Halte die Kernbotschaft für alle gleich und personalisiere nur am Rand. Eine praktische Methode ist, kritische Inhalte im initialen HTML zu belassen und kleine Standorthinweise nach dem Laden einzufügen, sodass Crawler immer eine stabile Seite sehen, während Nutzer trotzdem eine angepasste Erfahrung bekommen.

Wann sollte ich separate regionale URLs statt einer geo-variierenden URL verwenden?

Wenn sich der Inhalt je nach Region wirklich unterscheidet, sind separate URLs meist sicherer als Inhalte innerhalb einer URL zu tauschen. Erstelle dedizierte regionale oder sprachliche Seiten, biete Nutzern eine sichtbare Umschaltmöglichkeit an und verwende hreflang, wenn du nahe beieinander liegende Varianten für unterschiedliche Zielgruppen hast.

Was ist hreflang und wann hilft es bei geo-targeted Seiten?

Hreflang hilft, wenn du mehrere sehr ähnliche Versionen hast, die für verschiedene Sprachen oder Regionen gedacht sind (z. B. Englisch US vs. Englisch UK). Hreflang erhöht die Rankings nicht direkt, reduziert aber die Wahrscheinlichkeit, dass die falsche Version in den Suchergebnissen angezeigt wird.

Was sollte ich prüfen, bevor ich mehr Backlinks zu einer geo-variierenden Seite baue?

Baue keine neuen Links, bis das Ziel wiederholt stabil ist. Überprüfe aus mehreren Regionen, bestätige die finale URL, den Statuscode, den Canonical und den gerenderten Hauptinhalt gegen deine Basislinie, und skaliere erst dann Linkbuilding; ansonsten können selbst hochwertige Links unterschiedliche Varianten unterstützen statt eine starke Seite.