Backlinks für JavaScript‑starke Seiten: Rendering‑ und Index‑Checks

Backlinks für JavaScript‑starke Seiten: wie du sicherstellst, dass Inhalt gerendert wird, indexiert werden kann und Render‑Tests besteht, damit Autorität an die richtigen URLs fließt.

Das zentrale Problem bei JavaScript‑lastigen Backlink‑Zielen

Eine JavaScript‑starke Seite kann im Chrome perfekt aussehen und trotzdem ein schwaches SEO‑Ziel sein. Dein Browser führt Skripte schnell aus und füllt den Inhalt nach. Crawler beginnen oft mit einer früheren, leereren Version der Seite und rendern nicht immer sofort alles.

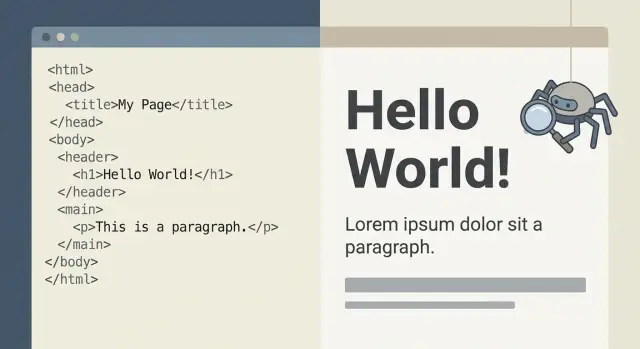

Bei vielen Sites ist die erste HTML‑Antwort im Grunde nur eine Schale: ein Header, ein paar leere Container und einige Script‑Tags. Die eigentliche Seite (Preistabellen, Feature‑Listen, FAQs) erscheint erst, nachdem JavaScript läuft und zusätzliche Anfragen ausgeführt werden. Wenn in dieser Kette etwas langsam ist oder blockiert wird, bekommt der Crawler den kompletten Inhalt möglicherweise nicht, oder er entscheidet, die Seite sei nicht indexierungswürdig.

Genau hier können Backlinks für JavaScript‑lastige Seiten still und leise an Wert verlieren. Der Link zeigt auf eine URL, die Nutzer lieben, aber Suchmaschinen behandeln sie vielleicht als „dünn“, weil der wichtige Text beim Crawlen nicht zuverlässig sichtbar ist.

Ein einfaches Denkmodell hilft:

- Browser‑Ansicht: führt Skripte aus, wartet und zeigt dann die finale Version.

- Crawler‑Ansicht: holt zuerst die initiale HTML, rendert später und kann Zeitüberschreitungen oder Auslassungen haben.

- SEO‑Ansicht: bewertet, was konstant als Text und Links sichtbar ist.

- Backlink‑Ansicht: überträgt Autorität auf die gewählte URL, selbst wenn der Crawler diese URL für inhaltsarm hält.

Diese Lücke erzeugt vorhersehbare Fehlerfälle. Ein Backlink landet auf einer Seite, die unerwartet weiterleitet, zu lange einen Loader zeigt, Text hinter Login‑ oder Cookie‑Walls versteckt oder wichtige Abschnitte erst nach Nutzerinteraktion offenbart.

Wie Google JavaScript‑Seiten sieht (einfach erklärt)

Wenn Googlebot eine Seite besucht, lädt er zuerst die erste Serverantwort: die initiale HTML.

Wenn diese HTML bereits den Haupttext, Überschriften, interne Links und wichtige Metadaten enthält, kann Google die Seite schnell verstehen. Ist die HTML dagegen größtenteils eine Schale (z. B. ein div und ein Script‑Tag), muss Google zusätzliche Arbeit leisten.

Diese Zusatzarbeit ist Rendering. Google führt das JavaScript der Seite aus (in einer vereinfachten, crawler‑freundlichen Umgebung), damit Inhalte erscheinen können. Rendering ist nicht immer unmittelbar und kann unvollständig sein, wenn das Setup von Dingen abhängt, die nicht zuverlässig laden.

Rendering verzögert sich oder ist oft unvollständig, wenn:

- Die Seite mehrere API‑Aufrufe braucht, bevor Inhalte erscheinen.

- Inhalte erst nach Aktionen wie Klicks, Scrolls oder dem Schließen von Bannern sichtbar werden.

- Wichtiger Text spät von clientseitigen Skripten eingefügt wird.

- Ressourcen, die Google braucht, blockiert sind (Skripte, CSS, JSON).

- Canonicals oder Redirects sich nach dem Ausführen von Skripten ändern.

Warum das für Backlinks auf JavaScript‑Seiten wichtig ist: Ein Backlink kann nur vollen Wert an eine Seite weitergeben, die Google zuverlässig abrufen, rendern und verstehen kann. Wenn Google meist nur eine leere Schale sieht, wirkt dein Link möglicherweise auf eine URL, die dem Crawler inhaltsarm erscheint.

Eine Seite kann heute noch etwas ranken (besonders für Brand‑Begriffe oder bei geringer Konkurrenz), obwohl Rendering‑Lücken bestehen. Wenn du später stärkere Links hinzufügst, können diese teilweise verloren gehen, wenn Google den Inhalt nicht zuverlässig erkennt.

Eine praktische Faustregel: Google hat zwei Chancen, deine Seite zu verstehen — zuerst aus der Roh‑HTML, dann aus der gerenderten Version. Wenn dein wichtigster Inhalt nur im zweiten Schritt existiert, verlässt du dich auf einen langsameren und weniger vorhersehbaren Prozess.

Wähle die richtige URL, bevor du einen Backlink setzt

Ein Backlink hilft nur der exakt adressierten URL. Auf JavaScript‑Seiten kann „die Seite“ mehrere Versionen haben, die für Menschen gleich aussehen, für Google aber unterschiedlich funktionieren. Wählst du die falsche, sendest du Autorität vielleicht an eine Weiterleitung, eine leere Schale oder eine URL, die deine App nächste Woche ändert.

Beginne damit, die einzelne URL aufzuschreiben, die du stärken willst — zeichengetreu. Kleine Unterschiede (ein abschließender Slash, ein Parameter, ein Hash) können beeinflussen, welche Inhalte geladen werden oder ob überhaupt etwas Sinnvolles geladen wird.

Wähle ein stabiles, crawlbares Ziel

Entscheide dich für eine URL, die die Schlüssel‑Inhalte zeigt, ohne dass Klicks, Logins, Consent‑Walls oder clientseitige Schritte wie „Wähle einen Plan, um Preise zu sehen“ nötig sind. Wenn Inhalte erst nach einer Nutzeraktion erscheinen, sieht Google sie möglicherweise nicht zuverlässig.

Vor der Freigabe des Ziels mach einen schnellen Reality‑Check:

- Lade die URL in einem sauberen Browserfenster und bestätige, dass der Haupttext ohne Interaktion erscheint.

- Stelle sicher, dass sie nicht durch mehrere Weiterleitungen springt.

- Entferne Tracking‑Parameter und vergleiche, ob die Seite gleich bleibt.

- Standardisiere das Format (www vs non‑www, http vs https, mit oder ohne trailing slash).

- Vermeide fragmentbasierte URLs (alles nach #) als SEO‑Ziele.

Stimme das Canonical auf deine gewählte URL ab

Auch wenn eine Seite korrekt lädt, kann das Canonical auf etwas anderes zeigen. Das ist Googles Hinweis auf „das ist die Hauptversion“. Wenn dein Backlink auf eine URL zeigt, die kanonisch auf eine andere verweist, bittest du Google effektiv, Wert von deinem gewählten Ziel wegzuleiten.

Einfache Regel: Die URL, die du verwenden willst, sollte exakt mit dem Canonical übereinstimmen und der Version entsprechen, die deine internen Links am häufigsten nutzen.

Beispiel: Wenn /pricing?plan=pro auf /pricing/ kanonisiert, setze den Backlink auf /pricing/. Andernfalls baust du Autorität für eine URL auf, die deine Site nicht als Hauptseite behandelt.

Schritt‑für‑Schritt: Führe einen Render‑Test durch und vergleiche Ausgaben

Wenn du Backlinks für JavaScript‑lastige Seiten aufbaust, nimm nicht an, dass Google sieht, was du im Browser siehst. Führe einen Render‑Test durch und vergleiche, was vor dem Ausführen von Skripten geladen wird und was danach erscheint.

1) Erfasse das, was du indexiert haben willst

Öffne die Seite in einem normalen Browserfenster (nicht eingeloggt). Bestimme die genauen Teile, die ein Backlink unterstützen soll: die Hauptüberschrift, den Schlüsselabsatz, primäre Produktdetails und die wichtigsten internen Links.

Halte es einfach: Schreib 3–5 Must‑Show‑Elemente auf, z. B. H1, einen Schlüsselabsatz, Plan‑Namen oder Feature‑Texte und die wichtigsten internen Links.

Dann erstelle zwei Snapshots:

-

Ansicht Quelltext (initiale HTML) und kopiere einen kleinen Body‑Ausschnitt, wo der Hauptinhalt erscheinen sollte.

-

Speicher die vollständig geladene HTML aus dem Browser (z. B. aus den DevTools), um sie später zu vergleichen.

2) Führe einen Google‑Render‑Test aus und sichere, was Google sieht

Nutze ein Tool, das zeigt, was Googlebot rendert (z. B. eine Live‑URL‑Prüfung in der Search Console). Sichere den gerenderten HTML‑Ausschnitt rund um den Hauptinhalt und den Screenshot. Das ist deine Basislinie.

3) Vergleiche initiale HTML vs. gerenderte HTML

Ziel ist nicht Perfektion, sondern Vertrauen, dass die wichtigen Inhalte zuverlässig sichtbar sind.

Prüfe:

- Ist der Haupttext in der initialen HTML vorhanden oder nur nach Ausführung von Skripten?

- Enthält die gerenderte HTML dieselben Überschriften und Absätze, die du notiert hast?

- Fehlen wichtige Details, außer du scrollst, klickst einen Tab oder öffnest ein Accordion?

- Hängt etwas von Login, Cookies oder einem Standortwähler ab?

Wenn Must‑Show‑Elemente erst nach Interaktion erscheinen, behandle die Seite als riskantes Backlink‑Ziel.

4) Wiederhole im Mobil‑View

Wenn möglich, wiederhole das Rendern mit einem mobilen User‑Agent (oder überprüfe zumindest den mobilen Screenshot). Viele JavaScript‑Probleme zeigen sich nur mobil: verzögerte Inhalte, versteckte Abschnitte oder andere Templates.

Ein gutes Ergebnis ist langweilig: Screenshot und Erwartung stimmen überein und der Hauptinhalt erscheint ohne Klicks, Logins oder Blocker.

Kurze Inhaltschecks: Ist der wichtige Text wirklich da?

Bevor du Backlinks für JavaScript‑lastige Seiten auf eine URL setzt, stell sicher, dass die Seite echten, lesbaren Inhalt in der HTML enthält, den Google zuverlässig sehen kann. Wenn Schlüsseltext erst nach Script‑Ausführung erscheint, kannst du zwar einen starken Link gewinnen, der aber Autorität an eine Seite schickt, die Google als dünn betrachtet.

Beginne mit den Basics: Öffne "Seitenquelltext" (nicht das inspekte DOM) und suche nach dem Title‑Tag, einem klaren H1 und dem Haupttext, den Nutzer lesen sollen. Fehlen diese Teile in der initialen HTML, hängt die Seite wahrscheinlich vom clientseitigen Rendering und späten Datenabrufen ab.

Ein schneller Hinweis auf Probleme sind Shell‑Seiten: viel Markup, aber wenig Substanz. Häufige Zeichen sind große Blöcke leerer divs, Lade‑Spinner oder Platzhaltertext dort, wo Preise, Produktbeschreibungen oder FAQs stehen sollten.

Inhalte‑Signale, die du prüfen solltest:

- Ein themenspezifisches Title‑Tag (nicht nur ein generischer App‑Name)

- Eine sichtbare H1, die zur Seiten‑Absicht passt

- Kernabsatztext als realer Text (nicht spät injiziert)

- Navigation und Breadcrumbs lesbar und konsistent

- Wichtige Copy nicht in Bildern oder Canvas eingebettet

Navigation ist wichtig, weil Google sie für Kontext nutzt. Wenn Kategorieseiten, Header‑Navigation oder Breadcrumbs erst nach Skripten erscheinen, können Crawler Beziehungen zwischen Seiten verpassen und dein Backlink hilft womöglich nicht der Seite, die du meinst.

Achte auch auf „Text, der kein Text ist“. Eine Headline in einem Hero‑Bild kann toll aussehen, bringt aber kaum indexierbaren Inhalt.

Indexierungsprüfungen, die vor dem Backlink zählen

Ein Backlink hilft nur, wenn Google die Seite indexieren darf und sie verstehen kann. Bei JavaScript‑lastigen Sites kann eine Seite im Browser gut aussehen, aber trotzdem schwer zu indexieren sein oder still signalisieren „nicht indexieren".

Beginne mit Index‑Erlaubnis‑Signalen. Prüfe Quelltext und Response‑Header auf ein robots‑Meta‑Tag und jeden X‑Robots‑Tag‑Header. Ein einziges noindex (manchmal durch Staging‑Konfigurationen oder cookie‑abhängige Varianten hinzugefügt) kann Backlinks sinnlos machen.

Bestätige als Nächstes, dass das Canonical selbstreferenziell und stabil ist. Wenn das Canonical auf eine andere URL zeigt (eine Kategorieseite, eine lokalisierte Version oder eine tracking‑freie Variante), kann deine Link‑Equity irgendwo anders gutgeschrieben werden.

Statuscodes sind eine weitere stille Falle. Die erste HTML‑Antwort mag 200 sein, aber nach dem Rendern kann die App in einen Fehlerzustand, eine „nicht gefunden“ Ansicht oder eine Login‑Wall wechseln. Google kann das wie ein Soft‑404 behandeln. Wenn du einen Render‑Check durchführst, verifiziere, dass die gerenderte Version weiterhin den Content zeigt, auf dem Nutzer landen sollen.

Wenn du auf strukturierte Daten (FAQ, Product, Breadcrumb) angewiesen bist, stell sicher, dass sie in der gerenderten Ausgabe vorhanden sind, die Google sieht. Wenn Markup spät injiziert wird oder nur für bestimmte Nutzer erscheint, wird es möglicherweise nicht erfasst.

Beobachte außerdem Pagination und facettierte Navigation. Ein Backlink, der auf eine gefilterte URL verweist, kann Autorität an eine weniger wertige Variante statt an deine Hauptseite schicken.

Kurze Pre‑Flight Checks bevor du ein Ziel freigibst:

- Kein

noindexim Meta Robots und kein X‑Robots‑Tag Header - Canonical weist genau auf die URL, die du ranken willst

- Die gerenderte Seite zeigt den Hauptinhalt (nicht einen leeren oder Fehlerzustand)

- Strukturierte Daten erscheinen nach dem Render (falls relevant)

- Vermeide parameterreiche Filtervarianten, außer die Variante ist bewusst gewollt

Beispiel: Du willst eine Premium‑Platzierung auf /pricing?plan=pro setzen. Wenn das Canonical auf /pricing zeigt und die gerenderte Seite Preise hinter einem Region‑Selector versteckt, landet der Backlink‑Wert nicht dort, wo du es erwartest. Behebe zuerst das Ziel, dann setze den Link.

Häufige Fehler, die Backlink‑Wert auf JS‑Sites verschwenden

Der schnellste Weg, einen guten Backlink zu verschwenden, ist, ihn auf eine Seite zu setzen, deren echter Inhalt Google nicht zuverlässig sieht. Bei JavaScript‑starken Sites entscheiden kleine Implementierungsentscheidungen, ob Google eine starke Zielseite sieht oder eine größtenteils leere Schale.

Ein häufiger Fehler ist, dass Inhalte nur nach Nutzeraktionen erscheinen. Laden sich Kerntexte erst nach dem Klicken eines Tabs, dem Öffnen eines Accordions oder der Wahl eines Plans, kann Google eine Version indexieren, die die Verkaufsargumente nicht enthält.

Ein weiterer Verlustpunkt ist das Verlinken auf eine URL, die später weiterleitet. Ein Backlink auf eine Kampagnen‑URL, die per 301 auf die generische Startseite verweist, kann Relevanz verwässern oder Wert an die falsche Seite übertragen. Redirects sind nicht per se schlecht, Überraschungen jedoch.

Wiederkehrende Fehler:

- Verlinkung auf Seiten, die von robots.txt blockiert oder auf

noindexgesetzt sind - Nutzung von Hash‑Routen (wie

/#/pricing), bei denen der sinnvolle Pfad nicht konsistent indexierbar ist - A/B‑Tests, die Kerninhalte so verändern, dass Google und Nutzer unterschiedliche Überschriften oder Copy sehen

- Verlinken auf URLs mit Tracking‑Parametern, die Duplikate erzeugen

- Rendering so spät, dass Schlüsseltexte fehlen, wenn Google die Seite erfasst

Ein einfaches Szenario: Eine React‑Pricing‑Seite zeigt nur einen Spinner, bis ein Pricing‑API‑Call zurückkommt. Bei langsamer Antwort erfasst der gerenderte Snapshot vielleicht nur Spinner und Header, aber nicht die Plan‑Details. Aus Sicht von Google ist das ein schwaches Dokument.

Pre‑Backlink‑Checkliste (schnelle Ja/Nein‑Prüfung)

Bevor du Backlinks auf JavaScript‑lastige Seiten setzt, beantworte eine Frage: Wird Google zuverlässig den Inhalt sehen, den dein Link unterstützen soll?

Nutze diese Ja/Nein‑Checks. Bei einem „Nein“ behebe das Problem zuerst oder wähle ein anderes Ziel.

- Zeigt die rohe HTML echten Inhalt? In „Seitenquelltext“ solltest du ein aussagekräftiges Title‑Tag und mindestens eine kurze Zusammenfassung der Seite sehen.

- Entspricht die gerenderte Ausgabe dem, was Nutzer sehen? In einem Rendering‑Test sollten Überschriften und Kerncopy ohne Klicks erscheinen.

- Ist der Zugriff stabil ohne Klicks, Cookies oder Popups? Die Seite sollte in einem sauberen Browser gleich laden.

- Stimmen Signale überein? Canonical, Robots und (falls genutzt) hreflang sollten dieselbe URL unterstützen.

- Wird die URL in 3–6 Monaten noch existieren? Vermeide kurzlebige Kampagnen‑URLs und instabile Parameter‑Varianten.

Beispiel: Wenn deine React‑/pricing‑Seite Preise erst nach einer Animation zeigt, kann ein Render‑Test zeigen, dass Google die Seite vor dem Erscheinen der Inhalte erfasst. In dem Fall verlinke auf eine statischere Pricing‑Übersichtsseite oder passe das Rendering so an, dass Kerntexte sofort in der initialen HTML verfügbar sind.

Beispiel: Eine React‑Pricing‑Seite, die spät rendert

Stell dir eine SaaS‑Site mit einer React‑Pricing‑Seite vor. Die URL sieht perfekt für einen Backlink aus, weil sie hohe Conversion‑Intent hat. Der Haken: Die Plan‑Cards (Starter, Pro, Enterprise) laden erst aus einer API, nachdem die Seite gebootet ist.

Im Browser siehst du saubere Karten mit Preisen, Features und einem „Start trial“‑Button. Die initiale HTML ist jedoch größtenteils eine Schale: ein Title, leere divs und ein Script‑Bundle. Die Plan‑Details erscheinen erst, nachdem JavaScript läuft und der API‑Call abgeschlossen ist.

Ein Google‑Render‑Test macht das Problem deutlich. In der gerenderten HTML fehlen wichtige Plantexte oder sind unvollständig. Manchmal sieht man nur Platzhalter wie „Loading…“ oder leere Container. Das bedeutet, ein Crawler sieht vielleicht nicht zuverlässig, was Nutzer sehen, besonders wenn Rendering verzögert, blockiert oder inkonsistent ist.

Hier verlieren Backlinks an Wert. Du kannst einen starken Backlink auf die Pricing‑URL setzen, aber wenn Google die Planinhalte nicht konsistent rendert, rankt die Seite schlechter als erwartet oder der Link stärkt nur eine dünne Schale.

Gängige Lösungen sind:

- Server‑Side‑Rendering (SSR), sodass die erste Antwort Plan‑Namen und Feature‑Texte enthält

- Pre‑Rendering für die Pricing‑Route

- Kritischen „Money‑Text“ in die initiale HTML setzen und dann mit React enhancement betreiben

- API‑Abhängigkeit für essentielle Preisdaten reduzieren

- Blockierte Ressourcen freigeben, die beim Rendern fehlschlagen

Solange ein Fix läuft, ziehe in Betracht, eine andere URL zu verlinken: eine Pricing‑Übersichtsseite, eine Vergleichsseite oder eine „Plans“‑Seite, die bereits echten Text in der initialen HTML liefert.

Nächste Schritte: Validieren nach Platzierung und sicher skalieren

Sobald ein Backlink live ist, bestätige, dass das Ziel weiterhin genauso rendert wie bei der Genehmigung. Wiederhole die gleichen Render‑ und Indexchecks mit genau der URL, auf die der Link zeigt (inklusive trailing slash, Parameter und Canonical‑Verhalten). Wenn sich die Render‑Ausgabe geändert hat, ist der Linkwert gefährdet, bis du die Ursache kennst.

Achte auf stille Template‑Änderungen

JavaScript‑starke Sites brechen oft, ohne dass es jemand merkt. Ein kleines Release kann Schlüsseltexte hinter einen Klick schieben, echte Überschriften durch Platzhalter ersetzen oder die Hauptcopy erst nach einem langsamen API‑Call laden. Die Seite sieht für Menschen zwar weiter okay aus, aber Google kann dünnen Inhalt sehen.

Praktische Regel: Wenn wichtiger Text nicht schnell und konsistent in der gerenderten HTML präsent ist, baue keine weiteren Links auf diese Seite, bis sie gefixt ist.

Baue eine einfache Skalierungs‑Routine

Du brauchst kein komplexes Dashboard, sondern eine wiederholbare Gewohnheit, die Probleme früh auffängt — besonders auf Seiten, auf die du am meisten verlinkst.

Eine leichtgewichtige Kadenz:

- Innerhalb von 24–72 Stunden nach Platzierung: Render‑Test wiederholen und bestätigen, dass die indexierte URL die beabsichtigte ist.

- Wöchentlich (erster Monat): Stichproben deiner Top‑verlinkten Seiten nach jedem Deploy.

- Monatlich: Top‑verlinkte Seiten und jede Seite, die Templates geändert hat, erneut prüfen.

- Nach großen Redesigns: Nimm an, dass sich alles geändert hat, und validiere neu, bevor du neue Backlinks setzt.

Wenn du kuratierte Platzierungen über eine Quelle wie SEOBoosty nutzt, sind diese Checks noch wichtiger. Starke Links helfen nur, wenn die Zielseite crawlbar und konsistent ist.

Führe ein einfaches Logbuch (Datum, Ziel‑URL, Render‑Status, Index‑Status). Wenn etwas kaputtgeht, weißt du, wann es sich geändert hat und welche Backlinks betroffen sein könnten.

FAQ

Warum kann ein guter Backlink auf einer JavaScript‑lastigen Seite „verschwendet“ wirken?

Wenn der Hauptinhalt einer Seite erst nach Ausführung von JavaScript erscheint, sieht Google ggf. zunächst nur eine leere HTML‑Schale. Das macht das Ziel für den Crawler „dünn“, sodass der Backlink weniger Wert hat, auch wenn die Seite im Browser gut aussieht.

Was macht eine URL auf einer JS‑Site zu einem „sicheren“ Backlink‑Ziel?

Sichere Ziele sind URLs, bei denen Kerntext (Title, H1, zentrale Absätze und wichtige interne Links) ohne Klicks, Logins, Cookie‑Wände oder lange API‑Aufrufe vorhanden ist. Erscheint wichtiger Inhalt erst nach Nutzerinteraktion, ist das Linkziel riskant.

Wie prüfe ich schnell, ob Google den Inhalt ohne Rendern sehen kann?

Öffne "Seitenquelltext anzeigen" und suche nach dem Title‑Tag, einem H1 und ein paar Sätzen des Haupttexts, den du indexiert haben möchtest. Siehst du größtenteils leere Container und Script‑Tags, hängt die Seite wahrscheinlich von Client‑Side‑Rendering ab und ist als Linkziel unzuverlässig.

Wie kann das Canonical‑Tag den Wert meines Backlinks auf eine andere Seite lenken?

Das Canonical‑Tag gibt Google die bevorzugte Version an. Wenn dein Backlink auf eine URL zeigt, die auf eine andere URL kanonisiert, wird die Autorität oft der kanonischen Seite zugewiesen statt deiner gewählten URL.

Machen kleine URL‑Unterschiede wie ein Slash oder Parameter wirklich einen Unterschied für Backlinks?

Ja. Kleine Unterschiede können verschiedene crawlbare URLs, Duplikate oder Weiterleitungen erzeugen. Ein Slash, ein Tracking‑Parameter oder der Wechsel zwischen www und non‑www kann ändern, welche URL Google als primär betrachtet.

Warum sollte ich hash‑basierte URLs (alles nach #) als Backlink‑Ziele meiden?

Google ignoriert Fragment‑Identifier normalerweise für die Indexierung, und viele JS‑Apps nutzen sie für clientseitiges Routing. Eine URL mit Hash kann daher ein schwaches oder inkonsistentes Ziel sein, auch wenn sie im Browser funktioniert.

Sind Redirects beim Setzen von Backlinks immer schlecht?

Eine 301‑Weiterleitung kann in Ordnung sein, wenn sie stabil und beabsichtigt ist. Überraschende Redirects dagegen können Relevanz verwässern oder Autorität an eine unerwünschte Seite schicken. Am sichersten ist es, direkt auf das finale, kanonische Ziel zu verlinken.

Wie führe ich einen Render‑Test aus, um zu bestätigen, was Google tatsächlich sieht?

Führe eine Live‑Render‑Prüfung (z. B. URL‑Inspektion) aus und vergleiche die initiale HTML‑Antwort mit der gerenderten Ausgabe. Fehlt dein „Must‑Show“ Text in der gerenderten Snapshot‑Ansicht oder siehst du nur Spinner, Platzhalter oder eine Login‑Ansicht, gilt die Seite als ungeeignet, bis sie repariert ist.

Was ist die praktischste Lösung, wenn mein Schlüsselinhalt zu spät geladen wird?

Server‑Side‑Rendering (SSR) oder Pre‑Rendering sorgt dafür, dass wichtiger Text schon in der ersten HTML‑Antwort steht, sodass Google nicht auf Skripte oder API‑Aufrufe warten muss. Eine einfachere Alternative ist, kritische Copy in die initiale HTML zu legen und sie mit JavaScript nur noch zu verbessern.

Was sollte ich nach Live‑Schaltung eines Backlinks prüfen, um seinen Wert zu schützen?

Überprüfe die exakte URL, auf die verlinkt wurde, und bestätige, dass die Seite weiterhin gleich rendert, indexierbar bleibt und dass das Canonical unverändert ist. Wenn du Premium‑Platzierungen kaufst (z. B. über SEOBoosty), ist dieser Schritt besonders wichtig, weil starke Links nur wirken, wenn das Ziel crawlbar und stabil bleibt.