Link‑zu‑Query‑Mapping in der Search Console mit dem API‑Report

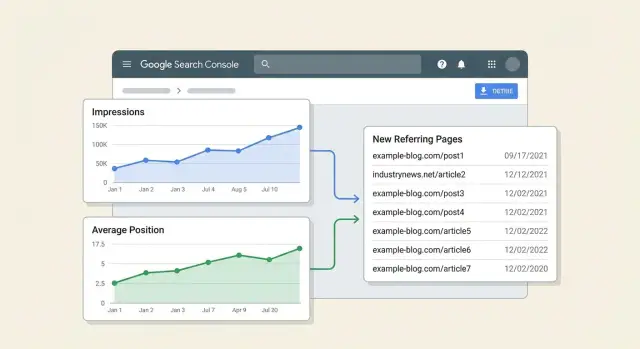

Erlernen Sie Link‑zu‑Query‑Mapping in der Search Console, um neue verweisende Seiten mit Änderungen bei Impressionen und Positionen pro URL über die GSC API zu verbinden.

Was Sie messen wollen (und was nicht)

Das Link‑zu‑Query‑Mapping in der Search Console fasst drei Dinge in einer Ansicht zusammen: eine bestimmte Seite, die Suchanfragen, für die diese Seite angezeigt wird, und die verweisenden Seiten, die angefangen haben, auf sie zu verlinken.

Das Ziel ist nicht, zu beweisen, dass ein Link einen Ranking‑Sprung verursacht hat. Google kennzeichnet Impressionen oder Klicks nicht mit „das geschah wegen Link X“, und Rankings bewegen sich aus vielen Gründen (Inhaltsänderungen, interne Verlinkung, Saisonalität, Wettbewerber‑Änderungen und Google‑Updates). Die zeitliche Komponente ist außerdem unordentlich: Ein Link kann heute live gehen und erst Tage oder Wochen später entdeckt werden.

Ein praktisches Ziel ist einfacher: Verknüpfen Sie neue verweisende Seiten mit Änderungen bei Impressionen und der durchschnittlichen Position für die exakte URL, auf Query‑Ebene. Das liefert eine handhabbare Story wie: „Diese Seite erhielt neue Links, danach verbesserte sich die Sichtbarkeit für diese Suchanfragen.“ Es ist Korrelation mit Sicherheitsmaßnahmen, kein Gerichtsbeweis.

Was Ihnen dieser Report sagen kann

Richtig eingesetzt kann ein Google Search Console API‑Report wie dieser einige wertvolle Fragen beantworten:

- Für welche Queries einer URL gab es nach Auftreten neuer verweisender Seiten Zugewinne oder Verluste bei den Impressionen.

- Ob sich der Trend der durchschnittlichen Position dieser URL im gleichen Zeitraum verbesserte, stabil blieb oder fiel.

- Welche neu verlinkenden Seiten mit den größten Veränderungen übereinstimmen, sodass Sie wissen, was Sie zuerst prüfen sollten.

Was Ihnen dieser Report nicht sagen kann

Dieser Report kann nicht zuverlässig:

- Einer einzelnen Quelle die Verdienstzuweisung geben oder einen genauen „Link‑Wert“ pro Query berechnen.

- Den Link‑Effekt von anderer SEO‑Arbeit ohne zusätzliche Kontrollen trennen.

- Garantieren, dass Google einen Link gezählt oder vertraut hat, nur weil er existiert.

Beispiel: Ihre Pricing‑Seite erhält zwei neue Links aus Branchenartikeln. In den nächsten 14 Tagen steigen die Impressionen für „product pricing“ und „enterprise pricing“, während „free trial pricing" gleich bleibt. Das beweist nicht, dass die Links den Anstieg verursacht haben, zeigt aber, dass die Seite nach dem Auftreten neuer verweisender Seiten häufiger für bestimmte Suchanfragen angezeigt wurde.

Wenn Sie einen Placement‑Service wie SEOBoosty (seoboosty.com) nutzen, um Premium‑Backlinks auf eine bestimmte Seite zu lenken, ist dieses Mapping ebenfalls ein Plausibilitätscheck. Es hilft Ihnen zu prüfen, ob die Query‑Sichtbarkeit genau dieser URL sich verändert hat, statt sich auf siteweite Durchschnitte zu verlassen.

Die Daten, die Sie aus Search Console kombinieren werden

Sie brauchen zwei verschiedene Sichten aus Search Console. Die eine zeigt, was in der Suche passiert ist (Impressionen, Klicks, Position). Die andere zeigt, welche Seiten im Web auf Sie verlinken.

1) Performance‑Daten (was sich in der Suche geändert hat)

Diese stammen aus dem Performance‑Report in Search Console (über das Search Analytics‑Endpoint in der API). Er ist der klarste Weg, um Ergebnisse wie Impressionen und durchschnittliche Position zu messen.

Holen Sie Metriken wie Klicks, Impressionen, CTR und durchschnittliche Position und gruppieren Sie sie nach Dimensionen, die erklären, was sich bewegt hat. Für diesen Report sind die nützlichsten Dimensionen Seite, Query und Datum. Land und Gerät können helfen, wenn Sie gemischte Märkte oder starke Unterschiede zwischen Mobile und Desktop haben.

Eine praktische Regel: Immer page einschließen. Fügen Sie query hinzu, wenn Sie wissen wollen, welche Suchanfragen sich geändert haben, nicht nur, ob sich die Seite geändert hat.

2) Links‑Daten (was off‑site passiert ist)

Diese stammen aus dem Links‑Report in Search Console (über die Links‑Endpoints). Dort finden Sie die verweisenden Seiten, die auf Ihre Seiten zeigen.

Für Link‑zu‑Query‑Mapping sind die relevanten Felder:

- target page (welche Ihrer URLs der Link anvisiert)

- linking page (die konkrete externe Seite, die verlinkt)

- linking site (die Domain, nützlich für Rollups)

Links‑Daten sagen Ihnen nicht, welche Query ein Link beeinflusst hat. Sie zeigen nur, dass ein Link zu einer bestimmten Zielseite existiert. Jegliche „Attribution“ in Ihrem Report basiert auf Timing und der betroffenen URL, nicht auf einem bewiesenen Kausalzusammenhang.

Warum Sie „Before“ und „After“ Fenster brauchen

Links und Rankings ändern sich nicht immer am selben Tag, und Search Console‑Daten sind nicht perfekt in Echtzeit. Ein einzelnes Datum zu betrachten erzeugt Rauschen.

Verwenden Sie zwei gleich lange Zeitfenster für Performance‑Daten:

- ein „before“ Fenster, um eine Baseline zu setzen

- ein „after“ Fenster, um die Änderung zu messen

Ordnen Sie dann neue verweisende Seiten nach dem ersten Datum, an dem Sie sie gesehen haben (oder dem frühesten Datum, das Sie zuweisen können), und vergleichen Sie Performance vor vs. nach.

Wenn Sie nur ein Modell im Kopf behalten: Performance erklärt die Bewegung; Links liefern Hinweise, was sie ausgelöst haben könnte. Die Kombination pro URL ist der Sinn des Ganzen.

Umfang, Fenster und Regeln für „neue Links“ definieren

Dieser Report funktioniert nur, wenn Sie den Umfang vorab festlegen. Wenn Sie die URL‑Menge oder Zeitfenster während der Analyse ändern, schwanken die Ergebnisse aus Gründen, die nichts mit Links zu tun haben.

Beginnen Sie mit dem Ziel‑URL‑Set und bleiben Sie dabei: eine wichtige Seite, ein Ordner oder eine kleine Menge von Templates (z. B. Produktseiten). Je enger das Set, desto leichter lässt sich ein Zusammenhang zwischen neuen verweisenden Seiten und Änderungen bei Impressionen und durchschnittlicher Position herstellen.

Wählen Sie als Nächstes zwei gleich lange Zeitfenster. Für viele Sites sind 28 Tage vs. die nächsten 28 Tage ein guter Standard, weil sie Tages‑Schwankungen glätten.

Definieren Sie nun „neu“. Eine einfache Regel: Eine verweisende Seite ist „neu“, wenn sie vor dem Vergleichszeitraum keine aufgezeichneten Links zum Ziel‑URL‑Set hatte und während des Vergleichszeitraums mindestens einen aufgezeichneten Link hatte. Wenn Ihre Linkquelle langsam aktualisiert, fügen Sie einen kleinen Puffer hinzu, z. B. indem Sie die ersten Tage des Vergleichszeitraums von der „neue Link“-Erkennung ausschließen.

Um Rauschen zu reduzieren, setzen Sie Mindestschwellen bevor Sie Änderungen berechnen. Ansonsten kann eine einzelne zufällige Impression wie ein „Ranking‑Sprung“ aussehen. Zum Beispiel:

- Nur Ziel‑URLs mit mindestens X Impressionen in beiden Fenstern einbeziehen (z. B. 100)

- Nur Queries mit mindestens Y Impressionen in beiden Fenstern einbeziehen (z. B. 10)

- Mindestens Z aktive Tage mit Impressionen pro Fenster verlangen (z. B. 10 Tage)

- Positionsänderungen ignorieren, wenn Impressionen zu niedrig sind, um stabil zu sein

Beispiel: In den 28 Tagen der Baseline erhält Ihre Pricing‑Seite 1.200 Impressionen bei einer durchschnittlichen Position von 11,2. In den nächsten 28 Tagen sind es 1.650 Impressionen bei 9,8. Ihre Regeln helfen zu entscheiden, dass das bedeutsam ist, während Seiten mit Sprung von 3 auf 9 Impressionen ignoriert werden.

Wenn Sie Platzierungen eines Anbieters verfolgen (auch bezahlte Platzierungen), behandeln Sie jede verweisende Seite als eigenes „new referring page“ Event. So können Sie Ergebnisse quellenübergreifend vergleichen, ohne mehrere Änderungen zusammenzufassen.

Entwerfen Sie ein simples Datenmodell für den Report

Halten Sie das Datenmodell langweilig. Drei Tabellen plus gemeinsame Regeln für URLs und Daten genügen. Wenn die Schlüssel konsistent sind, werden Joins und Vergleiche einfach.

1) Ziel‑URLs Tabelle (die Seiten, die Sie beobachten)

Das ist Ihr Seitenkatalog. Er verhindert Duplikate, wenn dieselbe Seite mit Parametern, unterschiedlicher Groß-/Kleinschreibung oder Trailing Slashes auftaucht.

Speichern:

- target_url_canonical: die kanonische URL, die Sie reporten

- target_url_normalized: normalisierter Join‑Key (siehe Regeln unten)

- page_type: Kategorie, Produkt, Blog, Docs usw.

- notes: optional, z. B. „High value page“ oder „recently updated"

2) Verweisende Seiten Tabelle (die neuen Links)

Das ist der Input für „was sich geändert hat“. Jede Zeile ist eine verweisende Seite, die auf eine Ihrer Ziel‑URLs zeigt.

Speichern:

- referring_url: genaue Seite, die auf Sie verlinkt

- referring_url_normalized: zum Deduplizieren normalisiert

- referring_domain: extrahierte Domain (zum Gruppieren)

- target_url_normalized: Join zurück zur Ziel‑URL

- first_seen_date: erstes Datum, an dem Sie den Link beobachtet haben (oder das Datum, das Ihr Anbieter meldet)

Wenn eine verweisende Seite auf zwei Ziel‑URLs verlinkt, behalten Sie zwei Zeilen. Die Zuordnung muss explizit bleiben.

3) Performance‑Tabelle (Search Console‑Output)

Halten Sie Performance‑Daten auf der kleinstmöglichen nützlichen Ebene, damit Sie später hochaggregieren können.

Speichern:

- date

- target_url_normalized

- query

- impressions

- clicks (optional, lohnt sich meist)

- position (durchschnittliche Position aus Search Console)

Vermeiden Sie zu frühe Aggregationen. Impressionen können Sie später immer summieren, aber Query‑Level‑Details sind verloren, wenn Sie sie zusammenfassen.

Join‑Key‑Strategie (Regeln, die alles konsistent halten)

Treffen Sie Entscheidungen einmal und wenden Sie sie überall an:

- Normalisierte URL: Host kleinschreiben, Fragmente entfernen und Trailing Slashes standardisieren. Entscheiden Sie, wie mit Parametern verfahren wird (oft: Tracking‑Parameter entfernen, inhaltlich relevante behalten).

- Domain‑Extraktion: Speichern Sie die registrierbare Domain oder zumindest den Host, damit Sie sauber nach Domain gruppieren können.

- Date‑Buckets: Erzeugen Sie ein date_bucket Feld wie Woche (YYYY‑WW) oder Monat (YYYY‑MM), um Vergleiche stabiler zu machen als rohe Tagesdaten.

Mit diesen drei Tabellen und konsistenten Schlüsseln ist Ihr finaler Report: neue verweisende Seiten (nach First‑Seen) verbunden mit Performance‑Änderungen (nach URL, Query und Date‑Bucket).

Schritt für Schritt: Daten mit der Search Console API ziehen

Beginnen Sie mit Performance‑Daten, denen Sie vertrauen, und fügen Sie dann neue verweisende Seiten aus einer separaten Quelle hinzu. Das Standard‑Search Console‑API ist für Performance‑Reporting gebaut, nicht für einen vollständigen Links‑Report‑Export.

1) Zugriff auf die richtige Property bekommen

Ziehen Sie Daten aus derselben Property, die Ihr Team in Search Console nutzt (Domain‑Property vs URL‑Prefix‑Property). Die falsche Property lässt Links oder Rankings wie „verschwunden“ aussehen, obwohl Sie nur einen anderen Datensatz ansehen.

Bestätigen Sie vor Ausführung:

- Ihr Google‑Account hat Rechte auf der Property (Owner oder Full User)

- Die Search Console API ist im Google Cloud‑Projekt aktiviert

- Sie können die Site in der API auflisten (schneller Sanity‑Check)

2) Performance nach Seite + Query (täglich wenn möglich) ziehen

Nutzen Sie die Search Analytics query‑Methode. Wählen Sie einen Datumsbereich und fordern Sie Dimensionen an, die Änderungen auf eine konkrete URL und Suchanfrage zurückführen.

Ein praktischer Startpunkt:

- Dimensionen: date, page, query

- Metriken: clicks, impressions, position

- Optionale Filter: fixes Land/Gerät, wenn Ihre Seite stark variiert

Mehr Dimensionen erhöhen die Zeilenanzahl. Planen Sie Paginierung mit startRow bis ans Ende.

Hier ein minimales Request‑Body‑Beispiel (nur Form):

{

"startDate": "2026-01-01",

"endDate": "2026-01-31",

"dimensions": ["date", "page", "query"],

"rowLimit": 25000,

"startRow": 0

}

3) „Neue verweisende Seiten“ Daten erfassen (was möglich ist)

Der Links‑Report in Search Console ist in der UI nützlich, aber Google stellt nicht denselben Satz „top linking pages → target page“ über das Standard‑API zur Verfügung.

Wenn Sie verweisende Seiten‑URLs brauchen, haben Sie typischerweise zwei Optionen:

- Den Links‑Report aus der Search Console‑UI regelmäßig exportieren und diese Datei ingestieren.

- Eine separate Backlink‑Quelle nutzen und verweisende Seiten mit Ziel‑URLs abgleichen.

Bewahren Sie in jedem Fall die rohe verweisende Seiten‑URL, die Zielseiten‑URL und ein First‑Seen‑Datum (oder Export‑Datum) auf, damit Sie später „neu“ klassifizieren können.

4) Roh‑Antworten speichern, bevor Sie transformieren

Speichern Sie jede API‑Antwort (und die Anfrageparameter) als rohe JSON‑Dateien oder Zeilen in einer Raw‑Tabelle. Neuaufrufe werden einfacher, wenn Sie Matching‑Regeln, Zeitfenster oder Filter anpassen. Es hilft auch, wenn jemand fragt, warum sich die durchschnittliche Position einer URL geändert hat und Sie zeigen müssen, was die API zurückgegeben hat.

Schritt für Schritt: bereinigen, matchen und Änderungen berechnen

Dieser Report lebt oder stirbt damit, dieselbe URL über Datensätze hinweg zu matchen. Wenn URLs nicht sauber joinen, wird der „Impact“ zufällig.

1) URLs normalisieren, damit Zeilen wirklich joinen

Wählen Sie eine kanonische Form für jede Zielseiten‑URL und wenden Sie dieselben Regeln überall an (Search Console Seiten, Ihre Backlink‑Liste und die Ausgabe).

Übliche Korrekturen:

- Ein Protokoll und Host‑Style verwenden (z. B. immer https und der bevorzugte Host).

- Trailing Slashes standardisieren, sodass /page und /page/ nicht splitten.

- Tracking‑Parameter (utm_*, gclid, fbclid) entfernen und nur Parameter behalten, die den Inhalt verändern.

- Offensichtliche Duplikate wie index.html behandeln.

Nach der Normalisierung erstellen Sie einen stabilen Key (normalized_url) und joinen Ihre verweisenden Seiten‑Tabelle mit den Performance‑Daten der Search Console über diesen Key.

2) Queries matchen, ohne ein Taxonomie‑Projekt daraus zu machen

Query‑Gruppierung sollte eine Frage beantworten: Wuchs die Sichtbarkeit hauptsächlich für Branded‑Demand, Non‑Branded‑Discovery oder beides?

Halten Sie es leichtgewichtig. Zwei Tags pro Query reichen meist: brand vs non‑brand plus ein einfacher Intent‑Bucket (informational, commercial, navigational). Verwenden Sie kurze, editierbare Regeln. Zum Beispiel ist Brand: „Query enthält Marken‑ oder Produktnamen“, Navigational enthält „login“ oder „pricing“, und alles andere ist je nach kleiner Keyword‑Liste informational oder commercial.

3) Deltas berechnen und an „first seen“ ausrichten

Speichern Sie für jede verweisende Seite link_first_seen als frühestes Datum, an dem Sie sie beobachtet haben und ordnen Sie dieses Datum Ihren Fenstern zu.

Eine einfache Regel:

- before_window = 28 Tage, endend am Tag vor link_first_seen

- after_window = 28 Tage, beginnend am link_first_seen

Berechnen Sie Änderungen auf (target URL, query group) Ebene und rollen Sie dann auf URL‑Ebene hoch. Halten Sie Metriken lesbar:

- Impressions delta = impressions_after - impressions_before

- Position delta = avg_position_after - avg_position_before (negativ ist besser)

- Visibility score = impressions * (1 / avg_position) oder eine andere einfache Gewichtung, die Sie konsistent nutzen

- Contribution share = URL delta geteilt durch das siteweite Delta im selben Zeitraum

Beispiel: Ein Blog‑Post hat eine neue Verweisquelle mit first_seen am 10. Mai. In den 28 Tagen davor hatte er 1.000 Impressionen bei Position 14. In den 28 Tagen danach hat er 1.450 Impressionen bei Position 11. Ihr Report zeigt +450 Impressionen und -3 Positionen, und Sie sehen, ob der Gewinn von Non‑Brand‑informational Queries oder einem branded Lift kam.

Wenn Sie Platzierungen von Anbietern wie SEOBoosty verfolgen, speichern Sie ebenfalls das link_first_seen Feld für diese Platzierungen, damit Ihre Fenster über Quellen hinweg vergleichbar bleiben.

Die Report‑Views bauen, die Menschen wirklich lesen

Ein gutes Link‑zu‑Query‑Mapping‑Report ist keine Tabellenkalkulation mit Dutzenden Tabs. Es sind wenige Views, die eine Frage schnell beantworten: „Was hat sich geändert, nachdem diese Seite neue Links bekam, und vertrauen wir dem Signal?"

View 1: URL‑Impact‑Summary (die Ansicht, die Sie zuerst öffnen)

Starten Sie mit einer Zeile pro Ziel‑URL. Machen Sie es scannbar und machen Sie „neue verweisende Seiten“ konkret.

Einschließen:

- Target URL

- Anzahl neuer verweisender Seiten (im Link‑Fenster)

- First seen date (frühestes neues ref page Datum)

- Impressions delta (before vs after)

- Avg position delta (before vs after)

Fügen Sie eine kompakte Zelle „New referring pages“ mit 2–3 Beispielen (Domain + first seen) hinzu, mit der vollständigen Liste per Drilldown oder Filter. Hier prüfen Leser schnell, ob die Links echt oder Rauschen sind.

View 2: Query‑Impact für eine URL (die „Warum“ Ansicht)

Wenn jemand auf eine URL klickt, zeigen Sie die Queries, die sich bewegt haben. Begrenzen Sie auf die Top‑Mover.

Ein praktisches Layout:

| Query | Impressions before | Impressions after | Position before | Position after | Note |

|---|

Sortieren Sie nach größten Impression‑Gewinnen zuerst und fügen Sie einen Filter für Rückgänge hinzu. Behalten Sie eine „Note“ Spalte für Kontext wie „Brand‑Query“ oder „SERP‑Feature erschienen“.

Kontext‑Spalten, die schlechte Entscheidungen verhindern

Wenn Sie nach Gerät, Land oder Suchtyp aufschlüsseln, machen Sie das im UI deutlich, damit Leser nicht Äpfel mit Birnen vergleichen. Eine einfache Kopfzeile wie „Device: Mobile“ reicht.

Fügen Sie pro URL ein kurzes manuelles Confidence‑Feld hinzu: „High“ (klarer Lift über mehrere Queries), „Medium“ (Lift, aber hauptsächlich bei einer Query), „Low“ (Timing überschneidet sich mit einer Site‑Änderung).

Ein realistisches Beispiel (ohne komplizierte Mathematik)

Konzentrieren Sie sich auf eine URL für eine Woche und vergleichen Sie sie mit einer ähnlichen Woche davor, bevor die Links erschienen.

Szenario

Sie veröffentlichen einen Blog‑Beitrag: /blog/on-page-checklist. In der Woche vom 6. bis 12. Mai zeigt Ihr Link‑Log drei neue verweisende Seiten, die auf diese URL zeigen. Zwei sind relevante Artikel, eine ist eine allgemeine Ressourcenliste.

Setzen Sie zwei Fenster:

- Before window: 29. Apr bis 5. Mai

- After window: 6. Mai bis 12. Mai

Holen Sie nun Query‑Level‑Metriken für diese URL aus Search Console für beide Fenster und berechnen Sie die Deltas.

Wie die Zahlen aussehen können

Für die Query „on page checklist“ steigen die Impressionen von 1.200 auf 2.100 (+900), die durchschnittliche Position bleibt etwa gleich (8,4 auf 8,3). Das deutet meist darauf hin, dass Sie öfter gezeigt werden, aber nicht unbedingt höher ranken. Häufige Gründe sind breitere Eligibility (mehr Long‑Tail‑Varianten) oder gestiegenes Interesse.

Für die Query „on page seo steps“ bleiben die Impressionen stabil (300 auf 310), aber die Position verbessert sich (14,2 auf 10,8). Das kann passieren, wenn das Vertrauen für eine engere Menge an Suchanfragen steigt, auch wenn die Nachfrage nicht stark zunimmt.

Wichtig ist, dass Ihr Report das First‑Seen‑Datum jeder neuen verweisenden Seite mit dem Vergleichsfenster verknüpft und Ergebnisse nach URL getrennt hält (nicht siteweit zusammengefasst).

Wie Sie es in einem Wochen‑Update zusammenfassen

Kurz und entscheidungsorientiert:

- Was sich geändert hat: 3 neue verweisende Seiten zu

/blog/on-page-checklist(6.–12. Mai) - Was sich bewegt hat: +900 Impressionen für die Hauptquery; Positionsverbesserung bei einer sekundären Query

- Was es wahrscheinlich bedeutet: Sichtbarkeit stieg zuerst; Rankings könnten für spezifische Begriffe beginnen zu steigen

- Was zu beobachten ist: Gleiche Gegenüberstellung nächste Woche wiederholen, um zu sehen, ob die Position nachzieht

Wenn Sie SEOBoosty‑Platzierungen verwenden, ist dieses wöchentliche Format eine saubere Möglichkeit zu berichten, was nach jeder Charge passiert ist, ohne zu behaupten, Links hätten jede Änderung verursacht.

Häufige Fallen, die den Report irreführend machen

Der Report ist nützlich, aber leicht zu missbrauchen. Das größte Risiko ist, Korrelation zur Geschichte zu machen, weil das Diagramm ordentlich aussieht.

Falle 1: „Der Link erschien, Rankings bewegten sich, also hat der Link es verursacht“

Übereinstimmende Daten sind kein Beweis. Search Console‑Daten können verzögert sein, Links werden langsam entdeckt und Google kann Signale später neu verarbeiten. Ein Link kann am Montag gefunden, am Donnerstag berichtet und erst später wirksam werden.

Behandeln Sie den Link als mögliche Erklärung. Ihr Report sollte zeigen, was sich geändert hat, nicht warum.

Falle 2: Eine Seite in viele „URLs“ aufspalten

Wenn Sie URL‑Varianten mischen, splitten Sie das Signal und Ihre before vs after Änderungen werden laut. Häufige Ursachen: http vs https, www vs non‑www, Trailing Slash, Parameter und kanonisierte Seiten.

Wählen Sie eine Normalisierungsregel und bleiben Sie dabei. Sonst könnten Sie einen Positionsabfall fälschlich auf „neue verweisende Seiten“ schieben, während Ihre Impressionen auf einer Parameter‑URL liegen.

Falle 3: Ungleiche Vergleichsfenster

7 Tage davor mit 28 Tagen danach zu vergleichen (oder Wochenenden mit Wochentagen zu mischen) erzeugt falsche Lifts und Drops. Viele Seiten haben starke Tagesmuster.

Wenn Sie kurze Fenster nutzen müssen, halten Sie sie symmetrisch und nach Wochentagen ausgerichtet. Bei saisonalen Themen fügen Sie Kontexthinweise (Launches, Feiertage, PR) neben den Zahlen hinzu.

Falle 4: Die durchschnittliche Position als alleinige Wahrheit behandeln

Die durchschnittliche Position kann sich nur verändern, weil sich Ihre Impressionen‑Mischung geändert hat. Wenn eine Seite beginnt, für eine neue Query auf Position 35 mit vielen Impressionen zu erscheinen, verschlechtert das den Durchschnitt, auch wenn Ihre Hauptquery besser geworden ist.

Prüfen Sie die Verteilung: Sind Impressionen in höhere oder niedrigere Positionen gewandert? Hat eine neue Query die After‑Periode dominiert?

Falle 5: Indexierungs‑ und On‑Page‑Änderungen ignorieren

Ein „Link‑Impact“ Report bricht zusammen, wenn sich die Seite selbst geändert hat. Title‑Änderungen, interne Links, Template‑Updates, Inhaltsänderungen und Indexierungsprobleme können Impressionen und Positionen bewegen.

Bevor Sie einem neuen Backlink Kredit geben, prüfen Sie, ob die Seite stabil und indexierbar war.

Sicherheitsmaßnahmen, die den Report ehrlich halten:

- Gleiche Fensterlänge (und Wochentage) für jeden Vergleich verwenden.

- URLs normalisieren und Query‑Varianten dort gruppieren, wo es sinnvoll ist.

- Perioden mit Inhaltsänderungen, Redirects oder Indexierungs‑Warnungen kennzeichnen.

- Query‑Level‑Mover prüfen, nicht nur Seiten‑Durchschnitte.

- „New referring pages“ als Anfangspunkt sehen und dann mit anderen Signalen verifizieren.

Schnellprüfungen und nächste Schritte

Bevor Sie einem Diagramm vertrauen, prüfen Sie die Eingaben. Link‑zu‑Query‑Mapping kann überzeugend aussehen, auch wenn URL‑, Link‑ oder Query‑Daten nicht zusammenpassen.

Schnellprüfungen (5 Minuten)

- Bestätigen Sie, dass die Ziel‑URL konsistent ist: kanonisiert wie erwartet, indexierbar und nicht durch noindex, robots oder falsche Canonical blockiert.

- Validieren Sie, dass die „neuen verweisenden Seiten“ echt sind: die Seite existiert, ist nicht hinter Login und verlinkt tatsächlich auf Ihre Seite (nicht nur auf Ihre Domain).

- Stellen Sie sicher, dass der Link auf die richtige URL‑Version zeigt: http vs https, www vs non‑www, Trailing Slash, Parameter und Redirects können das Signal splitten.

- Prüfen Sie die Stichprobengröße, bevor Sie Positionsverschiebungen vertrauen. Bei niedrigen Impressionen schwankt die durchschnittliche Position stark.

- Scannen Sie das gleiche Fenster nach anderen Änderungen: Title‑Edits, Template‑Updates, Redirects, interne Link‑Änderungen, PR‑Launches oder saisonale Nachfrageschwankungen.

Beispiel: Sie sehen eine neue verweisende Seite und die durchschnittliche Position einer Query verbessert sich von 14 auf 9. Hatte die Seite vorher nur 30 Impressionen und danach 40, kann dieser Sprung Rauschen sein. Bei 5.000 auf 6.000 Impressionen ist er wahrscheinlicher echt.

Nächste Schritte, die den Report nützlich halten

Konsistenz ist wichtiger als ausgefeilte Formeln.

- Wöchentlich mit denselben Fenstern und Regeln überwachen.

- Anmerkungen für Link‑Drops und große Site‑Änderungen hinzufügen.

- „High‑confidence“ Seiten kennzeichnen: stabile URL, hohes Impression‑Volumen und eine klare neue verweisende Seite, die direkt verlinkt.

- Nach 2–4 Wochen erneut prüfen. Links und Rankings bewegen sich selten synchron und Search Console‑Daten können verzögert sein.

Wenn Sie sauberere Before‑and‑After‑Tests für konkrete URLs wollen, helfen kontrollierte Platzierungen, weil Sie genaue Ziele und Daten protokollieren können. Zum Beispiel bietet SEOBoosty (seoboosty.com) kuratierte Backlink‑Platzierungen per Abo an, die den Vergleich über ähnliche Link‑Events erleichtern.

Halten Sie die Prüfungen leicht und regelmäßig. So bleibt der Report lesbar und Sie verschwenden weniger Zeit mit Diskussionen über Randfälle.

FAQ

Was ist das Hauptziel des Link‑zu‑Query‑Mappings in der Search Console?

Beginnen Sie damit zu messen, ob eine bestimmte URL nach dem ersten Auftreten neuer verweisender Seiten Sichtbarkeit für bestimmte Suchanfragen gewonnen hat. Behandeln Sie es als eine Korrelation, die untersucht werden kann, nicht als Beweis, dass ein einzelner Link eine Ranking-Änderung verursacht hat.

Wie lange sollten meine „before“ und „after“ Fenster sein?

Verwenden Sie zwei gleich lange Zeitfenster, damit normale tägliche Schwankungen das Signal nicht überlagern. Ein praktischer Standard sind 28 Tage davor und 28 Tage danach. Wenn Ihr Traffic starke Wochentagsmuster hat, stimmen Sie die Fenster nach Wochentagen ab.

Wie definiere ich eine „neue verweisende Seite“, ohne mich zu täuschen?

Definieren Sie „neu“ als eine verweisende Seite, die im Basiszeitraum nicht auftauchte und dann im Vergleichszeitraum erscheint. Wenn Ihre Linkdaten verzögert eintreffen, fügen Sie einen kleinen Puffer hinzu, damit die ersten Tage des Nachher‑Fensters nicht fälschlich als „neu“ klassifiziert werden.

Warum stimmen meine URLs zwischen Performance‑Daten und Link‑Daten nicht überein?

Normalisieren Sie URLs überall gleich: Search Console-Seiten, Ihr Link‑Export und die Ausgabereports. Häufige Korrekturen sind: einheitliche Trailing Slashes, Entfernen von Tracking‑Parametern und Vermeiden von Splits zwischen http/https oder www/non‑www.

Kann ich verweisende Seiten‑URLs direkt aus der Search Console API bekommen?

Verwenden Sie das Search Analytics‑Endpunkt für Performance‑Metriken wie Impressionen, Klicks und durchschnittliche Position nach Seite, Query und Datum. Für die URLs verweisender Seiten planen Sie, den Links‑Report aus der Search Console‑UI regelmäßig zu exportieren oder eine andere Backlink‑Quelle zu nutzen, denn das Standard‑API stellt keinen vollständigen Export „linkende Seite → Zielseite“ wie die UI bereit.

Wie soll ich Änderungen der durchschnittlichen Position im Report interpretieren?

Die durchschnittliche Position kann sich verschieben, nur weil sich Ihre Impressionen‑Mischung geändert hat, nicht weil die Seite für ihre Hauptqueries besser geworden ist. Wenn Sie eine Positionsveränderung sehen, prüfen Sie, welche Queries Impressionen gewonnen haben und ob die Seite für viele neue, niedrig platzierte Queries erscheint, die den Durchschnitt verschlechtern.

Welche Schwellenwerte sollte ich verwenden, damit die Ergebnisse keine Zufallsrauschen sind?

Setzen Sie Mindestschwellen, damit winzige Zahlen nicht wie große Gewinner oder Verlierer aussehen. Eine einfache Vorgehensweise ist, ein Mindestniveau an Impressionen in beiden Fenstern (für Seite und Query) und genügend aktive Tage mit Impressionen zu verlangen, um zufällige Schwankungen zu reduzieren.

Wie bringe ich Leistungsänderungen in Einklang mit dem Datum, an dem ein Link erstmals gesehen wurde?

Speichern Sie pro verweisender Seite ein First‑Seen‑Datum und nutzen Sie dieses Datum, um Ihre Fenster zu verankern, z. B. 28 Tage davor und 28 Tage danach. So bleiben Vergleiche konsistent über verschiedene Link‑Events hinweg und Sie vermeiden das Vermischen mehrerer Änderungen zu einer Geschichte.

Welche Search Console‑Property sollte ich für diesen Report verwenden?

Nutzen Sie dieselbe Search Console‑Property, auf die Ihr Team sich verlässt, und mischen Sie nicht Domain‑Propertys mit URL‑Prefix‑Propertys in derselben Analyse. Unterschiedliche Property‑Typen können dazu führen, dass Links und Performance so aussehen, als wären sie verschwunden, obwohl Sie nur verschiedene Datensätze betrachten.

Wie kann ich diesen Report nutzen, um Backlinks von einem Placement‑Service zu validieren?

Protokollieren Sie jede Platzierung als eigenes verweisendes Seiten‑Event mit erstem Erfassungsdatum und der genauen Ziel‑URL. Wenn Sie einen Service wie SEOBoosty nutzen, ist dieser Report ein praktischer Plausibilitätscheck: Er prüft, ob die Sichtbarkeit der anvisierten URL für Ihre Schlüssel‑Queries gestiegen ist, statt sich auf siteweite Durchschnitte zu verlassen.