Seiten, die Google häufig crawlt: Wie Sie die richtigen Link‑Hosts wählen

Erfahre, wie du Seiten auswählst, die Google häufig crawlt, damit neue Backlinks schneller entdeckt werden, aktuell bleiben und Rankings eher profitieren.

Warum einige neue Links Zeit brauchen, um sichtbar zu werden

Ein neuer Backlink kann sich anfangs unsichtbar anfühlen, weil Google die Seite, die ihn enthält, vielleicht noch nicht besucht hat. Für Menschen funktioniert der Link sofort, aber Suchmaschinen reagieren nur auf das, was sie tatsächlich gecrawlt haben.

Crawling und Indexierung hängen zusammen, sind aber nicht dasselbe.

- Crawling ist, wenn Googlebot eine Seite besucht und liest, was dort steht.

- Indexierung ist, wenn Google entscheidet, die Seite (und ihre Signale) in der Suchdatenbank zu speichern, damit sie in den Ergebnissen erscheinen kann.

Eine Seite kann gecrawlt werden und dennoch nicht indexiert sein. Und selbst wenn Google während eines Crawls einen Link sieht, kann es dauern, bis dieser Link in verschiedenen Google‑Tools konstant auftaucht.

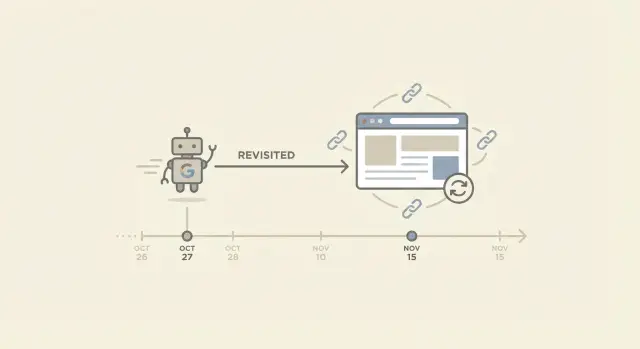

„Recrawl“ bedeutet einfach, dass Google zu derselben URL zurückkehrt. Das ist wichtig, weil die meisten Backlinks auf bestehenden Seiten hinzugefügt werden, nicht auf brandneuen Seiten. Wenn Google die verlinkende Seite selten erneut besucht, kann dein neuer Link dort Tage oder Wochen liegen, bevor Google ihn bemerkt. Wird die Seite oft revisitiert, erfolgt die Entdeckung in der Regel früher.

Links tauchen aus einigen vorhersehbaren Gründen langsam auf: die verlinkende Seite ist alt und wird selten aktualisiert, sie liegt tief mit schwacher interner Verlinkung, die Seite ist so groß, dass Google nur bestimmte Bereiche priorisiert, die Seite ist langsam oder unzuverlässig, oder der Link steckt hinter Skripten oder blockierten Elementen, die Google nicht schnell verarbeitet.

Setze die richtige Erwartung: schnellere Entdeckung ist nützlich, aber kein Ranking‑Versprechen. Selbst nachdem Google einen Link gefunden hat, bewertet es weiterhin Relevanz, Qualität, Platzierung und die Gesamtstärke deiner Seite. Häufige Recrawls verkürzen vor allem die Wartezeit.

Beispiel: Du bekommst an einem Tag zwei Links. Der eine wird auf einer beliebten News‑Seite hinzugefügt, die täglich aktualisiert wird, der andere auf einer alten Ressourcen‑Seite, die seit zwei Jahren nicht geändert wurde. Der erste Link wird oft schnell bemerkt, weil die Seite häufig revisitiert wird. Der zweite kann deutlich länger dauern, selbst wenn beide auf guten Seiten stehen.

Was eine Seite wahrscheinlich öfter recrawlt

Eine Seite wird „oft gecrawlt“, wenn Googlebot sie in regelmäßigen Abständen besucht, nicht nur gelegentlich. Das ist wichtig, weil neue Links auf dieser Seite schneller entdeckt werden und Änderungen rund um den Link eher neu gelesen werden.

Google crawlt nicht jede URL gleichmäßig. Es hat begrenzte Zeit für jede Site, also wählt es aus, was es erneut besuchen soll, basierend darauf, wie nützlich die Seite wirkt und wie wahrscheinlich es ist, dass sie sich geändert hat.

Signale, die meist zu häufigeren Recrawls führen

Seiten, die Google häufig erneut crawlt, teilen oft ähnliche Merkmale. Sie ändern sich genug, dass ein Zurückkehren sinnvoll ist, sie sind innerhalb der Site wichtig und sie sind leicht und zuverlässig abrufbar.

In der Praxis sieht das häufig so aus:

- Inhalte, die regelmäßig aktualisiert werden

- starke interne Verlinkung (viele Seiten derselben Site verweisen darauf)

- konstantes Nutzerinteresse (Seiten, die tatsächlich besucht werden)

- schnelles, fehlerfreies Laden

- eine klare Struktur, die Crawlern hilft, wichtige Seiten zu finden und erneut zu prüfen

Das garantiert kein tägliches Crawlen. Es erhöht nur die Wahrscheinlichkeit, dass die Seite auf einem kürzeren "wieder besuchen"‑Zyklus bleibt.

Wie Google entscheidet, was erneut besucht wird (auf hoher Ebene)

Stell dir Crawling als Mischung aus Priorität und Budget vor.

- Priorität ist, welche Seiten am wichtigsten sind.

- Budget ist, wie viel Google bereit ist, von einer Site abzurufen, ohne Ressourcen zu verschwenden.

Wenn eine Seite wichtig ist, sich oft ändert und auf einer gesunden Site liegt, wird sie wahrscheinlich schneller recrawlt. Wenn eine Seite schwer erreichbar ist, sich selten ändert oder in einem Abschnitt mit vielen minderwertigen URLs liegt, kann sie zurückfallen.

Einige Seiten haben von Natur aus niedrige Priorität fürs Recrawlen, selbst wenn sie indexiert sind: alte Beiträge, die nie aktualisiert werden, dünne Tag‑Seiten, tiefe Archive, die kaum jemand erreicht, einzelne Dateien ohne Kontext und große Gruppen nahezu identischer URLs (z. B. endlose gefilterte Varianten).

Wenn du einen Link‑Host auswählst, ist das der Grund, warum eine „gute Domain“ nicht die ganze Geschichte ist. Eine starke Site hilft, aber die spezifische Seite bestimmt oft, wie schnell der Link wiederentdeckt und aktualisiert wird.

Wie du erkennst, ob eine Seite häufig gecrawlt wird

Du kannst Googles exakten Crawl‑Plan nicht sehen, aber du kannst starke Hinweise sammeln. Das Ziel ist einfach: wähle Seiten, die Google oft besucht, damit neue Links schneller gefunden und aktualisiert werden.

Nutze Google Search Console für die klarsten Signale

Wenn du Zugang zur Site hast, die den Link hostet, ist Search Console der praktischste Startpunkt.

Die schnellsten Prüfungen sind:

- URL‑Prüfung: Prüfe die genaue verlinkende Seite und schaue nach „Letzter Crawl“. Wurde sie kürzlich gecrawlt und aktualisiert sich dieses Datum über die Zeit, ist das ein gutes Zeichen.

- Indexierungsstatus und abgerufene Seite: Wenn die Seite indexiert ist und der abgerufene Inhalt dem entspricht, was du erwartest, verarbeitet Google sie.

- Crawl‑Statistiken (Property‑weit): Das zeigt nicht den Plan einer einzelnen Seite, aber ob Googlebot die Site regelmäßig crawlt.

- Vergleiche ähnliche Seiten: Prüfe 3–5 Seiten desselben Typs (Posts, Kategorie‑Hubs, News‑Seiten). Häufig erkennt man Muster bei den "Last crawl"‑Daten.

Ein wichtiger Punkt: Eine Seite kann indexiert sein und trotzdem selten gecrawlt werden. „Indexiert“ bedeutet, sie ist in Googles Datenbank, nicht dass Google sie häufig besucht.

Prüfe Server‑Logs (wenn du sie hast)

Server‑Logs sind der direkteste Nachweis, weil sie echte Zugriffe zeigen. Achte auf Googlebot‑Anfragen zur genauen URL, nicht nur zur Startseite.

Konzentriere dich auf ein paar Basics: ob der User‑Agent Googlebot enthält, wie oft er die Seite trifft, ob die Antwortcodes sauber sind (200 ist ideal) und ob Googlebot bald nach Änderungen auftaucht.

Wenn du keinen Log‑Zugriff hast, frage den Site‑Inhaber nach einem einfachen Export der letzten 30 Tage.

Schnelle Spot‑Checks, die trotzdem helfen

Spot‑Checks sind schwächer als Search Console oder Logs, aber sie können deine Entscheidung stützen.

Wenn die Seite aktiv gepflegt wird (aktuelle Zeitstempel, neue Abschnitte, neue Kommentare, regelmäßige Bearbeitungen) und du bemerkst, dass Suchausschnitte oder gecachte Versionen Änderungen schnell widerspiegeln, passt das meist zu häufigeren Recrawls.

Kenne die Grenzen

Auch Seiten, die Google oft crawlt, können schwanken. Crawl‑Verhalten ändert sich mit Site‑Gesundheit, Server‑Performance, interner Verlinkung und der Änderungsfrequenz der Inhalte. Betrachte diese Prüfungen als Wahrscheinlichkeiten, nicht als Garantien.

Eine praktische Checkliste zur Auswahl der richtigen verlinkenden Seite

Wenn du willst, dass neue Links schnell gefunden werden, konzentriere dich nicht nur auf die Domain. Die spezifische Seite zählt. Seiten, die Google häufig recrawlt, wirken aktiv, wichtig und leicht erreichbar.

Nutze dies als Schnellfilter:

- Aktuelle Updates: Seiten, die regelmäßig neue Inhalte veröffentlichen oder Inhalte auffrischen (News‑Hubs, Änderungsprotokolle, Kategorie‑Seiten „Neueste“), werden eher revisitiert als Seiten, die nie geändert werden.

- Klare interne Pfade: Die Seite sollte über Hauptnavigation oder andere beliebte Seiten erreichbar sein. Wenn man sie in ein oder zwei Klicks erreicht, können Crawler das meist auch.

- Echte Aufmerksamkeit: Seiten mit stetigen Besuchen haben oft mehr interne Links und werden stärker gepflegt.

- Schnell und einfach zu laden: Wenn der Hauptinhalt stark von Scripts abhängt, können Crawler wichtige Elemente verpassen oder verzögert verarbeiten.

- Keine Crawl‑Barrieren: Vermeide Seiten, die durch robots.txt blockiert sind, mit „noindex“ markiert sind, hinter Logins liegen oder in endlosen Parameter‑Varianten hängen.

Ein guter Reality‑Check: Wenn sich die Seite wie ein aktiver Teil der Site anfühlt, wird sie wahrscheinlich häufiger recrawlt.

Warnsignale, die die Entdeckung verlangsamen

Zwei Probleme tauchen immer wieder auf.

Erstens: Waisen‑ oder fast waisen Seiten. Wenn wenige oder keine internen Links auf die Seite zeigen, findet Google sie vielleicht einmal und besucht sie danach selten erneut.

Zweitens: Seiten, bei denen der Link erst nach umfangreichem clientseitigem Rendering sichtbar wird. Wenn der Hauptinhalt spät oder inkonsistent lädt, verzögert sich die Entdeckung.

Beispiel: Ein Backlink auf einer wöchentlich aktualisierten „Release Notes“‑Seite wird meist schneller erkannt als auf einer vergrabenen „Ressourcen“‑Seite, die seit zwei Jahren unverändert ist, selbst wenn beide auf derselben Domain liegen.

Schritt‑für‑Schritt: Wähle eine Seite, die recrawlt wird

Beim Platzieren eines Backlinks ist das Ziel klar: Google soll ihn schnell finden und bei zukünftigen Besuchen weiter sehen. Das passiert eher auf Seiten, die Google oft crawlt, nicht auf vergessenen Seiten, die monatelang unverändert bleiben.

Eine einfache 5‑Schritte‑Methode

Sammle zuerst einige passende Plätze für deinen Link auf der Ziel‑Site und filtere sie dann:

- Liste 3–8 Kandidatenseiten auf, wo ein Link natürlich wirkt (aktueller Artikel, Ressourcen‑Seite, Tools‑Liste, Kategorie‑Hub).

- Stelle sicher, dass die Seite indexierbar ist. Achte auf „noindex“, Canonicals, die woandershin zeigen, und Login‑Seiten.

- Prüfe auf Frische‑Signale. Bevorzuge Seiten mit offensichtlichen aktuellen Änderungen, neuen Abschnitten, aktiver Pflege oder regelmäßigen Ergänzungen.

- Sorge dafür, dass die Seite leicht erreichbar ist. Seiten, die aus Navigation, Kategorie‑Hubs oder beliebten Beiträgen heraus verlinkt sind, sind schwerer für Crawler zu ignorieren.

- Wähle die beste Balance: Relevanz zuerst, Geschwindigkeit zweitens. Eine schnelle, aber themenfremde Seite kann zu einer schwachen oder unpassenden Platzierung werden.

Kurzes Beispiel

Stell dir vor, du kannst einen Link entweder auf (A) einer älteren „Resources“‑Seite aus 2021 oder (B) einem Kategorie‑Hub platzieren, auf dem jede Woche neue Einträge erscheinen. Selbst wenn beide indexierbar sind, wird (B) eher recrawlt, weil es sich ändert und näher an der Hauptnavigation liegt.

Balance zwischen Recrawl‑Geschwindigkeit und thematischer Relevanz

Schnelle Entdeckung ist gut, aber Relevanz macht einen Link wertvoll. Google versucht zu verstehen, warum deine Seite für bestimmte Suchanfragen ranken sollte. Ein Backlink hilft am meisten, wenn er in einer Seite sitzt, die bereits dasselbe Thema (oder ein eng verwandtes) behandelt. Ist die Host‑Seite irrelevant, tauschst du eine kleine Geschwindigkeitsvorteil gegen eine schwächere Aussage, und die Platzierung kann unnatürlich wirken.

Was „Kontext" bedeutet (einfach erklärt)

Kontext ist die Umgebung um deinen Link. Google liest den Text nahe dem Link und das Seitenthema, um zu verstehen, worum es bei dem Link geht. Es ist nicht nur Ankertext.

Kontext umfasst meist das Hauptthema der Seite (Titel, Überschriften, Gesamtinhalt), den Absatz um den Link, wie natürlich er sich einfügt (hilft er dem Leser?) und nahe Begriffe und Beispiele.

Ein Link zu einem Payroll‑Tool in einem Artikel über Einstellung und Onboarding macht Sinn. Derselbe Link in einer Filmkritik wirkt fehl am Platz.

Verfolge nicht nur Crawl‑Speed mit unpassenden Platzierungen

Links auf häufig aktualisierten, aber thematisch unpassenden Seiten (generische News‑Feeds, tägliche Deals, breite „Alles“‑Hubs) können nach hinten losgehen. Selbst wenn Google den Link schnell findet, wird das Signal verwässert, weil die Seite das Thema nicht unterstützt. Leser ignorieren solche Links meist — ein gutes Zeichen dafür, dass die Platzierung wenig bringt.

Praktische Regel: Unter den Seiten, die thematisch passen, wähle jene, die am stärksten gepflegt werden.

Übliche Seitentypen und ihr Verhalten

Nicht alle Seiten bekommen die gleiche Aufmerksamkeit von Google. Wenn du willst, dass Backlinks schneller entdeckt werden, hilft es zu wissen, welche Seitentypen typischerweise öfter revisitiert werden und welche Kompromisse du dabei eingehst.

- Startseiten werden oft häufig gecrawlt, besonders bei aktiven Sites. Links können dort aber rotieren oder verschwinden bei Redesigns, saisonalen Bannern oder Modul‑Änderungen.

- Kategorie‑ und Hub‑Seiten sind starke Verbindungspunkte. Sie werden aktualisiert, wenn neue Items hinzugefügt werden, und haben meist viele interne Pfade. Sie bieten oft ein gutes Gleichgewicht aus Crawl‑Häufigkeit und Stabilität.

- Frische Beiträge und News‑Seiten können kurz nach Veröffentlichung schnell gecrawlt werden. Mit der Zeit können ältere Beiträge in der Pagination verschwinden und die Recrawls verlangsamen sich.

- Evergreen‑Ressourcenseiten (Guides, Tools, „Best of“‑Listen, Dokumentation) können Links langfristig stabil halten. Wenn sie sich jedoch kaum ändern, besucht Google sie seltener.

- Footer und andere siteweite Bereiche werden zwar gecrawlt, wirken aber oft wie Boilerplate. Sie sind außerdem bei Template‑Änderungen leicht zu entfernen.

Wenn Geschwindigkeit das Hauptziel ist, ist eine gut vernetzte Hub‑Seite oder ein häufig aktualisierter Bereich meist sicherer als ein Startseiten‑Slot, der schnell rotieren kann. Für langfristigen Wert priorisiere Seiten, die wichtig bleiben und deinen Link an einem klaren, beständigen Ort halten.

Häufige Fehler, die Entdeckung verlangsamen oder den Link schwächen

Ein Link kann live sein und trotzdem lange brauchen, um die erwartete Wirkung zu zeigen. Die meisten Verzögerungen und schwachen Ergebnisse kommen von einigen leicht vermeidbaren Fehlern.

Fehler 1: Zu glauben, „indexiert“ heißt „wird oft gecrawlt"

Indexiert zu sein bedeutet nur, dass Google die Seite kennt. Es heißt nicht, dass Google sie oft besucht. Manche Seiten werden täglich gecrawlt, andere nur, wenn Google einen Grund dafür hat.

Wenn die Seite selten verändert wird und wenige Besucher hat, hat Google weniger Anreiz, zurückzukehren.

Fehler 2: Auf „frische" Seiten setzen, die nichts mit deinem Thema zu tun haben

Schnell aktualisierte Seiten werden oft recrawlt. Sind sie aber thematisch unpassend, wirkt der Link fehl am Platz und bringt weniger Wert.

Geschwindigkeit ist nur dann hilfreich, wenn die Seite auch Sinn für dein Thema ergibt.

Fehler 3: Seiten wählen, die intern kaum erreichbar sind

Google findet und revisitiert Seiten oft über Links. Hat die verlinkende Seite wenige interne Verweise, ist tief in der Navigation versteckt oder faktisch ein Waisenkind, wird sie weniger häufig gecrawlt.

Prüfe, ob die Seite normal durch Menüs, Kategorien oder verwandte Posts erreichbar ist.

Fehler 4: Von Seiten verlinken, die blockiert, weitergeleitet oder kanonisiert sind

Typische Probleme sind robots‑Sperren, „noindex“, Redirects, Canonicals, die auf andere URLs zeigen, und Seiten hinter Paywalls oder Logins. In solchen Fällen ignoriert Google die Seite möglicherweise oder behandelt sie als sekundär, was Entdeckung und Wert verzögern oder verhindern kann.

Fehler 5: Auf Geschwindigkeit setzen und dabei Stabilität der Platzierung vergessen

Ein Link, der nur kurz auf einer stark wechselnden Seite erscheint (rotierende Widgets, „aktuelle Links“‑Module, häufig bearbeitete Listen), kann schnell entdeckt und dann wieder entfernt werden.

Wenn du für Platzierungen bezahlst, priorisiere Links, die dauerhaft bleiben.

Beispiel‑Szenario: Zwei Links, sehr unterschiedliche Recrawl‑Zeiten

Ein kleiner Handwerksbetrieb startet eine neue Seite für „Notdienst Heizkessel“. Der Inhaber fügt die Seite in die Hauptnavigation ein, schreibt einen klaren Titel und teilt sie mit einigen Partnern.

Zwei Backlinks gehen in derselben Woche live, verhalten sich aber sehr unterschiedlich.

Der erste Link steht in einem lokalen „Empfohlene Anbieter“‑Verzeichnis, das fast nie geändert wird. Es ist eine alte Liste, die der Seitenbetreiber ein‑ bis zweimal im Jahr aktualisiert.

Der zweite Link steht auf einem aktiven „Heiztipps“‑Hub eines Publishers. Dieser Hub bekommt oft neue Abschnitte (saisonale Checklisten, kurze Updates) und gehört zu den Seiten, die Google eher häufig crawlt.

In den nächsten 2–4 Wochen zeigt sich ein übliches Muster:

- Der Hub‑Seiten‑Link wird schneller bemerkt, weil die Seite öfter revisitiert wird.

- Der Verzeichnis‑Link bleibt zwar sichtbar, kann aber länger ruhig bleiben, weil die Seite keine Crawl‑Priorität hat.

Während dieses Zeitraums beobachtet der Betrieb einige Signale: Search Console‑Impressionen für die neue Service‑Seite, Indexierungsstatus, Referral‑Besuche von den verlinkenden Seiten, Crawl‑Aktivität und Rankings für ein paar spezifische Begriffe.

Die Erkenntnis: Es geht nicht nur um „gute Domains“, sondern darum, wo genau auf der Site der Link lebt. Für schnellere Entdeckung und Aktualisierung bevorzugst du aktive, regelmäßig aktualisierte Seiten — solange das Thema passt.

Nächste Schritte: Link‑Entdeckung vorhersehbarer machen

Wenn du willst, dass neue Backlinks schneller auftauchen und in Googles Sicht frisch bleiben, brauchst du eine wiederholbare Methode zur Auswahl der Host‑Seite und eine einfache Art, den Fortschritt zu prüfen. Das Ziel ist nicht Perfektion, sondern weniger Überraschungen.

Eine 3‑Fragen‑Entscheidungsregel

Bevor du eine verlinkende Seite freigibst, frage dich:

- Wird diese Seite oft aktualisiert oder überprüft?

- Bekomme sie bereits Aufmerksamkeit durch interne Links oder echte Nutzeranfragen?

- Passt der Link natürlich zum Thema, oder wirkt er nur für SEO hinzugefügt?

Sind die ersten beiden Fragen mit „Ja“ beantwortet und wirkt die dritte natürlich, bist du meistens in einer guten Position für schnellere Entdeckung und stärkeren Wert.

Eine einfache 30‑Tage‑Tracking‑Routine

Halte es leicht und konsistent:

- Verfolge Host‑URL, Ziel‑URL, Platzierungsdatum und den Ankertext.

- Prüfe wöchentlich, ob die Host‑Seite kürzlich geändert wurde (neue Abschnitte, Layout‑Updates, aktualisierte Daten).

- Achte auf einfache Sichtbarkeitszeichen: Impressionen, Referral‑Besuche und ob die Host‑Seite aktiv gepflegt wirkt.

- Nach 2–4 Wochen vergleiche Platzierungen und notiere, welche Seitentypen schneller aufgefallen sind.

Wenn du Platzierungen kaufst, sei klar in deinen Anforderungen: Bitte um thematisch passende Seiten, die aktiv gepflegt werden, nicht um vergessene Archivseiten. Eine starke Domain allein reicht nicht, wenn die konkrete Seite selten revisitiert wird.

Wenn du Trial‑und‑Error beim Sourcing hochautoritativer Platzierungen vermeiden möchtest, ist SEOBoosty (seoboosty.com) eine Option: Es bietet Premium‑Backlinks von autoritativen Seiten über ein kuratiertes Inventar, sodass du die gleiche Logik anwenden und indexierbare, gut vernetzte Seiten bevorzugen kannst, die regelmäßig aktualisiert werden.

FAQ

Warum ist mein neuer Backlink live, aber noch nicht in Google sichtbar?

Die meisten Verzögerungen entstehen, weil Google die genaue Seite, auf der dein Link hinzugefügt wurde, noch nicht erneut besucht hat. Wenn diese Seite oft gecrawlt wird, wird der Link innerhalb von Tagen bemerkt; wird sie selten revisitiert, kann es Wochen dauern. Für Menschen ist der Link sofort sichtbar, nur die Suchtools hinken manchmal nach.

Was ist der Unterschied zwischen Crawling und Indexierung?

Crawling bedeutet, dass Googlebot eine Seite besucht und den Inhalt liest. Indexierung heißt, dass Google die Seite in seine Suchdatenbank aufnimmt, damit sie in den Ergebnissen erscheinen kann. Eine Seite kann gecrawlt, aber nicht indexiert sein. Ein Link kann während eines Crawls gesehen werden, aber es kann dauern, bis er in Reporting‑Tools konsistent auftaucht.

Woran erkenne ich, ob eine Seite häufig gecrawlt wird?

Ein aktuelles „Last crawl“‑Datum auf der verlinkenden Seite ist ein starkes Indiz, besonders wenn dieses Datum über die Zeit aktualisiert wird. Ein weiteres Zeichen ist, dass die Seite aktiv gepflegt und von wichtigen Stellen der Website erreichbar ist — das führt meist zu häufigeren Revisits. Ohne Zugriff auf Search Console oder Logs kannst du nur Wahrscheinlichkeiten einschätzen, kein Versprechen bekommen.

Was macht Google eher dazu, eine Seite erneut zu crawlen?

Seiten werden eher wieder besucht, wenn sie wichtig wirken und sich wahrscheinlich ändern. Typische Merkmale: starke interne Verlinkung, echte Nutzeraufmerksamkeit und zuverlässiges, fehlerfreies Laden. Seiten, die tief in Archiven liegen oder sich selten ändern, landen oft in einem langsameren Revisit‑Zyklus.

Garantiert schnelleres Recrawlen bessere Rankings?

Nein — häufigeres Recrawlen verkürzt vor allem die Wartezeit bis zur Entdeckung und Aktualisierung. Rankings hängen weiterhin von Relevanz, Qualität, Platzierung und davon ab, wie gut deine eigene Seite das Thema unterstützt. Schnelle Entdeckung macht einen schwachen oder thematisch unpassenden Link nicht automatisch wertvoll.

Auf welchen Seitentypen wird mein Link normalerweise schneller entdeckt?

Kategorieseiten und Hubs bieten oft ein gutes Gleichgewicht, weil sie zentral in der Seitenstruktur stehen und beim Hinzufügen neuer Items aktualisiert werden. Frische Artikel können direkt nach der Veröffentlichung schnell gecrawlt werden, veralten aber mit der Zeit oft. Alte Ressourcen‑Seiten können Links lange halten, werden aber seltener revisitiert, wenn sie sich kaum ändern.

Wie wichtig ist interne Verlinkung auf der Host‑Site für Recrawls?

Schwache oder fehlende interne Verlinkung ist eine häufige Ursache. Wenn die Seite nah an der Hauptnavigation liegt und von wichtigen Seiten referenziert wird, hat Google mehr Pfade zurück und mehr Gründe zum Wiederbesuch. Ist eine Seite quasi ein Waisenkind, kann sie einmal gefunden und dann lange ignoriert werden.

Kann JavaScript oder Rendering verhindern, dass Google meinen Backlink sieht?

Ja. Wenn ein Link erst spät durch JavaScript geladen wird oder stark clientseitig gerendert wird, kann er für Crawler schwerer oder langsamer zu verarbeiten sein. Wenn der Link hinter Skripten, inkonsistentem Rendering oder blockierten Ressourcen steckt, verzögert sich die Entdeckung. Eine serverseitig gerenderte, saubere Platzierung ist zuverlässiger.

Welche Host‑Seiten‑Probleme können verhindern, dass mein Backlink zählt?

Wenn die Host‑Seite durch robots‑Regeln blockiert ist, mit noindex markiert wird, weitergeleitet oder kanonisiert auf eine andere URL verweist, kann Google sie ignorieren oder als sekundär behandeln. In solchen Fällen erzielt der Link möglicherweise nie den erwarteten Wert, auch wenn er im Browser sichtbar ist. Am sichersten ist eine klar indexierbare Seite, deren Canonical auf sich selbst zeigt und deren Inhalt ohne Barrieren zugänglich ist.

Wie kann ich einfach verfolgen, ob ein Backlink innerhalb des nächsten Monats bemerkt wird?

Verfolge die Host‑URL, die Ziel‑URL, das Platzierungsdatum und den exakten Platz, damit du später vergleichen kannst. Prüfe wöchentlich, ob die Host‑Seite verändert oder stabil gehalten wurde, und schaue nach Sichtbarkeitszeichen wie Impressionen, Referral‑Besuchen und Crawl/Index‑Signalen (wenn du Zugriff hast). Nach 2–4 Wochen kannst du Rückschlüsse ziehen und Muster erkennen.