Demuestra el impacto de los backlinks con registros del servidor antes de que cambien los rankings

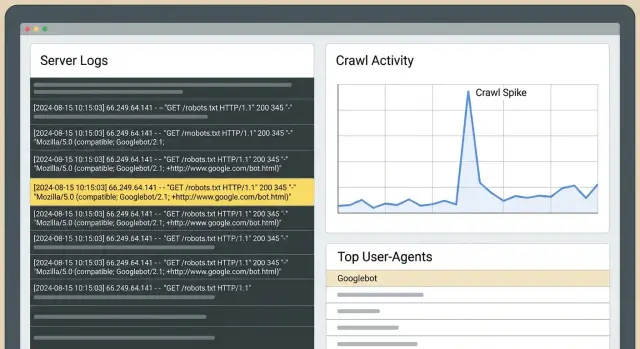

Demuestra el impacto de backlinks con registros del servidor: sigue picos de rastreo de Googlebot, analiza rutas de bots y la frecuencia de fetches para confirmar efectos antes de que cambien los rankings.

Lo que puedes demostrar con los registros antes de que los rankings cambien

Los rankings suelen retrasarse. Google tiene que volver a rastrear páginas, procesar nuevas señales, actualizar el índice y luego decidir si debe cambiar posiciones. Ese retraso es la razón por la que puedes hacer buen trabajo y no ver movimiento en los rastreadores de ranking durante días o semanas.

Los registros del servidor están más arriba en esa cadena. Pueden responder una pregunta más simple: ¿cambió Googlebot lo que hace en tu sitio después de que los enlaces se publicaron? Si la respuesta es sí, tienes evidencia de que pasó algo real, aunque el tráfico y los rankings sigan planos.

Los cambios más rápidos y visibles en los registros suelen parecerse a esto:

- La página enlazada se rastrea con más frecuencia, o empieza a rastrearse por primera vez.

- Googlebot vuelve a esa página antes (intervalos más cortos entre fetches).

- Googlebot usa esa página como punto de entrada y luego sigue enlaces internos hacia zonas más profundas del sitio.

- Ves ráfagas de rastreo poco después de la publicación, especialmente cuando el sitio que enlaza se rastrea con frecuencia.

Esto es diferente de Search Console y los rastreadores de ranking. Search Console es útil, pero tiene retrasos y agrupa datos. Los rastreadores muestran resultados, no causas. Los registros muestran comportamiento bruto: cada petición, con marca de tiempo, qué bot pidió qué URL y qué código de estado devolvió tu servidor.

El método central es sencillo: elige una ventana limpia de “antes” y otra de “después”, y compara la actividad de Googlebot para las URLs específicas que atacaste. Si el periodo “después” muestra una tasa de rastreo mayor y rutas más intencionales, puedes decir que los enlaces cambiaron la atención de Google.

Ejemplo: apuntas un nuevo backlink a una página de producto. Dos días después, los registros muestran a Googlebot solicitando esa página repetidamente y luego pidiendo la página de especificaciones y la de precios a las que enlaza. Los rankings pueden no moverse aún, pero Google claramente está gastando presupuesto de rastreo ahí. Ese suele ser el primer paso visible antes de ganancias más amplias.

Conceptos básicos de registros del servidor (en lenguaje sencillo)

Un registro del servidor es un diario de las solicitudes a tu sitio. Cada vez que un navegador, una app o un bot de buscador pide una página o un archivo, tu servidor (o CDN) registra una línea.

Para comprobaciones de SEO, los campos que más importan son: marca de tiempo, URL solicitada, user-agent (como Googlebot), código de estado (200, 301, 404) y normalmente una dirección IP. No necesitas memorizar cada columna. Cada línea responde: quién pidió qué, cuándo y qué ocurrió.

¿Qué registros deberías usar?

Empieza con los registros de acceso del origen si puedes. Son los más cercanos a la “verdad” e incluyen las URLs exactas y los códigos de respuesta.

Si usas un CDN/WAF/capa de protección de bots, sus registros pueden aportar contexto (solicitudes bloqueadas, desafíos), pero pueden filtrar o etiquetar tráfico de maneras que oculten parte de la imagen. Cuando sea posible, conserva ambos y anota reglas de filtrado que puedan cambiar lo que ves.

¿Cuánto tiempo deberías guardar los registros?

La retención importa para comparaciones antes-vs-después. Treinta días es un mínimo práctico. Sesenta a noventa días es mejor si construyes enlaces en oleadas o publicas con frecuencia. Quieres suficientes datos “antes” para entender el rastreo normal y suficientes datos “después” para ver si la frecuencia de visitas y las rutas de rastreo realmente cambiaron.

Sobre privacidad: guarda solo lo que necesitas, limita el acceso y borra según un calendario. Si los registros contienen datos personales (por ejemplo, IPs completas o strings de consulta con emails), enmascara o elimina esos campos. Para este tipo de análisis, lo que importa es el comportamiento del bot, los códigos de estado y las rutas de página.

Detectar Googlebot real vs ruido

Antes de interpretar cualquier “pico”, asegúrate de que el tráfico de Googlebot en tus registros sea realmente Google. Los bots falsos a menudo copian el user-agent de Google. Si los cuentas, puedes “probar” un aumento de rastreo que nunca ocurrió.

Los user-agents son un punto de partida (Googlebot, Googlebot-Image, AdsBot-Google), pero no son prueba suficiente.

Por qué aparecen bots falsos

Suplantar a Google ayuda a los scrapers a evitar bloqueos, sondear sitios o extraer contenido a gran escala. También pueden inflar solicitudes a URLs específicas y hacer que parezca que Google se interesó justo después de que construiste enlaces.

Formas simples de validar Googlebot

Escoge un enfoque y úsalo de forma consistente:

- Verificación reverse DNS: la IP debe resolverse a un hostname propiedad de Google y ese hostname debe resolverse de nuevo a la misma IP.

- Comprobaciones de patrón: el Googlebot real tiende a mostrar comportamiento estable (peticiones regulares a robots.txt, navegación con sentido).

Si puedes, separa Googlebot Smartphone de Googlebot Desktop. Suelen comportarse de forma distinta. Un cambio puede aparecer primero en Smartphone mientras Desktop se mantiene plano.

Cuatro señales en los registros que sugieren que los enlaces cambiaron el comportamiento

Los rankings van por detrás de lo que Googlebot ya está haciendo. Después de que una colocación se publica, estas son las señales tempranas en registros que merece la pena vigilar.

Señal 1: Aumento sostenido de rastreo en la página objetivo

Una señal fuerte es un incremento notable de solicitudes de Googlebot a la página a la que apuntaste, sostenido durante varios días. Compara iguales contra iguales (mismos días de la semana) para no confundir ciclos semanales normales con un “avance”.

Señal 2: Mayor frecuencia de fetch (ciclos de revisita más cortos)

Cuando Google se interesa más, suele volver antes. En los registros verás intervalos más cortos entre hits a la misma URL. Esto puede ocurrir mucho antes de cualquier ascenso en rankings, especialmente para páginas que antes se rastreaban poco.

Señal 3: Rutas de bot que se expanden desde la página de aterrizaje

Después de que Googlebot visite la página enlazada, revisa qué solicita a continuación en la misma sesión o dentro de una ventana de tiempo corta. Si mejoró el descubrimiento, verás un movimiento más consistente desde la página objetivo hacia URLs relacionadas (páginas de categoría, artículos de apoyo, páginas de producto clave).

Señal 4: Rastreos por primera vez en URLs cercanas

Si la página objetivo enlaza a otras páginas que casi no se rastreaban, vigila las primeras solicitudes a esas URLs. Ese patrón de “despliegue” suele significar que Googlebot está explorando y no solo revisando una página.

En las cuatro señales, los códigos de estado deciden si el rastreo es útil:

- 200 significa que Googlebot recibió contenido que puede evaluar.

- 301 no siempre es malo, pero las cadenas largas de redirección desperdician presupuesto de rastreo.

- 404 puede crear picos ruidosos sin valor.

- 5xx a menudo llevan a caídas de rastreo después.

Configura una comparación antes-y-después que puedas confiar

El mayor riesgo con la validación basada en registros es una comparación desordenada. Googlebot cambia su comportamiento por muchas razones, así que tu configuración debe hacer que “el enlace se publicó” sea la variable principal.

Usa dos ventanas iguales: comúnmente 14 a 28 días antes de que el enlace se publique (línea base) y el mismo número de días después.

Luego rastrea un conjunto pequeño y específico de páginas:

- La URL que recibió el nuevo enlace.

- La página que realmente te interesa (si es diferente).

- 2 a 3 páginas estrechamente relacionadas en la misma sección del sitio.

- Una página de control en la misma plantilla/carpeta que no recibió nuevos enlaces.

Para cada página, sigue hits diarios de Googlebot, URLs únicas rastreadas en ese clúster y la mediana del tiempo entre fetches. La mediana es más estable que la media cuando las ráfagas de rastreo distorsionan los datos.

Antes de comparar, haz comprobaciones rápidas: confirma que el enlace está activo y es indexable en la ventana “después”, evita grandes cambios del sitio dentro de las ventanas (migraciones, cambios de plantilla), aplica las mismas reglas de validación y filtrado de bots, y mantén la página de control comparable.

Paso a paso: validar el impacto de un enlace desde los registros

No necesitas que los rankings se muevan para ver cambios tempranos en el comportamiento. Si el enlace fue descubierto y tratado como señal significativa, los registros suelen mostrarlo primero.

Un flujo de trabajo práctico:

- Extrae registros crudos para una ventana limpia de “antes” y otra igual de “después”.

- Filtra a solicitudes de Googlebot verificadas y separa Smartphone de Desktop si está disponible.

- Agrupa por URL y por día. Busca aumentos concentrados en las páginas que apuntaste, no solo un incremento a nivel del sitio.

- Revisa rutas: después de que Googlebot solicita la página enlazada, ¿qué pide a continuación?

- Escribe una frase de conclusión por página usando siempre la misma plantilla.

Mantén las conclusiones estrictas y comprobables. Por ejemplo: “Después de que el enlace se publicó, Googlebot Smartphone aumentó las fetches a /pricing de 3 por semana a 11 por semana y luego rastreó /features y /checkout en 10 minutos, lo cual no ocurrió en la ventana base.”

Si no puedes escribir una frase clara así, la ventana de comparación probablemente es ruidosa o estás mezclando Googlebot con otros rastreadores.

Interpretar rutas de bot: qué hace Googlebot después de encontrar un enlace

Cuando se descubre un nuevo backlink, Googlebot rara vez cambia rankings de la noche a la mañana. A menudo cambia primero su ruta por tu sitio. El análisis de rutas es leer las huellas de Googlebot: qué solicita primero, qué solicita después y con qué frecuencia vuelve.

Ten en mente dos URLs distintas:

- La URL enlazada (donde apunta el backlink).

- La página “de valor” (la página que quieres posicionar).

A menudo la URL enlazada se calienta primero y luego transmite atención por enlaces internos.

Una comparación útil son los puntos de entrada. Antes del enlace, Googlebot podía entrar por tu homepage o sitemap. Después, puedes ver a Googlebot aterrizar directamente en la URL enlazada y luego moverse más profundo por enlaces internos.

Vigila estos cambios:

- Más hits frecuentes en la URL enlazada.

- Páginas más profundas rastreadas antes y con más constancia.

- Ciclos de actualización más cortos en las páginas del clúster.

- Picos en URLs con parámetros o duplicadas (a menudo signo de desperdicio de rastreo, no de progreso).

Si aparecen picos en URLs con parámetros (como ?sort= o paginación), el backlink aún puede estar ayudando, pero los registros también te dicen que elimines trampas de rastreo para que Googlebot dedique tiempo a tus páginas importantes.

Errores comunes que llevan a conclusiones falsas

Los registros pueden dar pruebas tempranas, pero también magnificar el ruido normal.

El fallo más común es comparar dos periodos que en realidad no son comparables. Los aumentos de rastreo pueden ser causados por rediseños, cambios de navegación, lanzamientos de nuevas páginas, ediciones de robots.txt, reglas de WAF/firewall y problemas de códigos de estado (cadenas de redirección, picos de 404, errores 5xx).

Otro error frecuente es contar todos los bots, incluidos los user-agents suplantados.

Antes de confiar en un “éxito”, comprueba lo básico: compara los mismos días de la semana, revisa cambios en robots e indexación en la ventana, desglosa resultados por código de estado (200 vs 3xx vs 4xx/5xx), filtra solo Googlebot verificado y busca un aumento sostenido en lugar de un pico de un día.

Ejemplo: compras un backlink a /pricing y dos días después Googlebot solicita /pricing 5 veces más. Pero si también lanzaste un rediseño que añadió enlaces en el header a /pricing, el aumento puede deberse al descubrimiento interno, no al backlink.

Lista rápida: ¿los nuevos enlaces cambiaron el comportamiento de Google?

Usa la misma ventana de tiempo en ambos lados (por ejemplo, 14 días antes vs 14 días después). Filtra a solicitudes de Googlebot verificadas y responde estas preguntas:

- ¿Aumentaron de forma significativa las solicitudes a la URL objetivo enlazada?

- ¿El rastreo se volvió más estable a lo largo de la semana en lugar de un pico aislado?

- ¿Disminuyó el tiempo típico entre fetches para la URL objetivo y sus páginas cercanas de apoyo?

- ¿Se mantuvieron estables las tasas de error mientras aumentaba el rastreo?

- ¿Una página de control similar se mantuvo relativamente plana?

Si tienes tres o más respuestas “sí”, es probable que el comportamiento de Googlebot haya cambiado incluso si las posiciones aún no se movieron.

Dos comprobaciones extra mantienen esto honesto: asegúrate de que el cambio no sea a nivel del sitio y que el tiempo coincida (empieza poco después de la publicación y se mantiene elevado).

Escenario de ejemplo: demostrar impacto para una página en 3 semanas

Una empresa SaaS tiene una página de funciones que convierte bien, pero aún no recibe mucho tráfico orgánico. Añaden tres nuevos backlinks que apuntan directamente a esa página. Quieren prueba de que algo cambió sin esperar a los rankings.

Antes de que los enlaces se publiquen, extraen una línea base de los registros del servidor para esa URL: hits diarios de Googlebot, los tiempos entre hits y qué URLs visita Googlebot justo después.

Semana 1: en pocos días los registros muestran un aumento de rastreo. Más importante, Googlebot no se queda en la página de funciones. Empieza a explorar rutas cercanas, como precios, integraciones y artículos de apoyo. Ese comportamiento de “fan out” suele señalar un nuevo punto de entrada.

Semana 2 a 3: la tasa de revisita aumenta y los intervalos de rastreo se reducen. También puedes ver más respuestas 304 (not modified), lo cual es normal cuando Google vuelve con frecuencia y el contenido no ha cambiado.

Para explicarlo a un interesado sin hablar de rankings, muestra el cambio de comportamiento: antes vs después en solicitudes diarias a la página de funciones, mediana de horas entre visitas y las URLs más comunes que se rastrearon tras visitar la página de funciones.

Si los registros no muestran cambios después de 2–3 semanas, no asumas que los enlaces fallaron. Revisa bloqueos (robots.txt, noindex, 4xx/5xx), refuerza el enlazado interno hacia la página y replantea si el objetivo del enlace debería ser una página hub en lugar de la página final.

Próximos pasos: convierte la prueba en un proceso repetible

Cuando puedas validar efectos de enlaces en registros, hazlo una rutina mensual. Mantén una ventana consistente (por ejemplo, los últimos 30 días) e informa siempre las mismas métricas: qué páginas recibieron más hits de Googlebot, dónde se concentraron los aumentos de rastreo tras el trabajo de enlaces, cómo cambiaron las medianas de tiempo entre fetches en páginas clave, qué rutas aparecieron o se fortalecieron y qué errores podrían estar desperdiciando rastreo.

Si usas un proveedor como SEOBoosty (seoboosty.com) para asegurar colocaciones, lleva un registro de las fechas exactas de activación y las URLs objetivo. Unos plazos limpios hacen que las comparaciones antes-y-después de registros sean mucho más fáciles de confiar.

FAQ

¿Por qué los registros pueden mostrar progreso aunque los rankings no se muevan?

Los rankings requieren recrawl, procesamiento de señales, actualizaciones del índice y luego una re-evaluación de las posiciones. Los registros están más arriba en esa cadena, así que pueden mostrar si Googlebot cambió su comportamiento de rastreo poco después de que un enlace se publicó, incluso cuando los rastreadores de rankings siguen planos.

¿Cuál es la señal más clara en los registros de que se detectó un nuevo backlink?

Busca un aumento sostenido en las visitas de Googlebot verificadas a la URL exacta enlazada, además de intervalos más cortos entre las visitas. La confirmación más fuerte es cuando Googlebot aterriza en la página enlazada y luego rastrea de forma consistente páginas más profundas que te importan poco después.

¿Cuánto deberían durar mis ventanas de “antes” y “después”?

Usa ventanas iguales a ambos lados de la fecha de publicación, comúnmente de 14 a 28 días antes y el mismo periodo después. Compara los mismos días de la semana, porque los patrones de rastreo suelen variar entre fines de semana y días laborables.

¿Qué registros debería usar: registros de origen o registros de CDN/WAF?

Empieza por los registros de acceso del origen porque son lo más cercano a la "verdad" y contienen los códigos de estado precisos. Si dependes de un CDN, WAF o protección de bots, conserva también esos registros pero trátalos como complementarios: el filtrado y los desafíos pueden ocultar o etiquetar solicitudes.

¿Cómo aseguro que “Googlebot” en mis registros es realmente Google?

No confíes solo en el user-agent porque los bots falsos lo copian. El método práctico es la verificación reverse DNS: la IP debe resolverse a un hostname propiedad de Google y ese hostname debe resolverse de nuevo a la misma IP, así estás contando Googlebot real.

¿Debo separar Googlebot Smartphone de Desktop en el análisis?

Sepáralos cuando puedas, porque a menudo rastrean diferente y los cambios pueden aparecer en uno antes que en el otro. Si solo miras una vista combinada, un cambio real puede diluirse y parecer “sin cambios”.

¿Cómo distingo una subida real de rastreo de ruido normal?

Un cambio real suele mantenerse varios días y concentrarse en las páginas que apuntaste, no solo en un pico de un día. Además, confirma que el momento coincide con la publicación del enlace y que tu página de control se mantiene estable.

¿Qué códigos de estado importan más al juzgar cambios de rastreo?

Un 200 significa que Googlebot recibió contenido que puede evaluar, así que los aumentos de rastreo son útiles. Las 301 frecuentes y las cadenas largas de redirección desperdician presupuesto de rastreo, los picos de 404 generan actividad engañosa y los errores 5xx pueden provocar reducciones de rastreo después.

¿Cómo analizo las rutas de bot después de que se rastrea la página enlazada?

Sigue los puntos de entrada y qué solicita Googlebot después de visitar la URL enlazada dentro de una ventana de tiempo corta. Si la página enlazada se vuelve un punto de partida consistente y Googlebot luego rastrea páginas relacionadas (como precios, especificaciones o contenido de apoyo), es una buena señal de que el enlace mejoró la detección.

¿Cuál es la mejor forma de reportar el impacto de backlinks desde los registros a un interesado?

Escribe una frase estricta y comprobable por URL objetivo que indique el cambio antes vs después en volumen de rastreos y frecuencia de revisita, más un cambio observado en la ruta si existe. Si usas un proveedor como SEOBoosty, conserva las fechas exactas de activación y las URLs objetivo para que tus ventanas de comparación sean limpias y tus conclusiones creíbles.