Limpieza de backlinks con parámetros de consulta: mantén los enlaces de autoridad limpios

Aprende a limpiar backlinks con parámetros de consulta para mantener los enlaces de autoridad apuntando a URLs limpias, evitar duplicados y consolidar señales de posicionamiento de forma segura.

Qué sale mal cuando los backlinks incluyen parámetros de consulta

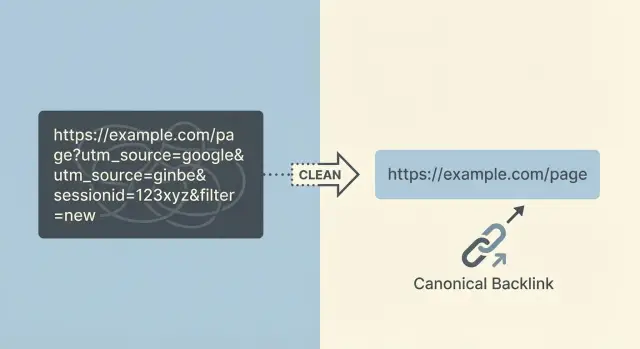

Los parámetros de consulta son los trozos extra pegados al final de una URL después de un signo de interrogación. Se ven como ?utm_source=newsletter o ?sessionid=123. Se usan para rastrear clics, mantener un carrito activo, aplicar filtros o mostrar una vista específica de una página.

El problema es que una página puede tener de repente docenas (o miles) de “URLs diferentes” que cargan básicamente el mismo contenido. Una persona comparte un enlace desde una herramienta de email con etiquetas UTM, otra llega a través de un enlace de afiliado con un ID y alguien más copia una URL después de usar un filtro del sitio. Cada versión es una nueva URL, aunque la página se vea idéntica.

Las consecuencias suelen ser desordenadas:

- La autoridad de los enlaces se divide entre muchas versiones de la URL en vez de fortalecer una página preferida.

- Los motores de búsqueda pueden rastrear e indexar las versiones “incorrectas”, creando duplicados.

- Analíticas y reportes se vuelven confusos porque la misma página aparece bajo múltiples URLs.

- Algunas URLs con parámetros caducan o dejan de funcionar (los session IDs suelen hacerlo), de modo que buenos backlinks pueden terminar en callejones sin salida.

- El valor del enlace se diluye cuando una versión parametrizada redirige de forma inconsistente.

Fuentes comunes incluyen etiquetas de seguimiento (parámetros UTM de herramientas de correo y anuncios), IDs de afiliados, session IDs, filtros facetados (como color=black o sort=price), páginas de resultados internas y botones de “compartir” que añaden parámetros por defecto.

El objetivo es sencillo: cuando exista un backlink fuerte, debe resolverse de forma fiable en una URL canónica preferida. Esa URL preferida debe ser la que realmente quieres que usen las personas y los motores de búsqueda.

Una “URL limpia” es estable (no cambia por visita), compartible (segura para copiar y pegar) e indexable (apropiada para resultados de búsqueda). Cuanto más limpia sea la URL objetivo, más fácil es proteger el valor de los enlaces de autoridad ganados con esfuerzo.

Por qué los backlinks parametrizados pueden perjudicar el posicionamiento y los informes

Cuando un sitio fuerte te enlaza, quieres que todo ese valor llegue a una página limpia y estable. Si el enlace apunta a una URL con parámetros extra, ese valor puede repartirse entre varias versiones de lo que en esencia es la misma página.

Cómo se ven afectadas las posiciones

Los motores de búsqueda tratan URLs distintas como páginas distintas, aunque parezcan idénticas a una persona. Si tienes enlaces que apuntan a:

/product/product?utm_source=newsletter/product?session=12345/product?color=blue&sort=price

esos enlaces pueden terminar divididos en varias versiones de URL. En vez de una página acumulando autoridad fuerte, obtienes varias páginas más débiles que compiten entre sí.

También existe el problema de “misma página, diferente dirección”. Cuando el mismo contenido es accesible por muchas URLs, un motor de búsqueda debe elegir cuál versión mostrar. A veces elige la versión desordenada. A veces cambia entre versiones. En cualquiera de los casos, tu página principal suele ganar tracción más despacio.

Los parámetros también pueden desperdiciar presupuesto de rastreo. Los bots pueden gastar su tiempo rastreando casi-duplicados (versiones filtradas o rastreadas) en lugar de descubrir tus páginas nuevas o más importantes rápidamente.

Cómo se complican los informes

Los backlinks parametrizados pueden volver desordenadas las analíticas y las herramientas SEO. El tráfico y los enlaces se dividen entre múltiples URLs, lo que dificulta responder preguntas básicas como “¿Qué página consiguió este enlace?” o “¿Mejoró realmente nuestra página?”.

Un escenario común: consigues un backlink de autoridad, pero apunta a una URL con etiquetas UTM. En las herramientas ahora tienes dos entradas para la misma página. Una parece fuerte (la URL etiquetada con el backlink) y la otra parece débil (la URL limpia que en realidad quieres posicionar). Eso puede llevar a los equipos a aplicar soluciones equivocadas.

Ayuda separar los parámetros en dos grupos:

- Parámetros solo de seguimiento: usados para atribución o enrutamiento interno, que no deben indexarse.

- Duplicados indexables: filtros, ordenaciones y facetas que crean muchas versiones rastreables que parecen páginas separadas.

Ambos pueden causar problemas, pero los duplicados indexables suelen hacer más daño porque se multiplican rápidamente.

Cómo encontrar las URLs parametrizadas que tienen enlaces entrantes

La base de cualquier limpieza es saber qué backlinks apuntan a URLs parametrizadas. Quieres pruebas, no suposiciones, porque un enlace fuerte apuntando a la URL equivocada puede dividir autoridad entre duplicados.

Extrae candidatos desde varias fuentes, porque cada una tiene sus puntos ciegos:

- Herramientas de backlinks: exporta listas de “URL de destino” e incluye la página que enlaza.

- Google Search Console: revisa las URLs exactas listadas en “Enlaces”.

- Páginas de aterrizaje en analíticas: encuentra URLs con parámetros que aún reciben entradas.

- Logs del servidor: detecta solicitudes reales provenientes de referers (especialmente cuando los bots no aparecen en analíticas).

- Trackers de campañas pagadas: recopila los patrones de parámetros que ves en el mundo real.

Una vez tengas una lista, agrupa las URLs por ruta primero (todo lo que va antes del ?). Trata /pricing como un grupo y luego compara los patrones de parámetros dentro de ese grupo. Esto facilita separar parámetros de seguimiento inofensivos (como utm_*) de duplicados problemáticos (como múltiples combinaciones de sort= y filter=).

Luego prioriza. Ordena por la autoridad de los dominios que enlazan y por el número de páginas enlazantes únicas. Si una colocación de alta autoridad apunta a algo como /guides/seo?utm_source=newsletter&session=9f3K2..., vale la pena corregirlo pronto.

Los parámetros tipo sesión suelen ser fáciles de detectar porque parecen aleatorios o cambian cada visita. Vigila:

- Cadenas largas y mixtas (

a8F9kLm2Pq...) - Parámetros llamados

session,sid,phpsessid,token,gclid - Muchas URLs casi idénticas que solo difieren en un valor

Define el éxito antes de cambiar nada. Un objetivo práctico es “80%+ de los enlaces entrantes conocidos resuelven en la URL canónica”, además de una lista corta de los referidores de mayor autoridad confirmados que aterrizan en la versión limpia.

Decide tus reglas de URL canónica antes de cambiar nada

Antes de iniciar la limpieza, decide cuál es la versión “verdadera” de cada página. Si no, arreglas un conjunto de URLs y creas otro sin querer.

Empieza con reglas globales que todo el equipo pueda seguir:

- Solo HTTPS (sin versiones HTTP)

- Un estilo de barra final (siempre con ella o siempre sin ella)

- Un estilo de hostname (www o sin www)

- Rutas en minúsculas cuando sea posible

- Sin parámetros de seguimiento en enlaces públicos y compartibles

Luego, deja claro cuándo un parámetro crea contenido real vs un duplicado.

Un parámetro es “real” cuando el significado de la página cambia de forma significativa para el usuario y debe ser buscable por sí mismo. Un ejemplo común es una variante de producto con su propio SKU, precio y estado de stock.

Un parámetro es “duplicado” cuando solo cambia cómo se muestran los mismos elementos o sirve para seguimiento. Eso incluye la mayoría de etiquetas de seguimiento, session IDs y opciones de orden. Estos deberían normalmente consolidarse en la URL canónica limpia.

Anota reglas para los parámetros que realmente ves. Para muchos sitios, un buen punto de partida es:

utm_*y otras etiquetas de campaña: no forman parte de la URL canónicagclidyfbclid: no forman parte de la URL canónicasessionosid: nunca canónicas, nunca indexablessortyorder: normalmente no canónicas, típicamente no indexables- parámetros de filtro y faceta: depende (algunos son útiles, muchos crean duplicados)

Luego decide qué debe ser indexable vs no indexable. Las facetas de categoría y las búsquedas internas son donde los sitios accidentalmente crean miles de duplicados delgados. Si una página filtrada tiene valor único que quieres en búsqueda, trátala como una página de aterrizaje real con una URL estable y canonicals consistentes. Si es solo una vista temporal, mantenla fuera del índice y empuja las señales hacia la categoría principal.

Documenta estas decisiones en lenguaje claro. Marketing necesita saber qué etiquetar y cómo compartir enlaces. Dev necesita saber qué redirigir, qué canonicalizar y qué mantener fuera del índice.

Paso a paso: la forma más segura de limpiar backlinks con parámetros

La limpieza de parámetros afecta SEO, analíticas y a veces los flujos de checkout o login. El enfoque más seguro es cambiar lo menos posible a la vez y hacer que cada regla sea fácil de probar.

Un flujo de trabajo de limpieza seguro

Empieza por listar los patrones de parámetros que quieres arreglar y ordénalos por riesgo e impacto. Los UTM y los click IDs suelen ser de bajo riesgo y alto volumen. Los session IDs pueden ser más riesgosos porque a veces afectan cómo cargan las páginas para usuarios logueados.

Una secuencia práctica es:

- Decide la URL objetivo para cada patrón de parámetro (por ejemplo, eliminar

utm_*,gclid,fbclid,sessionid). - Añade redirecciones 301 donde la URL parametrizada sea un duplicado claro de la misma página. Mantén una sola redirección.

- Usa

rel=canonicalen páginas donde las redirecciones no sean prácticas (por ejemplo, cuando los parámetros cambian el contenido pero aún quieres una URL principal indexada). - Corrige la generación de URLs en la fuente (ruteador de la app, plantillas del CMS, búsqueda interna, filtros, caché, generación de sitemaps).

- Prueba URLs reales de extremo a extremo y monitorea resultados por 2–4 semanas mientras los motores de búsqueda vuelven a rastrear y las señales se consolidan.

Las pruebas importan. Elige ejemplos de backlinks reales (un sitio de autoridad, un boletín, una publicación social) y confirma que la URL final sea consistente, cargue rápido y muestre el contenido esperado.

Ejemplo: si un backlink fuerte apunta a /pricing?utm_source=partner&utm_campaign=spring, tu regla debería redirigirlo con 301 a /pricing (sin parámetros). Si la atribución importa, conserva los UTM para seguimiento en tu configuración analítica, pero evita que creen URLs indexables separadas.

Después del lanzamiento, vigila bucles de redirección, 404 inesperados y picos en Search Console como “Páginas duplicadas” o “Página alternativa con canonical correcto”.

Parámetros de seguimiento: conservar la atribución sin crear URLs duplicadas

Las etiquetas UTM y otros parámetros de seguimiento son útiles porque te dicen de dónde viene una visita. El problema empieza cuando esas URLs parametrizadas se vuelven rastreables, indexables y compartibles. Entonces terminas con muchas versiones de la misma página, cada una compitiendo por señales y ensuciando los reportes.

El objetivo es simple: conservar la atribución, pero asegurarte de que la URL que los motores de búsqueda indexan (y que gana valor de enlace a largo plazo) sea la versión limpia y canónica.

Cómo manejar parámetros de seguimiento sin perder datos

Decide cuáles parámetros son solo de seguimiento (por ejemplo: utm_source, utm_medium, utm_campaign, utm_term, utm_content, gclid, fbclid). Esos no deberían crear páginas indexables nuevas.

Cuando puedas, elimina parámetros de seguimiento lo antes posible. Un enfoque común es hacer una redirección 301 desde la URL parametrizada a la misma ruta sin los parámetros de seguimiento.

Para mantener esto seguro y predecible:

- Redirige solo para parámetros de los que estés seguro que son solo de seguimiento.

- Mantén la página de destino exactamente igual, solo sin los parámetros.

- Asegúrate de que la URL limpia sea la que usas en etiquetas canonical y enlaces internos.

- Prueba un puñado de URLs reales de campaña antes de desplegar ampliamente.

Excepciones a planear

A veces un partner o plataforma publicitaria requiere un parámetro para su reporting o proceso de aprobación. En esos casos puedes permitir el parámetro para usuarios pero mantener la URL canónica limpia. La clave es que los motores de búsqueda entiendan la versión preferida y eviten indexar la variante de seguimiento.

También alinea esto con tus equipos de email y anuncios. Mantén reglas de etiquetado cortas (parámetros permitidos, nomenclatura, minúsculas vs mayúsculas) para que futuras campañas no inventen variantes nuevas que vuelvan a generar duplicados.

Filtros y navegación facetada: donde la limpieza se complica

La navegación facetada es donde la limpieza deja de ser un simple “quitar parámetros”. Los filtros pueden crear miles de variaciones de página que son distintas para un usuario pero casi duplicadas para un motor de búsqueda. Ofensores comunes incluyen parámetros como sort=, color=, size=, price=, brand= y inStock=.

Algunas páginas filtradas son realmente útiles. “Zapatillas para correr de hombre” puede ser amplia, pero “zapatillas para correr de hombre talla 12” puede tener demanda real. Si tratas cada URL de filtro como basura, puedes borrar páginas que deberían posicionar.

Una regla práctica es permitir solo un pequeño conjunto de páginas filtradas de alta demanda que sean rastreables y mantener el resto fuera del índice. Eso implica decidir de antemano qué filtros representan una página de aterrizaje real y cuáles son meros controles de UI.

Lo que suele funcionar es una mezcla de:

- Canonicalizar la mayoría de las páginas filtradas a la categoría base cuando el contenido es mayormente el mismo.

- Usar

noindexen páginas filtradas que quieres que los usuarios utilicen pero que no deseas en el índice. - Reducir el desperdicio de rastreo para variaciones de bajo valor obvias (especialmente

sort=y opciones de vista). - Crear una lista corta de “facetas indexables” con URLs estables e intencionales.

Ten cuidado con las redirecciones generales. Redirigir todas las URLs parametrizadas a la categoría base puede romper vistas seleccionadas por usuarios (por ejemplo, un enlace que espera color=black de pronto aterriza en una página sin filtro). También puede complicar informes cuando marketing depende de ciertos parámetros.

Un enfoque más seguro es la limpieza selectiva: normaliza lo que no quieres indexado y preserva lo que intencionalmente quieres posicionar.

Errores comunes que desperdician equidad de enlaces durante la limpieza

El objetivo es mantener la autoridad fluyendo hacia una URL limpia y consistente. La mayoría de los problemas ocurren cuando la solución se apresura y las reglas de destino no están claras.

Redirigir todas las URLs parametrizadas a la página de inicio (o a una categoría “suficientemente cercana”) es un error frecuente. Los motores de búsqueda a menudo tratan eso como un error blando cuando la URL original parecía una página de producto, artículo o ubicación específica. Incluso cuando la redirección funciona, la relevancia puede bajar y el beneficio del enlace se debilita.

Las cadenas de redirección son otra fuga silenciosa. Por ejemplo, un backlink golpea /page?utm_source=x, luego redirige a /page?ref=y, y finalmente a /page. Las cadenas ralentizan el rastreo, aumentan el riesgo de fallos y hacen que la consolidación sea menos fiable. Apunta a un solo salto: la URL con parámetros va directo a la canónica.

También vigila usar 302 (temporal) para una limpieza permanente. Si la URL parametrizada nunca debería indexarse, trátala como permanente. De lo contrario puedes quedarte con ambas versiones en el índice.

Las etiquetas canonical pueden fallar si apuntan a una URL que no responde con 200, o si mezclas HTTP y HTTPS. Un canonical debe apuntar a la versión exacta que quieres indexada, y esa página debe cargarse correctamente.

Un error que sorprende a la gente es bloquear las URLs con parámetros en robots.txt demasiado pronto. Si Google no puede rastrear la URL parametrizada, quizá no vea tu redirección o etiqueta canonical, lo que ralentiza la consolidación. Deja que redirecciones y canonicals hagan el trabajo primero, y luego ajusta las reglas de rastreo si es necesario.

Finalmente, la limpieza falla cuando marketing continúa generando nuevos patrones de parámetros sin normas. Arreglas los enlaces utm_, y la siguiente campaña inventa campaignId, ref o session IDs, y los duplicados vuelven.

Lista rápida de verificación antes y después de desplegar cambios

Trata la limpieza como un pequeño release: define qué es “correcto” y luego verifícalo en navegadores reales, rastreadores y herramientas de búsqueda.

Antes de desplegar

Elige un puñado de URLs parametrizadas reales que ya aparezcan en backlinks (UTM, session IDs, sort, filter). Para cada una, escribe la única URL limpia en la que debería terminar.

- Confirma que cada URL de ejemplo termina en una única URL limpia (no múltiples resultados).

- Revisa cadenas y bucles de redirección (un salto es ideal).

- Asegúrate de que la etiqueta canonical en la página final coincide exactamente con la URL final.

- Verifica que las páginas importantes sean accesibles sin parámetros y carguen rápido.

- Decide cómo manejarás los parámetros “permitidos” (por ejemplo: conservar UTM para analíticas pero no permitir que creen páginas indexables).

Después de desplegar

Comienza con una comprobación puntual y luego observa la tendencia durante unas semanas. Las redirecciones y los canonicals pueden parecer bien aisladamente pero comportarse distinto a escala.

- Vuelve a probar el mismo conjunto de ejemplos y confirma que se resuelven igual en un navegador y en un rastreador.

- Comprueba que tus páginas más enlazadas no hayan perdido enlaces internos o rutas de navegación.

- Observa Search Console para una caída gradual en entradas duplicadas o alternativas ligadas a parámetros.

- Confirma que los reportes siguen atribuyendo campañas correctamente, sin que aparezcan nuevas páginas parametrizadas como páginas de aterrizaje.

Ejemplo: arreglando backlinks de autoridad que apuntan a URLs con UTM y session

Un sitio de autoridad enlaza a tu página de precios, pero la URL que usaron está desordenada: /pricing?utm_source=techblog&utm_medium=referral.

Un segundo sitio enlaza a una versión con session como /pricing?sessionid=9f3a.... Ambos enlaces son valiosos, pero las URLs de destino no lo son.

Antes de la limpieza, usuarios y rastreadores pueden ver múltiples versiones de la misma página. Las analíticas pueden mostrar varias páginas “pricing”. Los motores de búsqueda pueden indexar más de una URL. La equidad de enlaces se divide entre duplicados.

Aplica una regla clara: la URL canónica es /pricing, y los parámetros de seguimiento y sesión no deben crear una nueva versión.

Para los session IDs, la solución suele ser eliminarlos por completo. Si tu sitio todavía genera sessionid en las URLs, es un problema mayor a resolver, pero puedes proteger el SEO redirigiendo cualquier URL que contenga sessionid hacia /pricing.

Para los UTM, puedes conservar la atribución sin mantener la URL desordenada indexada. Un enfoque común es: cuando llega una petición con parámetros utm_, tu servidor lee y almacena los valores de campaña (por ejemplo, en cookies de primer partido o en logs del servidor) y luego emite una redirección 301 a /pricing.

Con el tiempo verás consolidación:

- Menos URLs con parámetros en el índice

- Rankings e impresiones concentrándose en la página principal

/pricing - Las herramientas de backlinks atribuyendo más valor a la URL canónica

Si estás construyendo enlaces de autoridad activamente, esta limpieza merece la pena hacerlo pronto. Cuando colocas o pides enlaces a través de un proveedor como SEOBoosty (seoboosty.com), envía la URL canónica limpia desde el inicio para que las menciones más fuertes refuercen la página que realmente quieres posicionar.

FAQ

¿Qué se considera un parámetro de consulta en la URL de un backlink?

Los parámetros de consulta son todo lo que viene después del ? en una URL, como ?utm_source=newsletter o ?sessionid=123. A menudo cambian el seguimiento o la forma en que se muestra una página, pero también pueden crear muchas URL “diferentes” que cargan el mismo contenido.

¿Por qué los backlinks con parámetros pueden perjudicar el posicionamiento?

Porque los motores de búsqueda tratan distintas URLs como páginas distintas, incluso si parecen idénticas. Si los backlinks apuntan a muchas versiones con parámetros, la autoridad puede dividirse entre duplicados y la versión que quieres posicionar puede fortalecerse más lentamente.

¿Cómo encuentro qué URLs parametrizadas están recibiendo backlinks?

Empieza exportando las “URL de destino” exactas desde tu herramienta de backlinks y Google Search Console, y busca ? en las URLs. Agrúpalas por la ruta base (todo antes del ?) para ver qué parámetros son solo de seguimiento y cuáles generan muchas variaciones casi duplicadas.

¿Debería redirigir los backlinks con UTM a la URL limpia?

Por lo general sí, para parámetros que son solo de seguimiento, siempre que el contenido sea el mismo y no rompas funcionalidad necesaria. Lo más limpio es hacer que esas solicitudes resuelvan siempre en la URL canónica, de modo que el valor a largo plazo de los enlaces se consolide en una página preferida.

¿Los IDs de clic de anuncios como gclid o fbclid requieren un manejo especial?

Trata los identificadores de clics como gclid y fbclid como parámetros de seguimiento en la mayoría de los casos; no deberían convertirse en variantes indexables. Si los eliminas, asegúrate de que tu sistema de medición capture la información de la campaña antes de normalizar la URL.

¿Por qué los parámetros de ID de sesión son especialmente peligrosos para los backlinks?

Los session ID en las URLs son peligrosos porque pueden expirar o variar por visitante, lo que convierte buenos backlinks en destinos inestables o rotos. La solución práctica es evitar generar session IDs en las URLs si es posible, y normalizar cualquier URL entrante con parámetros de sesión para que apunte a una página canónica estable.

¿Debería eliminar o mantener los parámetros de filtro y orden en las páginas de categoría?

No siempre, porque algunas páginas filtradas sí pueden ser páginas de aterrizaje legítimas si son estables y realmente únicas. Un valor seguro por defecto es evitar que la mayoría de variantes de filtro y orden compitan con tu página de categoría principal, y solo permitir que un pequeño conjunto de páginas de filtro intencionales y estables sean indexables.

¿Cuándo debería usar redirecciones 301 vs etiquetas canonical vs noindex para URLs con parámetros?

Usa una redirección 301 cuando la versión con parámetros es un duplicado claro y quieres una URL definitiva. Usa una etiqueta rel=canonical cuando necesites el parámetro para los usuarios pero aún quieras que los motores de búsqueda consideren otra URL como primaria. Considera noindex para páginas que los usuarios deben usar pero que no quieres en resultados de búsqueda.

¿Debería bloquear las URLs con parámetros en robots.txt para detener duplicados?

Bloquear demasiado pronto puede ralentizar la consolidación porque los motores de búsqueda podrían no poder rastrear la URL con parámetros y, por lo tanto, no ver tu redirección o etiqueta canonical. Suele ser mejor dejar que redirecciones y canonicals hagan su trabajo primero y luego restringir el rastreo si todavía necesitas reducir el desperdicio de rastreo.

¿Qué URL debo dar a partners o a SEOBoosty al construir backlinks?

Proporciona la URL canónica limpia exacta que quieres posicionar, sin parámetros de seguimiento ni de sesión, y especifica tu formato preferido de HTTPS y hostname. Si colocas enlaces de autoridad a través de un proveedor como SEOBoosty, enviar la URL limpia desde el principio ayuda a asegurar que las menciones más fuertes refuercen la página correcta en lugar de una variante desordenada.