Backlinks vers des pages géo‑échangées : faire en sorte que Googlebot voie une seule page

Apprenez à valider les backlinks vers des pages géo‑échangées afin que Googlebot voie un contenu stable, que vos signaux canoniques restent clairs et que l'équité des liens ne soit pas diluée.

Le problème : une URL, des contenus différents

Une page personnalisée change selon la personne qui la visite. Parfois c'est mineur (un titre différent pour les visiteurs récurrents). D'autres fois c'est majeur (une offre différente, des prix ou des informations de localisation).

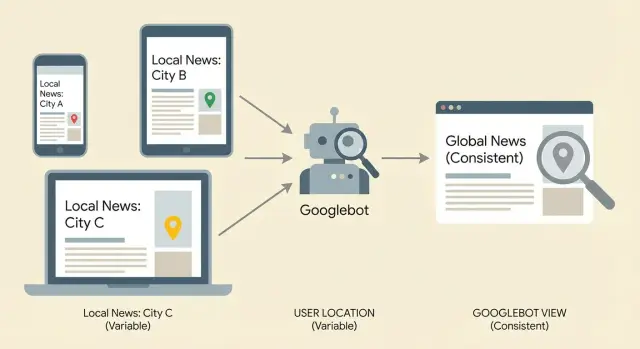

Le geo‑swapping est une forme courante de personnalisation. L'URL reste la même, mais le contenu change selon la localisation du visiteur, généralement devinée à partir de l'IP, de la localisation de l'appareil ou des réglages du navigateur.

Imaginez une page de service : example.com/plumbing. Quelqu'un à Austin voit « Plumber in Austin », un numéro local d'Austin et des avis d'Austin. Quelqu'un à Miami visite la même URL et voit « Plumber in Miami », un autre numéro et d'autres témoignages.

C'est utile pour les utilisateurs, mais risqué pour le SEO. Google doit décider de ce que représente réellement cette URL, quelle version indexer et quel texte utiliser pour comprendre la page. Si la page change beaucoup, Google peut la considérer comme instable ou peu claire.

Les backlinks deviennent compliqués dans ce contexte. Les liens pointent vers une seule URL, mais Googlebot peut crawler une version différente de celle que voient la plupart des utilisateurs, ou voir des versions différentes selon les visites. Quand la page n'est pas cohérente, les signaux de ces liens peuvent se diluer parce que Google n'est pas toujours sûr qu'il évalue la même page.

L'objectif est simple : une version indexable de la page qui reste constante pour les crawlers et qui correspond à ce que vos backlinks sont censés soutenir. Vous pouvez toujours personnaliser pour les utilisateurs, mais la « page centrale » que Google indexe doit avoir le même aspect à chaque visite de Googlebot.

Comment des pages incohérentes gaspillent la valeur des backlinks

Les backlinks transmettent de la valeur (souvent appelée équité des liens) via une URL. Pour que cette valeur se concentre, Google doit voir l'URL comme une page claire avec un but principal.

Si la même URL montre un contenu différent selon la localisation, l'appareil, les cookies ou l'heure, Google peut avoir du mal à comprendre de quoi parle la page. Vos meilleurs liens peuvent pointer vers une page qui paraît instable : titres différents, texte du corps différent, liens internes différents, ou même une offre différente selon le moment et l'endroit où Googlebot crawl.

Cette instabilité peut aussi créer une confusion canonique. Vous pouvez définir la canonique vers /services, mais parce que le contenu se met à changer, Google peut décider qu'une URL plus stable (par exemple /services/nyc) est la meilleure représentante. Alors vos backlinks finissent par soutenir une URL que vous ne vouliez pas classer.

Signes que la valeur des liens est diluée au lieu d'aider :

- Les classements stagnent malgré des backlinks solides

- Le titre/snippet indexé change souvent pour la même URL

- Google crawl fréquemment mais la page ne prend pas d'élan

- Certaines localisations se classent tandis que d'autres ne bougent pas

Exemple : vous obtenez des liens vers une page « Plumbing Services », mais les utilisateurs à Chicago voient « Chicago Plumbing » tandis que ceux à Dallas voient « Dallas Plumbing », avec des FAQ et H1 différents. Google peut ne pas consolider tous ces signaux en une page forte.

Ce que Googlebot est susceptible de voir (et pourquoi ça varie)

Quand Googlebot visite une URL, il fait généralement plus que télécharger le HTML. Il peut rendre la page comme un navigateur (donc les changements JavaScript sont inclus), la comparer aux crawls précédents et décider quelle version indexer.

Googlebot ne crawl pas non plus depuis un emplacement fixe. Google utilise de nombreuses plages d'IP et centres de données. Si votre serveur change le contenu selon l'IP, les cookies, les en‑têtes ou le timing, Googlebot peut recevoir des pages différentes pour la même URL.

Les crawls répétés montrent où est le problème. Un crawl peut toucher un cache chaud et obtenir votre version par défaut. Un autre crawl quelques jours plus tard peut toucher un autre nœud edge ou une règle géo et obtenir une version échangée. Avec le temps, Google voit les incohérences et peut indexer la « mauvaise » version ou considérer la page comme instable.

Raisons courantes pour lesquelles la même URL peut paraître différente à Googlebot :

- Geo‑swapping basé sur l'IP (le serveur change le texte)

- Personnalisation via cookies ou connexion (Googlebot obtient une version « invité » différente)

- Modifications JavaScript après le chargement (le rendu diffère du HTML brut)

- Tests A/B (le contenu varie selon la requête)

- Variance CDN/cache (règles edge différentes, sorties différentes)

Si vous construisez des backlinks vers des pages géo‑échangées, l'approche la plus sûre est de rendre la version crawler ennuyeuse et cohérente, même si les utilisateurs voient des ajustements légers.

Étape par étape : confirmer que la page est stable pour les crawlers

Commencez par choisir une URL que vous voulez que chaque backlink renforce. Si vous avez plusieurs versions (pages villes, paramètres, chemins alternatifs), choisissez celle que vous voulez vraiment voir classer et traitez tout le reste comme support.

Ensuite, vérifiez ce qu'un visiteur « neutre » voit. Utilisez une fenêtre privée, restez déconnecté et refusez les permissions de localisation. Si votre site change la langue ou la devise selon les réglages du navigateur, définissez‑les sur une valeur par défaut simple et rechargez.

Puis, comparez cela avec ce qu'un crawler est susceptible d'obtenir. Utilisez un crawler qui s'identifie comme Googlebot, ou utilisez la fonctionnalité d'inspection d'URL de votre plateforme SEO (par exemple, l'inspection d'URL de Search Console) pour voir le HTML rendu et les ressources.

Une routine qui attrape la plupart des geo‑swaps :

- Chargez l'URL en session neutre et enregistrez le texte visible.

- Chargez‑la à nouveau depuis au moins deux régions différentes (VPN ou navigateur distant).

- Récupérez l'URL en tant que bot et capturez le rendu final.

- Comparez le title, le H1, le corps principal et les liens internes principaux.

Concentrez‑vous sur les changements qui modifient ce dont parle la page. Si le nom de la ville, la portée du service, les prix ou la disponibilité des produits changent, Google peut traiter l'URL comme incohérente. De petits changements d'interface (comme un numéro local dans un en‑tête) sont généralement moins risqués.

Signaux à vérifier : redirections, codes de statut, canonicals

Le geo‑swapping casse souvent l'équité des liens parce que la même URL se comporte différemment selon le visiteur. Cela peut répartir les signaux sur plusieurs URLs ou envoyer des instructions mélangées aux crawlers.

Commencez par les redirections. Une redirection qui change selon le pays, l'état ou la langue est un signal d'alerte, sauf si vous êtes très intentionnel. Testez la même URL depuis différents emplacements ou réglages de langue et notez où elle atterrit.

Puis confirmez que le code de statut est stable. Une page qui renvoie 200 parfois mais 302 (ou pire, 404) d'autres fois peut perdre de la valeur car les crawlers la considèrent comme peu fiable.

Sur la page finale que Google devrait indexer, vérifiez :

- La réponse est constamment 200.

- Toute redirection est cohérente et aboutit à une URL prévue.

- La balise canonique pointe toujours vers cette même URL prévue.

- Les cibles de redirection et les canonicals sont d'accord (pas de « canonique vers A » mais « redirige vers B »).

- Les paramètres (comme

?city=,?lang=, balises de tracking) ne créent pas de multiples versions indexables.

Les canonicals sont particulièrement importants sur les pages personnalisées. Si la canonique change selon la localisation, le device ou les cookies, vous dites à Google que différentes versions sont « la vraie » à différents moments.

Personnaliser sans transformer la page

Si la même URL affiche un HTML significativement différent à Googlebot qu'aux vrais utilisateurs, vous risquez plus qu'une simple « confusion de signaux ». Cela peut ressembler à du cloaking, et Google peut aussi considérer ce qui devrait être une page comme plusieurs versions.

Un objectif plus sûr : garder le message central identique pour tous et personnaliser autour des bords. Pensez « indices utiles », pas « une page différente ». Par exemple, vous pouvez détecter la ville du visiteur et afficher « Serving Austin today » dans une petite bannière, tandis que le H1, les paragraphes clés, les prix et les liens internes restent identiques.

Un schéma pratique consiste à garder le contenu critique dans le HTML initial, puis à ajouter de petits indicateurs de localisation après le chargement. Ainsi Googlebot reçoit toujours une page stable et indexable, et les utilisateurs ont malgré tout une expérience personnalisée.

Checklist de personnalisation sûre

Garder la personnalisation non critique :

- Conserver le titre principal, l'offre primaire et le corps principal cohérents.

- Garder les liens internes et la navigation cohérents entre les localisations.

- Personnaliser de petites sections (bannière, barre latérale, ordre des témoignages), pas le pitch principal.

- Éviter de swapper des blocs entiers de contenu axé sur des mots‑clés par IP.

- S'assurer que le texte important n'est pas uniquement dans des scripts susceptibles d'échouer au rendu.

Le JavaScript n'est pas automatiquement « mauvais », mais c'est un point de défaillance fréquent. Si votre copie principale ou vos appels à l'action n'apparaissent qu'après l'exécution d'un script, un délai de rendu ou une ressource bloquée peut laisser Googlebot avec une version faible de la page.

Schémas de ciblage géographique qui fonctionnent généralement mieux

Lorsque le contenu change vraiment selon la région, des URLs séparées sont généralement plus sûres que de swapper le contenu à l'intérieur d'une même URL. Googlebot peut crawler un document cohérent, et vos liens pointent vers quelque chose qui ne « change pas de forme ».

Les pages régionales séparées valent le coup quand vous avez de réelles différences : prix, conditions légales, règles d'expédition, emplacements de magasins ou langue. Si ce n'est qu'un petit message de bienvenue, conservez une page unique et évitez la logique géo.

Un schéma qui fonctionne bien :

- Une version principale accessible à tous et que Google peut crawler de façon fiable

- Des URLs dédiées pour les grandes régions ou langues (par exemple

/en/et/fr/) - Une option visible pour que les utilisateurs changent de région eux‑mêmes

- Une détection optionnelle qui suggère une meilleure version sans l'imposer

Où hreflang intervient

Les annotations hreflang indiquent aux moteurs quelle page est destinée à quelle langue ou région, ce qui les aide à afficher la bonne version dans les résultats. Utilisez‑les lorsque vous avez plusieurs versions très similaires mais destinées à des audiences différentes (comme English US vs English UK, ou English vs Spanish). Ce n'est pas un gain de classement en soi, mais cela réduit le risque que la mauvaise version apparaisse dans les résultats.

Une erreur courante est de forcer les visiteurs vers une URL différente selon l'IP. Cela peut bloquer Googlebot, embrouiller les utilisateurs en VPN et diluer les signaux si certains liens mènent vers une URL qui renvoie immédiatement ailleurs.

Pièges courants qui cassent silencieusement l'équité des liens

La plupart des problèmes avec les pages géo‑échangées ne sont pas des erreurs évidentes. La page se charge bien dans votre navigateur, mais Googlebot peut voir autre chose, ou il peut voir plusieurs versions entre les crawls.

La logique edge est un coupable fréquent. Un CDN ou un proxy peut réécrire le contenu selon l'IP, les en‑têtes ou les règles de device. Si l'edge swappe le H1, les liens internes ou le texte du corps tout en gardant la même URL, Google peut le traiter comme une page différente à chaque visite.

Autres pièges qui causent des dégâts silencieux :

- Tests A/B qui incluent les bots, si bien que Googlebot voit des titres ou H1 rotatifs

- Boucles (ou chaînes) de géo‑redirections où les crawlers n'atteignent pas une page finale cohérente

- Balises canonique multiples provenant de templates ou plugins conflictuels

- Chaînes de requête de localisation comme

?city=qui se font indexer et créent des quasi‑doublons

Si vous investissez dans la création de liens, ces problèmes peuvent transformer des liens solides en signaux affaiblis. Réparez d'abord la livraison, puis scalez.

Vérifications rapides avant de créer plus de backlinks

Avant de pointer de nouveaux backlinks vers une URL géo‑échangée, assurez‑vous que Googlebot voit une version stable de la page. Si vous ne pouvez pas répéter le même résultat deux fois, vous jouez avec l'équité des liens.

Vérifiez la page depuis quelques localisations (et avec les paramètres de localisation activés et désactivés) et confirmez que les éléments suivants restent essentiellement cohérents :

- Balise title et meta description (des ajustements mineurs sont acceptables, pas un nouveau sujet)

- Un H1 clair qui correspond au but de la page

- Contenu principal (ne pas échanger tout le pitch ou la liste de services)

- Liens internes dans le contenu principal (mêmes destinations, même structure globale)

- Éléments structurés clés comme les FAQ ou blocs produit/service

Ensuite, faites une passe technique rapide :

- La page finale renvoie un statut 200 (pas de chaîne de redirections)

- Pas de redirection automatique par IP qui envoie les crawlers vers une URL différente ville/pays

- Vous inspectez la page rendue, pas seulement le HTML brut

- Vous pouvez reproduire la même sortie rendue lors de visites répétées

Tenez un journal simple : horodatage, localisation/méthode de test, URL finale, code de statut, canonique et ce qui a changé (le cas échéant). Ça facilite la re‑vérification après des mises à jour.

Exemple : une page locale de service avec swap par ville

Une configuration fréquente : une URL comme /services/plumbing, avec détection géo qui swappe le nom de la ville, le numéro de téléphone et les témoignages. Les visiteurs d'Austin voient « Austin emergency plumber » avec des avis d'Austin. Ceux de Dallas voient « Dallas emergency plumber » avec des avis de Dallas.

Ajoutez maintenant des backlinks. Un site partenaire lie cette URL unique. Mais le lien « cautionne » en fait ce que Googlebot voit lors du crawl. Si Googlebot obtient parfois Austin et parfois Dallas (ou une version générique), la cible n'est pas stable.

La solution consiste à décider ce qui doit rester identique et ce qui peut changer en toute sécurité. Dans la plupart des cas, conservez le cœur stable : description du service, approche tarifaire, signaux de confiance et titre principal ne devraient pas basculer entre villes. Personnalisez de petits éléments UI qui n'altèrent pas le sens.

Une remédiation pratique : une page cœur stable plus un module de localisation optionnel :

- Garder une page de service canonique avec la même copie principale pour tous

- Ajouter une petite bannière de localisation basée sur le choix utilisateur

- Charger des témoignages locaux dans un module clairement séparé (et limiter la quantité de texte ajoutée)

- Si vous avez besoin de vraies pages par ville, créez des URLs séparées par ville et ciblez celles‑ci

Le succès ressemble à ceci : les crawls montrent le même HTML principal à chaque fois, la canonique est cohérente et l'extrait indexé cesse de sauter entre les villes.

Étapes suivantes : verrouillez la page, puis augmentez les liens

Une fois que vous avez confirmé ce que Googlebot voit, traitez cette version comme la page officielle et protégez‑la. Le geo‑swapping peut revenir après un déploiement, un changement de règle CDN ou un test A/B qui semblait anodin.

Vérifiez immédiatement après les releases, puis de nouveau 24 à 48 heures plus tard quand les caches sont chauffés. Comparez le code de statut, l'URL finale, la canonique et le contenu principal rendu avec votre dernier baseline.

Ne montez en charge la création de liens que lorsque la destination est stable. Sinon, les backlinks vers des pages géo‑échangées peuvent atterrir sur plusieurs variantes, répartissant l'équité sur des versions que vous n'avez pas prévues.

Si vous utilisez une source de liens gérée, la stabilité compte encore plus car vous concentrez délibérément l'autorité dans une URL précise. Par exemple, SEOBoosty (seoboosty.com) se concentre sur l'obtention de placements de backlinks sur des sites faisant autorité, il est donc utile de valider la page cible d'abord pour s'assurer que ces signaux se consolident au lieu de se scinder entre des variantes échangées.

Réparez d'abord la livraison de la page, puis gagnez et suivez les backlinks.

FAQ

Pourquoi les backlinks sont-ils risqués lorsque la même URL affiche un contenu différent selon la localisation ?

Choisissez une URL que vous voulez réellement voir classer et assurez-vous que cette URL livre la même page de base à Googlebot à chaque visite. Vous pouvez toujours adapter de petits éléments d'interface pour les utilisateurs, mais la version indexée doit rester stable entre les crawl afin que les signaux des backlinks se consolident au lieu de se diviser.

Que signifie que l'équité des liens soit « diluée » sur une page géo‑échangée ?

Les backlinks renforcent une URL en tant qu'entité unique, et Google a besoin de comprendre cette URL comme une page claire avec un thème principal. Si le titre, le H1, le corps ou les liens internes changent beaucoup entre les visites, Google peut considérer la page comme instable et la valeur des liens peut se diluer.

Comment savoir rapidement si Googlebot voit une version différente de celle des utilisateurs ?

Testez la page à plusieurs reprises dans des conditions neutres puis comparez les sorties. Chargez la page déconnecté, en fenêtre privée, puis depuis au moins deux régions différentes, et enfin récupérez la version rendue en tant que bot ; si le texte principal et l'intention changent, la page n'est pas stable pour les crawlers.

Quels éléments de page importent le plus pour la stabilité SEO des pages personnalisées ?

Concentrez‑vous sur les éléments qui changent le sens : balise title, H1, copie principale, liens internes principaux et blocs clés comme les FAQ ou les listes de services. De petits changements comme un numéro local dans l'en‑tête sont généralement moins risqués que de remplacer le nom de la ville dans le H1 et de réécrire complètement l'argumentaire.

Pourquoi Googlebot peut‑il voir un contenu différent lors de différents crawls ?

Googlebot peut voir des versions différentes car il ne crawl pas depuis un seul emplacement fixe et il peut rendre le JavaScript. Si votre serveur, CDN, cache, tests A/B ou scripts varient la sortie selon l'IP, les cookies, les en‑têtes ou le timing, Googlebot peut recevoir des pages différentes pour la même URL.

Quelles erreurs de redirection et de canonical cassent souvent la valeur des backlinks sur des URLs géo‑échangées ?

Vérifiez que la page finale renvoie systématiquement un statut 200 et résout vers une URL voulue sans changements basés sur la localisation. Assurez‑vous ensuite que la balise canonique pointe toujours vers cette même URL ; si les redirections ou les canonicals varient selon la localisation ou les cookies, vous envoyez des signaux contradictoires qui peuvent diviser le crédit de classement.

Comment personnaliser une page sans en faire une page différente pour le SEO ?

Conservez le message central identique pour tout le monde et personnalisez uniquement les éléments périphériques. Une approche pratique est de maintenir le contenu critique dans le HTML initial et d'ajouter de petits indices de localisation après le chargement, ainsi les crawlers reçoivent toujours une page stable pendant que les utilisateurs ont une expérience personnalisée.

Quand devrais‑je utiliser des URLs régionales séparées plutôt qu'une URL géo‑échangée ?

Si le contenu change réellement selon la région, il est généralement plus sûr de créer des URLs séparées. Créez des pages régionales ou linguistiques dédiées, laissez l'utilisateur choisir sa version et envisagez hreflang lorsque vous avez des pages très similaires destinées à des audiences différentes.

Qu'est‑ce que hreflang, et quand aide‑t‑il pour les pages ciblées géographiquement ?

Hreflang informe les moteurs de recherche de la version destinée à chaque langue ou région, ce qui aide à afficher la bonne version dans les résultats. Utilisez‑le lorsque vous avez plusieurs versions très similaires destinées à des publics différents (par exemple English US vs English UK). Ce n'est pas un boost de classement en soi, mais cela réduit le risque que la mauvaise version apparaisse.

Que dois‑je vérifier avant de créer plus de backlinks vers une page géo‑échangée ?

N'ajoutez pas plus de liens tant que la destination n'est pas répétitivement stable. Re‑vérifiez depuis plusieurs emplacements, confirmez l'URL finale, le statut, la canonical et le contenu rendu principal correspondent à votre référence, puis passez à l'échelle ; sinon même des liens premium peuvent finir par soutenir des variantes changeantes au lieu d'une page forte unique.