Nettoyage des backlinks avec paramètres de requête : garder les liens d'autorité propres

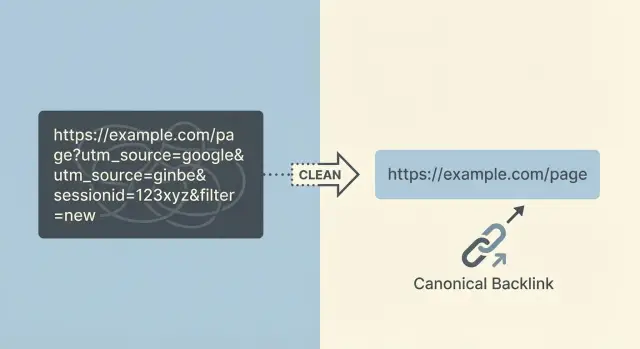

Apprenez à nettoyer les backlinks contenant des paramètres de requête pour que les liens d'autorité pointent vers des URLs propres, éviter les doublons et consolider les signaux de classement en toute sécurité.

Ce qui tourne mal quand les backlinks contiennent des paramètres de requête

Les paramètres de requête sont les bouts supplémentaires ajoutés à la fin d'une URL après un point d'interrogation. Ils ressemblent à ?utm_source=newsletter ou ?sessionid=123. Ils servent à suivre des clics, garder un panier actif, appliquer des filtres ou afficher une vue spécifique d'une page.

Le problème, c'est qu'une page peut soudainement avoir des dizaines (ou des milliers) d'URL « différentes » qui affichent essentiellement le même contenu. Une personne partage un lien depuis un outil d'emailing avec des UTM, une autre arrive via un lien d'affiliation avec un identifiant, et quelqu'un copie une URL après avoir utilisé un filtre du site. Chaque version est une nouvelle URL, même si la page est identique.

Les conséquences désordonnées suivent rapidement :

- L'autorité des liens est répartie entre de nombreuses versions d'URL au lieu de renforcer une page préférée.

- Les moteurs de recherche peuvent explorer et indexer les mauvaises versions, créant des doublons.

- L'analytics et les rapports deviennent confus parce que la même page apparaît sous plusieurs URL.

- Certaines URL paramétrées expirent ou cassent (les session IDs le font souvent), donc de bons backlinks peuvent finir sur des impasses.

- La valeur des liens se dilue quand une version paramétrée redirige de façon incohérente.

Les sources courantes incluent les balises de suivi (paramètres UTM depuis les outils d'email et la publicité), les identifiants d'affiliation, les session IDs, les filtres à facettes (comme color=black ou sort=price), les pages de résultats de recherche internes et les boutons de partage qui ajoutent par défaut des paramètres supplémentaires.

L'objectif est simple : quand un backlink fort existe, il doit résoudre de manière fiable vers une URL canonique préférée. Cette URL préférée doit être celle sur laquelle vous voulez réellement que les gens et les moteurs aboutissent.

Une "URL propre" est stable (ne change pas à chaque visite), partageable (sûre à copier-coller) et indexable (appropriée pour les résultats de recherche). Plus votre URL cible est propre, plus il est facile de protéger la valeur des liens d'autorité durement gagnés.

Pourquoi les backlinks paramétrés peuvent nuire au classement et aux rapports

Quand un site fort vous lie, vous voulez que toute cette valeur arrive sur une seule page propre et stable. Si le lien pointe vers une URL avec des paramètres, cette valeur peut être répartie sur plusieurs versions de ce qui est essentiellement la même page.

Comment le classement en pâtit

Les moteurs de recherche traitent les URL différentes comme des pages différentes, même si elles ont le même rendu pour un humain. Si vous avez des liens pointant vers :

/product/product?utm_source=newsletter/product?session=12345/product?color=blue\u0026sort=price

ces liens peuvent se retrouver éclatés entre plusieurs versions d'URL. Au lieu qu'une seule page accumule une forte autorité, vous obtenez plusieurs pages plus faibles qui se concurrencent.

Il y a aussi un problème de « même page, adresse différente ». Quand le même contenu est accessible via de nombreuses URL, un moteur doit choisir quelle version afficher. Parfois il choisit la version désordonnée. Parfois il change entre les versions. Dans tous les cas, votre page principale a tendance à gagner en visibilité plus lentement.

Les paramètres peuvent aussi gaspiller le temps de crawl. Les bots peuvent brûler leur budget à explorer des quasi-duplicates (versions filtrées ou suivies) au lieu de découvrir rapidement vos pages les plus récentes ou importantes.

Comment les rapports deviennent confus

Les backlinks paramétrés peuvent rendre l'analyse et les outils SEO brouillons. Le trafic et les backlinks sont divisés entre plusieurs URL, ce qui rend plus difficile de répondre à des questions basiques comme « Quelle page a gagné ce lien ? » ou « Notre page s'est-elle vraiment améliorée ? »

Un scénario courant : vous obtenez un backlink d'autorité, mais il pointe vers une URL taguée UTM. Dans les outils, vous avez maintenant deux entrées pour la même page. L'une paraît forte (l'URL taguée avec le backlink) et l'autre paraît faible (l'URL propre que vous voulez réellement classer). Cela peut pousser les équipes vers de mauvaises décisions.

Il aide de séparer les paramètres en deux catégories :

- Paramètres uniquement pour le suivi : utilisés pour l'attribution ou le routage interne, et non destinés à être indexés.

- Doublons indexables : filtres, tris et facettes qui créent de nombreuses versions crawlables ressemblant à des pages distinctes.

Les deux peuvent causer des problèmes, mais les doublons indexables causent généralement plus de dégâts parce qu'ils se multiplient rapidement.

Comment trouver les URL paramétrées qui reçoivent des liens entrants

La base de tout nettoyage est de savoir quels backlinks atteignent des URL paramétrées. Vous voulez des preuves, pas des suppositions, parce qu'un lien fort pointant vers la mauvaise URL peut diviser l'autorité entre des doublons.

Récupérez des candidats depuis plusieurs sources, car chacune a des angles morts :

- Outils de backlinks : exportez les listes d'« URL cibles » en incluant la page source.

- Google Search Console : vérifiez les URL exactes listées dans « Liens ».

- Pages d'atterrissage dans l'analytics : trouvez les URLs de landing qui incluent des paramètres et qui reçoivent des entrées.

- Logs serveur : repérez les requêtes réelles provenant de référents (surtout quand certains bots n'apparaissent pas dans l'analytics).

- Traceurs de campagnes payantes : collectez les motifs de paramètres que vous voyez réellement en production.

Une fois la liste établie, regroupez les URLs par chemin d'abord (tout avant le ?). Traitez /pricing comme un groupe, puis comparez les motifs de paramètres à l'intérieur de ce groupe. Cela facilite la séparation des paramètres de suivi inoffensifs (comme utm_*) des doublons problématiques (comme de multiples combinaisons sort= et filter=).

Puis priorisez. Triez par la force des domaines référents et par le nombre de pages de lien uniques. Si un emplacement à forte autorité pointe vers quelque chose comme /guides/seo?utm_source=newsletter\u0026session=9f3K2..., cela mérite d'être corrigé rapidement.

Les paramètres de type session sont généralement faciles à repérer parce qu'ils ressemblent à des chaînes aléatoires ou changent à chaque visite. Surveillez :

- Longues chaînes mixtes (

a8F9kLm2Pq...) - Paramètres nommés

session,sid,phpsessid,token,gclid - De nombreuses URL presque identiques qui ne diffèrent que par une valeur

Définissez le succès avant de tout changer. Un objectif pratique est « 80 %+ des liens entrants connus aboutissent à l'URL canonique », plus une courte liste des référents à haute autorité confirmés comme atterrissant sur la version propre.

Décidez des règles d'URL canoniques avant de modifier quoi que ce soit

Avant de commencer le nettoyage, décidez quelle est la version « une et unique » de chaque page. Sinon vous réparerez un ensemble d'URL et vous en créerez accidentellement un autre.

Commencez par les règles globales que toute votre équipe peut suivre :

- HTTPS uniquement (pas de versions HTTP)

- Style d'oblique final unique (toujours avec ou sans slash)

- Style d'hôte unique (www ou non-www)

- Chemins en minuscules quand c'est possible

- Pas de paramètres de suivi dans les liens publics partageables

Ensuite, soyez clair sur le moment où un paramètre crée un contenu réel vs un doublon.

Un paramètre est « réel » quand le sens de la page change de façon significative pour l'utilisateur et qu'il doit être indexable. Un exemple courant est une variante de produit avec son propre SKU, prix et statut de stock.

Un paramètre est un « doublon » quand il change seulement la manière d'afficher les mêmes éléments ou le suivi. Cela inclut la plupart des balises de suivi, des session IDs et des options de tri. Ceux-ci doivent généralement être intégrés dans l'URL canonique propre.

Notez par écrit les règles pour les paramètres que vous voyez réellement. Pour de nombreux sites, un point de départ ressemble à ceci :

utm_*et autres tags de campagne : ne font pas partie de l'URL canoniquegclidetfbclid: ne font pas partie de l'URL canoniquesessionousid: jamais canoniques, jamais indexablessortetorder: généralement pas canoniques, typiquement pas indexables- paramètres de filtre et facette : dépend (certains sont utiles, beaucoup créent des doublons)

Décidez ensuite de ce qui doit être indexable vs non-indexable. Les facettes de catégorie et les pages de recherche interne sont là où les sites créent accidentellement des milliers de doublons peu qualitatifs. Si une page filtrée a une valeur unique et que vous voulez qu'elle apparaisse dans la recherche, traitez-la comme une vraie page d'atterrissage avec une URL stable et des canonicals cohérents. Si ce n'est qu'une vue temporaire, gardez-la hors index et renvoyez les signaux vers la catégorie principale.

Documentez ces décisions en langage clair. Le marketing doit savoir quoi taguer et comment partager les liens. Le dev doit savoir quoi rediriger, quoi canonicaliser et quoi garder hors index.

Étape par étape : la manière la plus sûre de nettoyer les backlinks paramétrés

Le nettoyage des paramètres touche au SEO, à l'analytics et parfois aux parcours de commande ou de connexion. L'approche la plus sûre est de changer le moins possible à la fois et de rendre chaque règle facile à tester.

Un workflow de nettoyage sûr

Commencez par lister les motifs de paramètres que vous voulez corriger, puis classez-les par risque et impact. Les UTM et les click IDs sont généralement à faible risque et à fort volume. Les session IDs peuvent être plus risqués car ils peuvent affecter la façon dont les pages se chargent pour les utilisateurs connectés.

Une séquence pratique ressemble à ceci :

- Décidez de l'URL cible pour chaque motif de paramètre (par exemple, supprimer

utm_*,gclid,fbclid,sessionid). - Ajoutez des redirections 301 lorsque l'URL paramétrée est un doublon clair de la même page. Gardez à un seul saut.

- Utilisez

rel=canonicalsur les pages où les redirections ne sont pas pratiques (par exemple, quand les paramètres changent le contenu mais que vous voulez quand même une URL principale indexée). - Corrigez la génération d'URL à la source (routeur applicatif, templates CMS, recherche interne, filtres, cache, génération de sitemap).

- Testez des URL réelles de bout en bout, puis surveillez les résultats pendant 2 à 4 semaines pendant que les moteurs recrawlers et que les signaux se consolident.

Les tests comptent. Choisissez des exemples provenant de vrais backlinks (un site d'autorité, une newsletter, un post social) et confirmez que l'URL finale est cohérente, se charge rapidement et affiche le contenu attendu.

Exemple : si un backlink fort pointe vers /pricing?utm_source=partner\u0026utm_campaign=spring, votre règle devrait le 301 vers /pricing (sans paramètres supplémentaires). Si l'attribution est importante, conservez les UTM pour l'analytics, mais évitez qu'ils créent des pages indexables séparées.

Après le déploiement, surveillez les boucles de redirection, les 404 inattendus et les pics dans Search Console comme « Duplicate » ou « Alternate page with proper canonical ».

Paramètres de suivi : garder l'attribution sans créer d'URL dupliquées

Les tags UTM et autres paramètres de suivi sont utiles parce qu'ils indiquent d'où vient une visite. Les problèmes commencent quand ces URL paramétrées deviennent crawlables, indexables et partageables. Vous vous retrouvez alors avec de nombreuses versions de la même page, chacune concurrençant les signaux et encombrant les rapports.

L'objectif est simple : conserver l'attribution, mais faire en sorte que l'URL indexée par les moteurs (et qui accumule la valeur des liens à long terme) soit la version propre et canonique.

Comment traiter les paramètres de suivi sans perdre les données

Décidez quels paramètres sont uniquement de suivi (par exemple : utm_source, utm_medium, utm_campaign, utm_term, utm_content, gclid, fbclid). Ceux-ci ne devraient pas créer de nouvelles pages indexables.

Quand c'est possible, supprimez les paramètres de suivi le plus tôt possible. Une approche courante est une redirection 301 de l'URL paramétrée vers le même chemin sans les paramètres de suivi.

Pour garder cela sûr et prévisible :

- Redirigez uniquement pour les paramètres dont vous êtes sûr qu'ils sont de suivi.

- Gardez la destination exactement la même page, juste sans les params.

- Assurez-vous que l'URL propre est celle que vous utilisez dans les balises canonical et les liens internes.

- Testez quelques URL réelles de campagne avant un déploiement large.

Exceptions à prévoir

Parfois un partenaire ou une plateforme publicitaire exige un paramètre pour leur reporting ou leur processus d'approbation. Dans ces cas, vous pouvez souvent laisser le paramètre pour les utilisateurs tout en gardant l'URL canonique propre pour les moteurs. L'important est que les moteurs comprennent la version préférée et évitent d'indexer la variante de suivi.

Alignez-vous aussi avec vos équipes email et ads. Gardez une règle de tagging courte (paramètres autorisés, nommage, minuscules vs majuscules) pour que les campagnes futures n'inventent pas de nouvelles variantes et ne ramènent pas les doublons.

Filtres et navigation à facettes : où le nettoyage se complique

La navigation à facettes est l'endroit où le nettoyage d'URL cesse d'être un simple « supprimer les params ». Les filtres peuvent créer des milliers de variations de pages qui paraissent différentes pour un utilisateur mais sont des quasi-duplicates pour un moteur. Les coupables fréquents incluent sort=, color=, size=, price=, brand= et inStock=.

Certaines pages filtrées sont réellement utiles. « Chaussures de course homme » peut être large, mais « chaussures de course homme taille 12 » peut présenter une demande réelle. Si vous traitez chaque URL filtrée comme du contenu inutile, vous risquez d'effacer des pages qui devraient ranker.

Une règle pratique est d'autoriser seulement un petit ensemble de pages filtrées à forte demande à être crawlables, et de garder le reste hors index. Cela signifie décider à l'avance quels filtres représentent une vraie page d'atterrissage et lesquels sont de simples contrôles UI.

Ce qui fonctionne souvent est un mélange de :

- Canonicaliser la plupart des pages filtrées vers la catégorie de base quand le contenu est essentiellement le même.

- Utiliser

noindexsur les pages filtrées que vous voulez que les utilisateurs utilisent mais que vous ne voulez pas indexer. - Réduire le gaspillage de crawl pour les variations à faible valeur évidente (surtout

sort=et options d'affichage). - Créer une courte liste de « facettes indexables » avec des URLs stables et intentionnelles.

Soyez prudent avec les redirections massives. Rediriger toutes les URL paramétrées vers la catégorie de base peut casser des vues choisies par l'utilisateur (par exemple, un lien qui attend color=black atterrit soudainement sur une page non filtrée). Cela peut aussi embrouiller les rapports quand le marketing dépend de certains paramètres.

Une approche plus sûre est un nettoyage sélectif : normalisez ce que vous ne voulez pas indexer, et préservez ce que vous voulez intentionnellement voir ranker.

Erreurs courantes qui gaspillent l'équité des liens pendant le nettoyage

L'objectif est de faire en sorte que l'autorité circule vers une URL propre et cohérente. La plupart des problèmes surviennent quand la correction est précipitée et que les règles de destination ne sont pas claires.

Rediriger chaque URL paramétrée vers la page d'accueil (ou une catégorie "assez proche") est une erreur fréquente. Les moteurs considèrent souvent cela comme une erreur douce quand l'URL d'origine ressemblait à une page produit, article ou localisée spécifique. Même si la redirection fonctionne, la pertinence peut chuter et le bénéfice du lien s'affaiblit.

Les chaînes de redirection sont une autre source silencieuse de perte. Par exemple, un backlink atteint /page?utm_source=x, puis redirige vers /page?ref=y, puis enfin vers /page. Les chaînes ralentissent le crawl, augmentent le risque d'échec et rendent la consolidation moins fiable. Visez un hop unique : l'URL paramétrée va directement à la canonique.

Faites aussi attention à l'utilisation d'une redirection 302 (temporaire) pour un nettoyage permanent. Si l'URL paramétrée ne doit jamais être indexée, traitez-la comme permanente. Sinon, vous risquez d'avoir les deux versions qui persistent dans l'index.

Les balises canonical peuvent se retourner contre vous quand elles pointent vers une URL qui n'est pas une page 200, ou quand vous mélangez HTTP et HTTPS. Une canonical doit pointer vers la version exacte que vous voulez indexer, et cette page doit se charger correctement.

Une erreur surprenante est de bloquer les URL paramétrées dans robots.txt trop tôt. Si Google ne peut pas crawler l'URL paramétrée, il peut ne pas voir votre redirection ou votre canonical, ce qui ralentit la consolidation. Laissez d'abord les redirections et les canonicals faire le travail, puis resserrez les règles de crawl si nécessaire.

Enfin, le nettoyage échoue quand le marketing continue de générer de nouveaux motifs de paramètres sans garde-fous. Vous corrigez les liens utm_, puis la campagne suivante invente campaignId, ref ou des session IDs, et les doublons reviennent.

Checklist rapide avant et après déploiement

Traitez le nettoyage comme une petite release : définissez ce qui est "correct", puis vérifiez-le dans des navigateurs réels, des crawlers et des outils de recherche.

Avant le déploiement

Choisissez un petit ensemble d'URL paramétrées réelles déjà présentes dans les backlinks (UTM, session IDs, tri, filtre). Pour chacune, notez l'URL propre unique sur laquelle elle devrait aboutir.

- Confirmez que chaque URL paramétrée d'échantillon aboutit à une URL propre finale (pas plusieurs issues possibles).

- Vérifiez l'absence de chaînes de redirection et de boucles (un saut est idéal).

- Assurez-vous que la balise canonical sur la page finale correspond exactement à l'URL finale.

- Vérifiez que les pages importantes sont accessibles sans paramètres et se chargent rapidement.

- Décidez comment vous gérerez les paramètres "autorisé" (par exemple : conserver les UTM pour l'analytics, mais ne pas en faire des pages indexables).

Après le déploiement

Commencez par des vérifications ponctuelles, puis surveillez la tendance sur quelques semaines. Les redirections et les canonicals peuvent sembler correctes isolément mais se comporter différemment à grande échelle.

- Retestez le même ensemble d'échantillons et confirmez qu'ils se résolvent de la même façon dans un navigateur et dans un crawler.

- Vérifiez que vos pages les plus liées n'ont pas perdu de liens internes ou de chemins de navigation.

- Surveillez Search Console pour une baisse progressive des entrées de doublons ou d'URL alternatives liées aux paramètres.

- Confirmez que les rapports attribuent toujours correctement les campagnes, sans nouvelles pages paramétrées apparaissant comme pages d'atterrissage.

Exemple : corriger des backlinks d'autorité qui pointent vers des URL avec UTM et session

Un site d'autorité lie votre page pricing, mais l'URL utilisée est désordonnée : /pricing?utm_source=techblog\u0026utm_medium=referral.

Un second site lie une version basée sur la session comme /pricing?sessionid=9f3a.... Les deux liens ont de la valeur, mais les URL de destination ne sont pas propres.

Avant le nettoyage, les utilisateurs et les crawlers peuvent voir plusieurs versions de la même page. L'analytics peut afficher plusieurs pages "pricing". Les moteurs peuvent indexer plus d'une URL. L'équité des liens est partagée entre des doublons.

Appliquez une règle claire : l'URL canonique est /pricing, et les paramètres de suivi et de session ne doivent pas créer une nouvelle version.

Pour les session IDs, la correction consiste généralement à les supprimer entièrement. Si votre site génère encore sessionid dans les URL, c'est un problème plus large à résoudre, mais vous pouvez protéger le SEO en redirigeant toute URL contenant sessionid vers /pricing.

Pour les UTM, vous pouvez conserver l'attribution sans garder l'URL désordonnée indexée. Une approche courante : quand une requête arrive avec des paramètres utm_, votre serveur lit et stocke les valeurs de campagne (par exemple, dans des cookies propriétaires ou les logs serveur), puis émet une redirection 301 vers /pricing.

Avec le temps, vous devriez constater une consolidation :

- Moins d'URL paramétrées dans l'index

- Classements et impressions qui se concentrent sur la page principale

/pricing - Les outils de backlinks attribuant davantage de valeur à l'URL canonique

Si vous construisez activement des liens d'autorité, ce nettoyage vaut la peine d'être fait tôt. Quand vous placez ou demandez des liens via un prestataire comme SEOBoosty (seoboosty.com), envoyez l'URL canonique propre dès le départ pour que les mentions les plus fortes renforcent la page que vous voulez réellement positionner.

FAQ

Qu'est-ce qui compte comme paramètre de requête dans une URL de backlink ?

Les paramètres de requête sont tout ce qui suit le ? dans une URL, comme ?utm_source=newsletter ou ?sessionid=123. Ils changent souvent le suivi ou la façon dont une page est affichée, mais peuvent aussi créer de nombreuses URL « différentes » qui affichent le même contenu.

Pourquoi les backlinks avec paramètres peuvent-ils nuire au classement ?

Parce que les moteurs de recherche traitent les URL différentes comme des pages différentes, même si elles semblent identiques. Si les backlinks pointent vers de nombreuses versions paramétrées, l'autorité peut être répartie entre ces doublons, et la version que vous voulez réellement voir ranker pourra se renforcer plus lentement.

Comment trouver quelles URL paramétrées reçoivent des backlinks ?

Commencez par exporter les « URL cibles » exactes depuis votre outil de backlinks et Google Search Console, puis cherchez les ? dans les URL. Groupez-les par chemin de base (tout avant le ?) pour distinguer les paramètres de suivi de ceux qui créent de nombreuses variations proches dupliquées.

Dois-je rediriger les backlinks tagués UTM vers l'URL propre ?

Généralement oui pour les paramètres de suivi uniquement, tant que le contenu est identique et que vous ne cassez pas de fonctionnalité requise. L'approche la plus propre est de faire en sorte que ces demandes aboutissent systématiquement à l'URL canonique, afin que la valeur à long terme des liens se consolide sur une page préférée.

Les identifiants de clic publicitaire comme gclid ou fbclid nécessitent-ils un traitement spécial ?

Traitez les identifiants de clic comme gclid et fbclid comme des paramètres de suivi dans la plupart des cas : ils ne devraient pas devenir des variantes indexables. Si vous les supprimez, assurez-vous que votre configuration de mesure capture d'abord les informations de campagne avant que l'URL ne soit normalisée.

Pourquoi les paramètres de type session sont-ils particulièrement dangereux pour les backlinks ?

Les identifiants de session sont risqués car ils peuvent expirer ou varier selon le visiteur, ce qui transforme de bons backlinks en destinations instables ou cassées. La solution pratique est d'éviter de générer des session IDs dans les URL si possible, et de normaliser les URL entrantes contenant ces paramètres pour qu'elles aboutissent sur une page canonique stable.

Faut-il supprimer ou garder les paramètres de filtre et de tri sur les pages de catégorie ?

Pas forcément : certaines pages filtrées peuvent être de véritables pages d'atterrissage si elles sont stables et ont une demande réelle. Par défaut, il est sûr d'empêcher la plupart des variantes de filtres et de tri de concurrencer votre page catégorie principale, et de n'autoriser qu'un petit ensemble de pages filtrées intentionnelles et stables à être indexables.

Quand dois-je utiliser des redirections 301 vs des balises canonical vs noindex pour les URL paramétrées ?

Utilisez une redirection 301 quand la version paramétrée est un doublon clair et que vous voulez une URL définitive. Utilisez une balise rel=canonical quand le paramètre est utile pour l'utilisateur mais que vous voulez qu'un autre URL soit prioritaire pour les moteurs, et envisagez noindex pour des pages dont les utilisateurs ont besoin mais que vous ne souhaitez pas voir dans les résultats de recherche.

Dois-je bloquer les URL paramétrées dans robots.txt pour arrêter les doublons ?

Les bloquer trop tôt peut ralentir la consolidation parce que Google ne pourra peut-être pas voir votre redirection ou votre canonical. Il est généralement préférable de laisser les redirections et les balises canonical faire leur travail d'abord, puis de restreindre le crawl plus tard si vous devez encore réduire le gaspillage de crawl.

Quelle URL dois-je fournir aux partenaires ou à SEOBoosty lors de la création de backlinks ?

Fournissez l'URL canonique propre exacte que vous voulez voir ranker, sans paramètres de suivi ni de session, et précisez votre format HTTPS et hostname préféré. Si vous placez des liens d'autorité via un prestataire comme SEOBoosty, envoyer l'URL propre dès le départ aide à garantir que les meilleures mentions renforcent la page souhaitée plutôt qu'une variante désordonnée.