Prouver l'impact d'un backlink avec les logs serveur avant que les classements ne changent

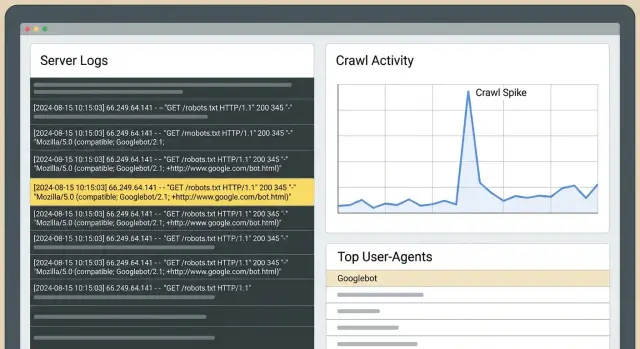

Prouvez l'impact d'un backlink avec les logs serveur en suivant les pics de crawl Googlebot, les chemins des bots et la fréquence de fetch pour confirmer l'effet des liens avant que les classements ne bougent.

Ce que vous pouvez prouver avec les logs avant que les classements ne bougent

Les classements suivent souvent avec du retard. Google doit recrawler les pages, traiter de nouveaux signaux, mettre à jour l'index, puis décider si les positions doivent changer. Ce délai explique pourquoi vous pouvez faire du bon travail et ne rien voir bouger dans les outils de suivi de positions pendant des jours ou des semaines.

Les logs serveur se situent plus tôt dans cette chaîne. Ils peuvent répondre à une question plus simple : est‑ce que Googlebot a changé son comportement sur votre site après la mise en ligne des liens ? Si la réponse est oui, vous avez la preuve qu'il s'est passé quelque chose de réel, même si le trafic et les positions sont encore plats.

Les changements les plus rapides et visibles dans les logs ressemblent généralement à ceci :

- La page ciblée est crawlée plus souvent, ou commence à être crawlée du tout.

- Googlebot revisite cette page plus rapidement (écarts plus courts entre les fetchs).

- Googlebot utilise cette page comme point d'entrée, puis suit des liens internes plus en profondeur.

- Vous voyez des rafales de crawl peu après la mise en ligne, surtout si le site source est souvent crawlé.

C'est différent de Search Console et des outils de suivi de positions. Search Console est utile, mais retardée et agrégée. Les trackers montrent des résultats, pas des causes. Les logs montrent le comportement brut : chaque requête horodatée, quel bot a touché quelle URL et quel code de statut le serveur a renvoyé.

La méthode de base est simple : choisissez une fenêtre « avant » propre et une fenêtre « après » égale, puis comparez l'activité de Googlebot pour les URLs ciblées. Si la période « après » montre un taux de crawl plus élevé et des chemins plus intentionnels, vous pouvez affirmer que les liens ont attiré l'attention de Google.

Exemple : vous pointez un nouveau backlink vers une page produit. Deux jours plus tard, les logs montrent Googlebot fetchant cette page à plusieurs reprises, puis demandant la page des spécifications et la page de tarification auxquelles elle renvoie. Les classements ne bougent peut‑être pas encore, mais Google consacre clairement du budget de crawl là‑bas. C'est souvent la première étape visible avant des gains plus larges.

Notions de base sur les logs serveur (en langage clair)

Un log serveur est un journal des requêtes vers votre site. Chaque fois qu'un navigateur, une application ou un bot de moteur de recherche demande une page ou un fichier, votre serveur (ou CDN) enregistre une ligne.

Pour les contrôles SEO, les champs qui importent le plus sont : horodatage, URL demandée, user‑agent (comme Googlebot), code de statut (200, 301, 404) et généralement une adresse IP. Vous n'avez pas besoin de mémoriser chaque colonne. Chaque ligne répond à : qui a demandé quoi, quand, et qu'est‑ce qui s'est passé.

Quels logs devez‑vous utiliser ?

Commencez par les logs d'accès d'origine si possible. Ce sont les plus proches de la « vérité terrain » et incluent les URLs exactes et les codes de réponse.

Si vous utilisez un CDN/WAF/couche de protection anti‑bot, ses logs peuvent apporter du contexte (requêtes bloquées, challenges), mais ils peuvent filtrer ou étiqueter le trafic d'une manière qui masque une partie du tableau. Dans la mesure du possible, conservez les deux et notez les règles de filtrage qui pourraient modifier ce que vous voyez.

Combien de temps conserver les logs ?

La rétention compte pour les comparaisons avant‑après. Trente jours est un minimum pratique. Soixante à quatre‑vingt‑dix jours sont mieux si vous placez des liens par vagues ou publiez fréquemment. Vous souhaitez suffisamment de données « avant » pour comprendre le crawl normal, et suffisamment « après » pour voir si la fréquence de visite et les itinéraires de crawl ont réellement changé.

Sur la confidentialité : stockez uniquement ce dont vous avez besoin, limitez les accès et supprimez selon un planning. Si les logs contiennent des données personnelles (par exemple des IP complètes ou des chaînes de requête contenant des e‑mails), masquez ou supprimez ces champs. Pour ce type d'analyse, le comportement des bots, les codes de statut et les chemins de pages suffisent.

Distinguer le vrai Googlebot du bruit

Avant d'interpréter un « pic », assurez‑vous que le trafic Googlebot dans vos logs est bien Google. Les faux bots copient souvent le user‑agent de Google. Si vous les comptez, vous pouvez « prouver » une hausse de crawl qui n'a jamais eu lieu.

Les user‑agents sont un point de départ (Googlebot, Googlebot‑Image, AdsBot‑Google), mais ce n'est pas une preuve.

Pourquoi des faux bots apparaissent

Usurper Google aide les scrapers à éviter les blocages, sonder les sites ou récupérer du contenu à grande échelle. Ils peuvent aussi gonfler les requêtes vers des URLs spécifiques et donner l'illusion que Google s'est intéressé aussitôt après la mise en ligne du lien.

Moyens simples de valider Googlebot

Choisissez une méthode et utilisez‑la de manière cohérente :

- Vérification reverse DNS : l'IP doit résoudre vers un nom d'hôte appartenant à Google, et ce nom d'hôte doit résoudre de nouveau vers la même IP.

- Contrôles de cohérence : le vrai Googlebot tend à afficher un comportement régulier (fetchs robots.txt fréquents, navigation sensée).

Si possible, séparez Googlebot Smartphone de Googlebot Desktop. Ils se comportent souvent différemment. Un changement peut apparaître d'abord sur Smartphone alors que Desktop reste stable.

Quatre signaux dans les logs qui suggèrent que les liens ont modifié le comportement

Les classements prennent du retard sur ce que Googlebot fait déjà. Après une mise en ligne, ces signaux précoces dans les logs valent la peine d'être surveillés.

Signal 1 : hausse de crawl soutenue sur la page cible

Un signe fort est une augmentation notable des requêtes Googlebot sur la page vers laquelle vous avez pointé, soutenue sur plusieurs jours. Comparez période à période (même jours de la semaine) pour ne pas confondre les cycles hebdomadaires normaux avec un « gain ».

Signal 2 : fréquence de fetch plus élevée (cycles de revisit plus courts)

Quand Google s'intéresse davantage, il revient souvent plus vite. Dans les logs, vous verrez des écarts plus courts entre les hits sur la même URL. Cela peut se produire bien avant un gain de position, surtout pour des pages auparavant peu crawlées.

Signal 3 : chemins de bot qui s'étendent depuis la page d'atterrissage

Après que Googlebot ait touché la page liée, vérifiez ce qu'il demande ensuite dans la même session, ou dans une courte fenêtre temporelle. Si la découverte s'est améliorée, vous verrez un mouvement plus systématique depuis la page cible vers des URLs connexes (catégories, articles support, pages produit clés).

Signal 4 : premiers crawls pour des URLs voisines

Si la page ciblée renvoie à d'autres pages qui étaient peu crawlées, surveillez les premiers fetchs de ces URLs. Ce pattern de « diffusion » signifie souvent que Googlebot explore, pas seulement qu'il vérifie une page.

Sur ces quatre signaux, les codes de statut décident si le crawl est utile :

- 200 signifie que Googlebot a obtenu du contenu qu'il peut évaluer.

- 301 n'est pas toujours mauvais, mais les chaînes de redirections longues gaspillent le budget de crawl.

- 404 peut créer des pics bruyants sans valeur.

- Les erreurs 5xx entraînent souvent des baisses de crawl ultérieures.

Mettre en place une comparaison avant‑après fiable

Le plus grand risque avec la validation via logs est une comparaison brouillonne. Googlebot change de comportement pour de nombreuses raisons, donc votre configuration devrait faire de la « mise en ligne du lien » la variable principale.

Utilisez deux fenêtres égales : communément 14 à 28 jours avant la mise en ligne (baseline), et la même durée après.

Puis suivez un petit ensemble de pages spécifiques :

- L'URL qui a reçu le nouveau lien.

- La page qui vous intéresse finalement (si différente).

- 2 à 3 pages étroitement liées dans la même section du site.

- Une page témoin dans le même template/dossier qui n'a pas reçu de nouveaux liens.

Pour chaque page, suivez les hits quotidiens de Googlebot, les URLs uniques crawlées dans ce cluster, et le temps médian entre fetchs. La médiane est plus stable que la moyenne quand des rafales faussent les données.

Avant de comparer, faites quelques vérifications rapides : confirmez que le lien est en ligne et indexable pendant la fenêtre « après », évitez les changements majeurs du site dans les fenêtres (migrations, gros changements de template), appliquez les mêmes règles de validation et de filtrage des bots, et gardez votre page témoin comparable.

Étape par étape : valider l'impact d'un lien depuis les logs

Vous n'avez pas besoin que les positions bougent pour voir des changements de comportement précoces. Si le lien a été découvert et traité comme un signal significatif, les logs le montrent généralement en premier.

Un workflow pratique :

- Extraire les logs bruts pour une fenêtre « avant » propre et une fenêtre « après » correspondante.

- Filtrer pour ne garder que les requêtes Googlebot vérifiées, et séparer Smartphone et Desktop si disponible.

- Grouper par URL et par jour. Cherchez des hausses concentrées sur les pages ciblées, pas seulement une augmentation sitewide.

- Examiner les chemins : après que Googlebot a fetché la page liée, que demande‑t‑il ensuite ?

- Rédiger une phrase de conclusion par page en utilisant le même modèle à chaque fois.

Gardez les conclusions strictes et testables. Par exemple : « Après la mise en ligne, Googlebot Smartphone a augmenté ses fetchs sur /pricing de 3 par semaine à 11 par semaine puis a crawlé /features et /checkout dans les 10 minutes, ce qui n'arrivait pas pendant la fenêtre baseline. »

Si vous ne pouvez pas formuler une phrase claire comme celle‑ci, la fenêtre de comparaison est probablement trop bruyante ou vous mélangez Googlebot avec d'autres crawlers.

Interpréter les chemins de bot : ce que Googlebot fait après avoir trouvé un lien

Quand un nouveau backlink est découvert, Googlebot ne change que rarement les classements du jour au lendemain. Il change souvent d'abord son itinéraire sur votre site. L'analyse des chemins, c'est lire les traces de Googlebot : ce qu'il demande d'abord, ce qu'il demande ensuite et à quelle fréquence il revient.

Séparez mentalement deux URLs :

- L'URL liée (où pointe le backlink).

- La page « money » (la page que vous voulez gagner).

Souvent l'URL liée se réchauffe d'abord, puis transmet de l'attention via des liens internes.

Une comparaison utile est celle des points d'entrée. Avant le lien, Googlebot entrait peut‑être par la page d'accueil ou le sitemap. Après le lien, vous pouvez voir Googlebot arriver directement sur l'URL liée puis se déplacer en profondeur via des liens internes.

Surveillez ces changements :

- Des hits plus fréquents sur l'URL liée.

- Des pages plus profondes crawlées plus tôt et plus régulièrement.

- Des cycles de refresh plus courts sur les pages du cluster.

- Des pics d'URLs à paramètres ou dupliquées (souvent un signe de gaspillage de crawl, pas de progrès).

Si les URLs avec paramètres (comme ?sort= ou la pagination) augmentent, le backlink peut toujours aider, mais les logs vous indiquent aussi de nettoyer les pièges de crawl pour que Googlebot passe plus de temps sur vos pages importantes.

Erreurs courantes qui mènent à de fausses conclusions

Les logs peuvent apporter une preuve précoce, mais ils peuvent aussi amplifier le bruit normal.

L'échec le plus courant est de comparer deux périodes qui ne sont pas réellement comparables. Les hausses de crawl peuvent être causées par des redesigns, des changements de navigation, de nouvelles pages, des modifications de robots.txt, des règles WAF/firewall, et des problèmes de codes de statut (chaînes de redirections, pics de 404, erreurs 5xx).

Une autre erreur fréquente est de compter tous les bots, y compris les user‑agents usurpés.

Avant de valider un « gain », vérifiez les bases : comparez les mêmes jours de la semaine, révisez les modifications de robots et d'indexation dans la fenêtre, séparez les résultats par code de statut (200 vs 3xx vs 4xx/5xx), filtrez sur Googlebot vérifié uniquement et recherchez une hausse soutenue plutôt qu'un pic d'une journée.

Exemple : vous achetez un backlink vers /pricing, et deux jours après Googlebot touche /pricing 5x plus. Mais si vous avez aussi déployé un redesign qui ajoute des liens d'en‑tête vers /pricing, la hausse peut venir de la découverte interne et non du backlink externe.

Checklist rapide : les nouveaux liens ont‑ils changé le comportement de Google ?

Utilisez la même fenêtre temporelle des deux côtés (par exemple 14 jours avant la mise en ligne vs 14 jours après). Filtrez sur les requêtes Googlebot vérifiées, puis répondez à ces questions :

- Les requêtes vers l'URL cible liée ont‑elles augmenté de façon significative ?

- Le crawl est‑il devenu plus régulier sur la semaine au lieu d'un pic isolé ?

- Le temps typique entre fetchs a‑t‑il diminué pour l'URL cible et ses pages de support proches ?

- Le taux d'erreurs est‑il resté stable pendant que le crawl augmentait ?

- Une page témoin similaire est‑elle restée relativement plate ?

Si vous avez trois réponses « oui » ou plus, le comportement de Googlebot a probablement changé même si les positions n'ont pas encore évolué.

Deux vérifications supplémentaires pour rester honnête : assurez‑vous que le changement n'est pas sitewide, et que le timing correspond (commence peu après la mise en ligne et reste élevé).

Scénario d'exemple : prouver l'impact pour une page en 3 semaines

Une société SaaS a une page fonctionnalité qui convertit bien, mais qui ne reçoit pas encore beaucoup de trafic organique. Elle ajoute trois nouveaux backlinks pointant directement vers cette page. Elle veut une preuve qu'il s'est passé quelque chose sans attendre les classements.

Avant les liens, elle extrait une baseline des logs serveur pour cette URL : hits Googlebot par jour, intervalles entre visites, et quelles URLs Googlebot visite juste après.

Semaine 1 : quelques jours plus tard, les logs montrent une hausse de crawl. Plus important, Googlebot ne s'arrête pas à la page fonctionnalité. Il commence à explorer des chemins voisins comme pricing, integrations et articles supports. Ce « fan‑out » signale souvent un nouveau point d'entrée.

Semaine 2 à 3 : le taux de revisit augmente et les écarts de crawl se réduisent. Vous pouvez aussi voir plus de 304 (non modifié), ce qui est normal quand Google vérifie souvent sans que le contenu ait changé.

Pour expliquer cela à un stakeholder sans parler de positions, montrez le changement de comportement : requêtes quotidiennes avant/après sur la page fonctionnalité, médiane des heures entre visites, et les URLs les plus fréquemment crawlées après la page fonctionnalité.

Si les logs ne montrent aucun changement après 2–3 semaines, n'en déduisez pas que les liens ont échoué. Vérifiez les blocages (robots.txt, noindex, 4xx/5xx), renforcez le maillage interne vers la page, et réévaluez si la cible du lien devrait être une page hub à la place.

Étapes suivantes : transformer la preuve des logs en processus reproductible

Une fois que vous pouvez valider les effets des liens dans les logs, faites‑en une routine mensuelle. Gardez une fenêtre cohérente (comme les 30 derniers jours) et reportez toujours les mêmes métriques : quelles pages ont reçu le plus de hits Googlebot, où les hausses de crawl se sont concentrées après le travail de liens, comment les écarts médians entre fetchs ont changé sur les pages clés, quels chemins sont apparus ou se sont renforcés, et quelles erreurs gaspillent peut‑être le crawl.

Si vous utilisez un fournisseur comme SEOBoosty (seoboosty.com) pour sécuriser des insertions, conservez un enregistrement des dates exactes de mise en ligne et des URLs cibles. Un timing propre facilite grandement les comparaisons avant/après dans les logs et rend vos conclusions plus solides.

FAQ

Pourquoi les logs peuvent montrer du progrès alors que les classements ne bougent pas ?

Les classements nécessitent un nouveau crawl, le traitement des signaux, une mise à jour de l'index, puis une réévaluation des positions. Les logs se situent plus tôt dans cette chaîne et peuvent montrer si Googlebot a modifié son comportement de crawl peu après la mise en ligne d'un lien, même si les outils de suivi de positions restent plats.

Quel est le signe le plus clair dans les logs qu'un nouveau backlink a été repéré ?

Recherchez une augmentation soutenue des hits de Googlebot vérifié sur l'URL exactement liée, ainsi que des intervalles de revisit plus courts. La confirmation la plus forte est quand Googlebot arrive sur la page liée puis crawle régulièrement, peu après, des pages plus profondes qui vous intéressent.

Combien de temps devraient durer mes fenêtres “avant” et “après” ?

Utilisez des fenêtres égales de part et d'autre de la date de mise en ligne, généralement 14 à 28 jours avant et la même durée après. Alignez les jours de la semaine lors de la comparaison, car les rythmes de crawl varient souvent entre week-ends et jours ouvrés.

Quels logs dois‑je utiliser : logs d'origine ou logs CDN/WAF ?

Commencez par les logs d'accès d'origine parce qu'ils reflètent le plus fidèlement ce que votre serveur a réellement renvoyé, y compris les codes de statut précis. Si vous dépendez d'un CDN, WAF ou protection bot, conservez aussi ces logs en complément, mais sachez qu'ils peuvent filtrer ou marquer le trafic.

Comment m'assurer que “Googlebot” dans mes logs est bien Google ?

Ne vous fiez pas au seul user-agent car des bots malveillants s'en servent. La méthode pratique est la validation reverse DNS : l'IP doit résoudre vers un nom d'hôte appartenant à Google, puis ce nom d'hôte doit résoudre de nouveau vers la même IP, ce qui confirme un vrai Googlebot.

Dois‑je séparer Googlebot Smartphone et Desktop dans l'analyse ?

Séparez‑les quand c'est possible, car Googlebot Smartphone et Googlebot Desktop crawlent souvent différemment et un changement peut apparaître sur l'un avant l'autre. Si vous ne regardez qu'une vue combinée, un vrai signal peut être dilué et sembler n'être « aucun changement ».

Comment distinguer une vraie augmentation de crawl du bruit normal ?

Un vrai changement est généralement soutenu sur plusieurs jours et concentré sur les pages ciblées, pas seulement un pic d'une journée. Vérifiez aussi que le timing correspond à la mise en ligne du lien et qu'une page témoin reste à peu près stable.

Quels codes de statut importent le plus pour juger des changements de crawl ?

Un code 200 signifie que Googlebot a reçu du contenu qu'il peut évaluer, donc l'augmentation de crawl est utile. Des 301 fréquents et des chaînes de redirections longues gaspillent le budget de crawl, des pics de 404 créent de l'activité trompeuse, et des erreurs 5xx peuvent entraîner une baisse du crawl par la suite.

Comment analyser les chemins de bots après que la page liée a été crawlée ?

Suivez les points d'entrée et ce que Googlebot demande ensuite après avoir visité l'URL liée, dans une courte fenêtre temporelle. Si la page liée devient un point de départ cohérent puis que Googlebot crawle des pages connexes (pricing, specs, contenus supports), c'est une forte preuve que le lien a amélioré la découverte.

Quelle est la meilleure façon de présenter l'impact d'un backlink depuis les logs à un stakeholder ?

Rédigez une phrase stricte et testable par URL cible qui indique le changement avant/après en volume de fetchs et en fréquence de revisit, plus une observation sur un changement de chemin s'il existe. Si vous utilisez un fournisseur comme SEOBoosty, conservez les dates précises de mise en ligne et les URLs cibles pour que vos fenêtres de comparaison restent propres et crédibles.