Comprove o impacto dos backlinks com logs do servidor antes das posições mudarem

Comprove o impacto de backlinks com logs do servidor acompanhando picos de crawl do Googlebot, caminhos de bot e frequência de fetch para confirmar efeitos antes que rankings mudem.

O que você pode comprovar com logs antes dos rankings mudarem

Os rankings costumam atrasar. O Google precisa recrawlear páginas, processar novos sinais, atualizar o índice e então decidir se as posições devem mudar. Esse atraso é o motivo pelo qual você pode fazer um bom trabalho e ainda não ver movimentação nos rastreadores de posições por dias ou semanas.

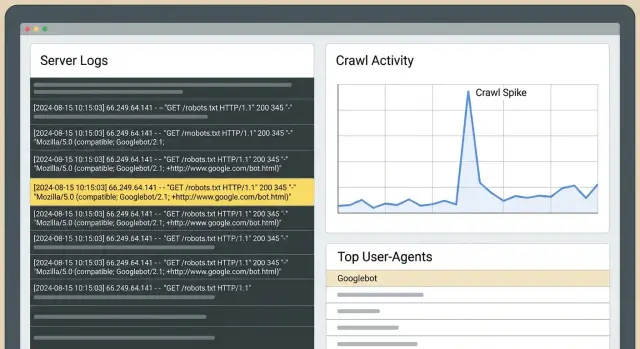

Os logs do servidor estão mais cedo nessa cadeia. Eles podem responder a uma pergunta mais simples: o Googlebot mudou o que faz no seu site depois que os links foram publicados? Se a resposta for sim, você tem evidência de que algo real aconteceu, mesmo se tráfego e posições ainda estiverem estáveis.

As mudanças mais rápidas e visíveis nos logs geralmente parecem com isto:

- A página linkada passa a ser rastreada com mais frequência, ou começa a ser rastreada pela primeira vez.

- O Googlebot revisita essa página mais cedo (intervalos menores entre fetches).

- O Googlebot usa essa página como ponto de entrada e depois segue links internos para páginas mais profundas.

- Você vê rajadas de crawl logo após a colocação, especialmente quando o site que linka é rastreado frequentemente.

Isto é diferente do Search Console e dos rank trackers. O Search Console é útil, mas atrasado e agrupado. Os trackers mostram resultados, não causas. Os logs mostram comportamento bruto: cada pedido, com carimbo de data/hora, qual bot acertou qual URL e qual código de status o seu servidor retornou.

O método central é simples: escolha uma janela limpa de “antes” e uma de “depois” e compare a atividade do Googlebot nas URLs específicas que você mirou. Se o período “depois” mostrar maior taxa de crawl e caminhos mais intencionais, você pode dizer que os links mudaram a atenção do Google.

Exemplo: você aponta um novo backlink para uma página de produto. Dois dias depois, os logs mostram o Googlebot buscando repetidamente essa página, depois solicitando a página de especificações e a de preços que ela linka. Os rankings podem não ter mudado ainda, mas o Google claramente está gastando orçamento de rastreio ali. Esse costuma ser o primeiro passo visível antes de ganhos mais amplos.

Noções básicas de logs do servidor (em linguagem simples)

Um log do servidor é um diário de pedidos ao seu site. Cada vez que um navegador, app ou bot de busca pede uma página ou arquivo, seu servidor (ou CDN) registra uma linha.

Para verificações de SEO, os campos que mais importam são: timestamp, URL requisitada, user-agent (como Googlebot), código de status (200, 301, 404) e geralmente um endereço IP. Você não precisa memorizar todas as colunas. Cada linha responde: quem pediu o quê, quando e o que aconteceu.

Quais logs você deve usar?

Comece pelos logs de acesso da origem, se puder. Eles são os mais próximos da “verdade” e incluem as URLs exatas e os códigos de resposta.

Se usar CDN/WAF/camadas de proteção de bot, esses logs podem adicionar contexto (pedidos bloqueados, desafios), mas podem filtrar ou rotular o tráfego de maneiras que escondam parte do quadro. Quando possível, mantenha ambos e anote quaisquer regras de filtragem que possam alterar o que você vê.

Por quanto tempo devo guardar logs?

A retenção importa para comparações antes-vs-depois. Trinta dias é um mínimo prático. Sessenta a noventa dias é melhor se você faz colocações em ondas ou publica com frequência. Você quer dados “antes” suficientes para entender o rastreio normal e dados “depois” suficientes para ver se a frequência de visitas e as rotas de crawl realmente mudaram.

Sobre privacidade: armazene apenas o que precisa, limite o acesso e apague conforme um cronograma. Se os logs contiverem dados pessoais (por exemplo, IPs completos ou strings de consulta com emails), masque ou remova esses campos. Para essa análise, o que importa é comportamento de bots, códigos de status e caminhos das páginas.

Identificando o Googlebot real vs ruído

Antes de interpretar qualquer “pico”, tenha certeza de que o tráfego de Googlebot nos seus logs é realmente do Google. Bots falsos frequentemente copiam o user-agent do Google. Se você contá-los, pode “comprovar” uma onda de crawl que nunca aconteceu.

Strings de user-agent são um ponto de partida (Googlebot, Googlebot-Image, AdsBot-Google), mas não são prova.

Por que bots falsos aparecem

Falsificar o Google ajuda scrapers a evitar bloqueios, sondar sites ou puxar conteúdo em escala. Eles também podem inflar pedidos a URLs específicas e fazer parecer que o Google se interessou logo após você construir links.

Maneiras simples de validar o Googlebot

Escolha um método e use-o consistentemente:

- Verificação reversa de DNS: o IP deve resolver para um hostname do Google, e esse hostname deve resolver de volta para o mesmo IP.

- Checagens de padrão: o Googlebot real tende a mostrar comportamento estável (buscar robots.txt regularmente, navegação sensata).

Se puder, separe Googlebot Smartphone de Googlebot Desktop. Eles costumam se comportar diferente. Uma mudança pode aparecer primeiro no Smartphone enquanto o Desktop fica estável.

Quatro sinais nos logs que sugerem que os links mudaram o comportamento

Os rankings ficam atrás do que o Googlebot já está a fazer. Após a publicação de uma colocação, estes são os sinais iniciais nos logs que valem atenção.

Sinal 1: Aumento sustentado de crawl na página alvo

Um sinal forte é um aumento notável em pedidos do Googlebot à página que você linkou, sustentado por vários dias. Compare igual por igual (mesmos dias da semana) para não confundir ciclos semanais normais com uma “vitória”.

Sinal 2: Maior frequência de fetch (ciclos de revisita menores)

Quando o Google se importa mais, ele costuma voltar mais cedo. Nos logs, você verá lacunas menores entre hits à mesma URL. Isso pode acontecer bem antes de qualquer subida de ranking, especialmente em páginas que antes eram rastreadas raramente.

Sinal 3: Caminhos de bot que se expandem a partir da página de destino

Depois que o Googlebot busca a página linkada, verifique o que ele solicita em seguida na mesma sessão, ou dentro de uma janela de tempo curta. Se a descoberta melhorou, você verá movimento mais consistente da página alvo para URLs relacionadas (páginas de categoria, artigos de suporte, páginas de produto-chave).

Sinal 4: Crawls pela primeira vez em URLs próximas

Se a página alvo linka para outras páginas que eram pouco rastreadas, observe buscas pela primeira vez nessas URLs. Esse padrão de “fan out” costuma significar que o Googlebot está a explorar, não apenas a rechecagem de uma página.

Em todos os quatro sinais, os códigos de status decidem se o rastreio é útil:

- 200 significa que o Googlebot obteve conteúdo que pode avaliar.

- 301 nem sempre é ruim, mas cadeias longas de redirecionamento desperdiçam orçamento de rastreio.

- 404 pode criar picos ruidosos sem valor.

- 5xx frequentemente leva a quedas de rastreio depois.

Configure uma comparação antes-e-depois que você possa confiar

O maior risco com validação baseada em logs é uma comparação desorganizada. O Googlebot muda seu comportamento por muitos motivos, então sua configuração deve fazer da “data de publicação do link” a variável principal.

Use duas janelas iguais: comumente 14 a 28 dias antes do link ir ao ar (baseline) e o mesmo número de dias depois.

Em seguida, acompanhe um conjunto pequeno e específico de páginas:

- A URL que recebeu o novo link.

- A página que você realmente quer (se for diferente).

- 2 a 3 páginas estreitamente relacionadas na mesma seção do site.

- Uma página de controle no mesmo template/pasta que não recebeu novos links.

Para cada página, acompanhe hits diários do Googlebot, URLs únicas rastreadas naquele cluster e o tempo mediano entre fetches. A mediana é mais estável do que a média quando rajadas de crawl distorcem os dados.

Antes de comparar, faça verificações rápidas: confirme que o link está ativo e indexável na janela “depois”, mantenha grandes mudanças do site fora das janelas (migrações, grandes alterações de template), aplique as mesmas regras de validação e filtragem de bots e mantenha sua página de controle comparável.

Passo a passo: validar o impacto do link pelos logs

Você não precisa de rankings para ver mudanças de comportamento iniciais. Se o link foi descoberto e tratado como sinal significativo, os logs geralmente mostram isso primeiro.

Um fluxo de trabalho prático:

- Extraia logs brutos para uma janela “antes” limpa e uma janela “depois” correspondente.

- Filtre para pedidos verificados do Googlebot e separe Smartphone vs Desktop se disponível.

- Agrupe por URL e por dia. Procure elevações concentradas nas páginas que você mirou, não apenas um aumento sitewide.

- Revise caminhos: depois que o Googlebot busca a página linkada, o que ele solicita em seguida?

- Escreva uma frase de conclusão por página usando o mesmo template toda vez.

Mantenha as conclusões estritas e testáveis. Por exemplo: “Após o link ir ao ar, o Googlebot Smartphone aumentou fetches em /pricing de 3 por semana para 11 por semana e então rastreou /features e /checkout dentro de 10 minutos, o que não ocorreu na janela baseline.”

Se você não consegue escrever uma frase clara assim, a janela de comparação provavelmente está barulhenta ou você está misturando Googlebot com outros rastreadores.

Interpretando caminhos de bot: o que o Googlebot faz depois que encontra um link

Quando um novo backlink é descoberto, o Googlebot raramente muda rankings da noite para o dia. Frequentemente ele muda sua rota pelo site primeiro. A análise de caminhos é apenas ler os passos do Googlebot: o que ele solicita primeiro, o que solicita depois e com que frequência retorna.

Separe duas URLs na sua cabeça:

- A URL linkada (onde o backlink aponta).

- A página “money” (a página que você quer que vença).

Muitas vezes a URL linkada aquece primeiro e depois transfere atenção através de links internos.

Uma comparação útil são pontos de entrada. Antes do link, o Googlebot pode entrar pela sua homepage ou sitemap. Depois do link, você pode ver o Googlebot pousar diretamente na URL linkada e então mover-se para páginas internas.

Fique de olho nestas mudanças:

- Hits mais frequentes na URL linkada.

- Páginas mais profundas sendo rastreadas mais cedo e com mais consistência.

- Ciclos de atualização mais curtos nas páginas desse cluster.

- Picos em URLs com parâmetros ou duplicadas (frequentemente sinal de desperdício de crawl, não progresso).

Se URLs com parâmetros subirem (como ?sort= ou paginação), o backlink pode ainda estar ajudando, mas os logs também estão dizendo para limpar armadilhas de crawl para que o Googlebot gaste mais tempo nas suas páginas importantes.

Erros comuns que levam a conclusões falsas

Os logs podem dar prova precoce, mas também podem amplificar ruído normal.

A falha mais comum é comparar dois períodos que na prática não são comparáveis. Elevações de crawl podem ser causadas por redesigns, mudanças de navegação, lançamento de novas páginas, edições de robots.txt, regras de WAF/firewall e problemas de código de status (cadeias de redirecionamento, picos de 404, erros 5xx).

Outro erro frequente é contar todos os bots, incluindo user-agents falsificados.

Antes de confiar em uma “vitória”, verifique o básico: compare os mesmos dias da semana, reveja alterações de robots e indexação na janela, separe resultados por código de status (200 vs 3xx vs 4xx/5xx), filtre para Googlebot verificado apenas e procure por um aumento sustentado em vez de um pico de um dia.

Exemplo: você compra um backlink para /pricing e dois dias depois o Googlebot bate em /pricing 5x mais. Mas se você também lançou um redesign que adicionou links no cabeçalho para /pricing, o aumento pode ser descoberta interna, não o backlink externo.

Checklist rápido: os novos links mudaram o comportamento do Google?

Use a mesma janela de tempo em ambos os lados (por exemplo, 14 dias antes da colocação vs 14 dias depois). Filtre para pedidos verificados do Googlebot, então responda a estas perguntas:

- Os pedidos para a URL alvo linkada aumentaram de forma significativa?

- O rastreio ficou mais estável ao longo da semana em vez de um pico aleatório?

- O tempo típico entre fetches diminuiu para a URL alvo e suas páginas de suporte mais próximas?

- As taxas de erro se mantiveram estáveis enquanto o rastreio aumentou?

- Uma página de controle similar permaneceu aproximadamente estável?

Se você responder “sim” a três ou mais, o comportamento do Googlebot provavelmente mudou mesmo se as posições ainda não se moveram.

Duas verificações extra mantêm isso honesto: garanta que a mudança não é sitewide e que o timing bate (começa logo após a publicação e se mantém elevado).

Cenário de exemplo: provar impacto para uma página em 3 semanas

Uma empresa SaaS tem uma página de funcionalidade que converte bem, mas ainda não recebe muito tráfego orgânico. Eles adicionam três novos backlinks apontando diretamente para essa página. Querem provar que algo mudou sem esperar pelos rankings.

Antes dos links irem ao ar, eles extraem um baseline dos logs do servidor para essa URL: hits diários do Googlebot, lacunas de tempo entre hits e quais URLs o Googlebot visita logo em seguida.

Semana 1: dentro de alguns dias, os logs mostram um aumento de crawl. Mais importante, o Googlebot não para na página de funcionalidade. Ele começa a explorar caminhos próximos, como preços, integrações e artigos de suporte. Esse comportamento de “fan out” costuma sinalizar um novo ponto de entrada.

Semana 2 a 3: a taxa de revisita aumenta e as lacunas de crawl encurtam. Você também pode ver mais respostas 304 (not modified), o que é normal quando o Google verifica com frequência e o conteúdo não mudou.

Para explicar isso a um stakeholder sem falar de rankings, mostre a mudança de comportamento: antes vs depois de pedidos diários para a página de funcionalidade, mediana de horas entre visitas e as URLs mais comuns rastreadas após a página de funcionalidade.

Se os logs não mostrarem mudança após 2 a 3 semanas, não presuma que os links falharam. Verifique bloqueios (robots.txt, noindex, 4xx/5xx), fortaleça o linking interno para a página e reavalie se o alvo do link deveria ser uma página hub em vez dela.

Próximos passos: transforme a prova dos logs em um processo repetível

Depois que você conseguir validar efeitos de links nos logs, faça disso uma rotina mensal. Mantenha uma janela consistente (como os últimos 30 dias) e reporte os mesmos poucos métricas toda vez: quais páginas receberam mais hits do Googlebot, onde as elevações de crawl se concentraram após o trabalho de links, como as lacunas medianas entre fetches mudaram nas páginas-chave, quais caminhos apareceram ou se fortaleceram e quais erros podem estar desperdiçando crawl.

Se estiver usando um provedor como SEOBoosty (seoboosty.com) para garantir colocações, registe as datas exatas de go-live e as URLs alvo. Cronometragem limpa facilita muito as comparações de logs antes-e-depois e torna as conclusões mais confiáveis.

FAQ

Why can logs show progress even when rankings don’t move?

Os rankings exigem recrawl, processamento de sinais, atualizações de índice e depois a reavaliação das posições. Os logs ficam mais cedo nessa cadeia, por isso podem mostrar se o Googlebot mudou seu comportamento de rastreio logo após um link ser publicado, mesmo quando os rastreadores de posição permanecem estáveis.

What’s the clearest log sign that a new backlink was noticed?

Procure um aumento sustentado em acessos verificados do Googlebot à URL exata que recebeu o backlink, além de intervalos menores entre buscas. A confirmação mais forte é quando o Googlebot pousa na página vinculada e então rastreia consistentemente páginas profundas relacionadas logo em seguida.

How long should my “before” and “after” windows be?

Use janelas iguais antes e depois da data de publicação, normalmente 14–28 dias antes e o mesmo período depois. Combine os dias da semana ao comparar, pois os padrões de rastreio costumam variar entre fim de semana e dias úteis.

Which logs should I use: origin logs or CDN/WAF logs?

Comece com os logs de acesso da origem porque eles estão mais próximos da “verdade” e incluem códigos de resposta precisos. Se usar CDN, WAF ou proteção de bots, mantenha esses logs como suplementares, pois eles podem filtrar ou rotular tráfego.

How do I make sure “Googlebot” in my logs is actually Google?

Não confie apenas no user-agent, porque bots falsos copiam isso. A verificação prática é a validação reversa de DNS: o IP deve resolver para um hostname pertencente ao Google e esse hostname deve resolver de volta para o mesmo IP, garantindo que você está contando o Googlebot real.

Should I separate Googlebot Smartphone vs Desktop in analysis?

Separe quando puder, pois eles costumam rastrear de maneiras diferentes e mudanças podem aparecer em um antes do outro. Se olhar apenas uma visão combinada, uma alteração real pode diluir e parecer “sem mudança”.

How do I tell a real crawl lift from normal noise?

Uma mudança real costuma ser sustentada por vários dias e concentrada nas páginas alvo, não apenas um pico de um dia. Confirme também se o momento coincide com a publicação do link e se a sua página de controlo se manteve estável.

Which status codes matter most when judging crawl changes?

Um 200 significa que o Googlebot recebeu conteúdo que pode avaliar, então aumentos de crawl são úteis. 301s frequentes e cadeias longas de redirecionamento desperdiçam orçamento de rastreio; picos de 404 criam atividade enganosa; e erros 5xx podem levar a quedas de rastreio.

How do I analyze bot paths after the linked page gets crawled?

Acompanhe pontos de entrada e o que o Googlebot solicita em seguida após visitar a URL vinculada, dentro de uma janela de tempo curta. Se a página ligada se tornar um ponto de partida consistente e o Googlebot passar a rastrear páginas relacionadas (como preços, especificações ou conteúdo de suporte), isso é forte evidência de que o link melhorou a descoberta.

What’s the best way to report backlink impact from logs to a stakeholder?

Escreva uma frase estrita e testável por URL alvo que indique a mudança antes vs depois no volume de buscas e no tempo de revisita, mais uma alteração de caminho observada se existir. Se usar um provedor como SEOBoosty (seoboosty.com), registe as datas exatas de ativação e as URLs alvo para que as janelas de comparação fiquem limpas e as conclusões credíveis.