Очистка обратных ссылок с параметрами: сохраняйте авторитетные ссылки чистыми

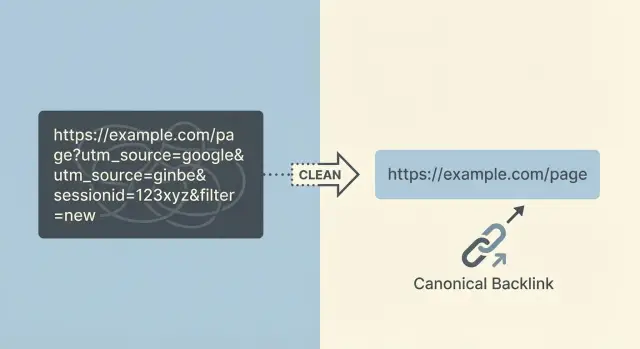

Узнайте, как очищать обратные ссылки с параметрами запроса, чтобы направлять авторитетные ссылки на чистые URL, избегать дубликатов и безопасно консолидировать сигналы ранжирования.

Что идёт не так, когда в обратных ссылках есть параметры запроса

Параметры запроса — это дополнительные части, которые добавляют к концу URL после вопросительного знака. Они выглядят как ?utm_source=newsletter или ?sessionid=123. Их используют для отслеживания кликов, сохранения корзины, применения фильтров или показа определённого вида страницы.

Проблема в том, что одна страница внезапно может получить десятки (а то и тысячи) «разных» URL, которые по сути загружают одно и то же содержимое. Одна ссылка приходит из письма с UTM-метками, другая — через партнёрский идентификатор, третья — после применения фильтра на сайте. Каждая версия — новый URL, даже если страница выглядит идентично.

За этим быстро следуют неприятные последствия:

- Авторитет ссылок распределяется между множеством версий URL вместо того, чтобы усиливать один предпочтительный адрес.

- Поисковые системы могут сканировать и индексировать «неправильные» версии, создавая дубликаты.

- Аналитика и отчётность становятся запутанными, потому что одна и та же страница отображается под разными URL.

- Некоторые параметризированные URL истекают или ломаются (например, session ID), поэтому хорошие обратные ссылки могут вести в никуда.

- Ценность ссылок размывается, если параметризованная версия перенаправляется непоследовательно.

Частые источники: теги трекинга (UTM из email-инструментов и рекламы), партнёрские ID, session ID, фасетные фильтры (например color=black или sort=price), внутренние страницы результатов поиска и кнопки «поделиться», которые по умолчанию добавляют параметры.

Цель простая: когда существует сильная обратная ссылка, она должна надёжно разрешаться в один предпочтительный, канонический URL. Этот URL должен быть тем, куда вы действительно хотите приводить людей и поисковые системы.

«Чистый URL» — это стабильный (не меняется при каждом визите), удобный для копирования и вставки и индексируемый (подходит для результатов поиска). Чем чище ваш целевой URL, тем легче защищать ценность заслуженных авторитетных ссылок.

Почему параметризованные обратные ссылки вредят ранжированию и отчётности

Когда крупный сайт ссылается на вас, вы хотите, чтобы вся эта ценность пришла на одну чистую и стабильную страницу. Если ссылка ведёт на URL с лишними параметрами, ценность может распределяться по нескольким версиям того же самого содержимого.

Как это тянет вниз ранжирование

Поисковые системы рассматривают разные URL как разные страницы, даже если человек видит одно и то же. Если у вас есть ссылки, ведущие на:

/product/product?utm_source=newsletter/product?session=12345/product?color=blue\u0026sort=price

то эти ссылки могут оказаться распределёнными между несколькими версиями URL. Вместо одной страницы с сильным авторитетом вы получаете несколько слабее, которые конкурируют друг с другом.

Есть и проблема «та же страница, другой адрес». Когда одно и то же содержимое доступно по множеству URL, поисковой системе нужно выбрать, какую версию показать. Иногда она выбирает «грязную». Иногда переключается между версиями. В любом случае главная страница набирает обороты медленнее.

Параметры также тратят бюджет сканирования. Боты могут тратить время на почти-дубликаты (версия с фильтром или трекингом) вместо того, чтобы быстрее обнаруживать ваши новые или важные страницы.

Как отчётность становится запутанной

Параметризованные обратные ссылки усложняют данные в аналитике и SEO-инструментах. Трафик и ссылки распределяются по разным URL, и сложнее ответить на простые вопросы вроде «Какая страница заработала эту ссылку?» или «Улучшилась ли наша страница?»

Обычный сценарий: вы заработали авторитетную обратную ссылку, но она ведёт на URL с UTM-метками. В инструментах теперь появляются две записи для одной страницы. Одна выглядит сильной (промаркированный URL с ссылкой), другая — слабой (чистый URL, который вы действительно хотите ранжировать). Это может подтолкнуть команды к неправильным решениям.

Полезно разделить параметры на две категории:

- Только для трекинга: используются для атрибуции или внутренней маршрутизации и не должны индексироваться.

- Индексируемые дубликаты: фильтры, сортировки и фасеты, которые создают множество версий, видимых для сканера, и выглядят как отдельные страницы.

Обе категории проблемны, но индексируемые дубликаты обычно наносят больший вред, потому что множатся быстрее.

Как найти параметризованные URL, на которые идут входящие ссылки

Основа любой очистки — знать, какие обратные ссылки попадают на параметризованные URL. Вам нужны доказательства, а не предположения: одна сильная ссылка на неверный URL может расколоть авторитет между дубликатами.

Соберите кандидатов из нескольких источников, потому что каждый инструмент имеет свои слепые зоны:

- Инструменты обратных ссылок: экспортируйте списки «целевых URL» и включайте ссылающуюся страницу.

- Google Search Console: посмотрите точные URL в разделе «Links».

- Страницы входа в аналитике: найдите страниц входа с параметрами, которые всё ещё получают визиты.

- Логи сервера: отследите реальные запросы с реферерами (особенно когда боты не видны в аналитике).

- Трекеры платных кампаний: соберите реальные шаблоны параметров, которые встречаются.

Когда у вас есть список, группируйте URL по пути сначала (всё до ?). Обрабатывайте /pricing как одну группу, затем сравнивайте шаблоны параметров внутри неё. Так легче отделить безвредные трекинговые параметры (как utm_*) от проблемных дубликатов (например, множественные комбинации sort= и filter=).

Затем приоритизируйте. Сортируйте по силе ссылающихся доменов и по числу уникальных ссылающихся страниц. Если высокоавторитетное размещение ссылается на что-то вроде /guides/seo?utm_source=newsletter\u0026session=9f3K2..., это стоит исправить в первую очередь.

Параметры, похожие на сессии, обычно легко заметить: они выглядят случайно и меняются при каждом визите. Следите за:

- Длинными смешанными строками (

a8F9kLm2Pq...) - Параметрами с именами

session,sid,phpsessid,token,gclid - Многими почти-идентичными URL, различающимися только одним значением

Определите успех до внесения изменений. Практическая цель: «80%+ известных входящих ссылок разрешаются на канонический URL», плюс короткий список самых авторитетных рефереров, подтверждённых как ведущие на чистую версию.

Решите правила канонических URL до внесения изменений

Прежде чем начинать очистку, определите, какая версия страницы — «единственно верная». Иначе вы исправите одни URL и случайно создадите другие.

Начните с глобальных правил, которые сможет соблюдать вся команда:

- Только HTTPS (никаких HTTP версий)

- Один стиль со слешем в конце (всегда с ним или всегда без)

- Один стиль хоста (www или без www)

- По возможности пути в нижнем регистре

- Никаких трекинговых параметров в публичных, удобных для шаринга ссылках

Дальше ясно определите, когда параметр создаёт реальное содержимое, а когда — дубликат.

Параметр «реален», когда он существенно меняет смысл страницы для пользователя и должен быть индексируем. Пример: вариант товара с собственным SKU, ценой и наличием.

Параметр — «дубликат», когда он только меняет отображение или трекинг одного и того же набора элементов. Это включает большинство трекинговых тегов, session ID и опции сортировки. Их обычно стоит сводить в чистый канонический URL.

Запишите правила для параметров, которые вы реально видите. Для многих сайтов отправной точкой будут такие правила:

utm_*и другие кампании: не часть канонического URLgclidиfbclid: не часть канонического URLsessionилиsid: никогда не канонический, не индексируемsortиorder: обычно не канонические, как правило не индексируем- параметры фильтров и фасетов: зависит (некоторые полезны, многие создают дубликаты)

Затем решите, что должно индексироваться, а что нет. Фасетированные страницы и внутренние страницы поиска — там сайты часто случайно создают тысячи тонких дубликатов. Если отфильтрованная страница имеет уникальную ценность и вы хотите, чтобы она появлялась в поиске, относитесь к ней как к реальной посадочной странице с стабильным URL и согласованными каноническими тегами. Если это временный вид, держите её вне индекса и направляйте сигналы назад к основной категории.

Документируйте эти решения простым языком. Маркетинг должен понимать, как тегировать и чем делиться. Разработчики должны знать, что редиректить, что канонизировать и что держать вне индекса.

Пошагово: самый безопасный способ очистки параметризованных обратных ссылок

Очистка параметров затрагивает SEO, аналитику и иногда потоки оформления заказа или входа. Самый безопасный подход — менять как можно меньше за раз и делать каждое правило лёгким для тестирования.

Безопасный рабочий процесс очистки

Начните с списка шаблонов параметров, которые вы хотите исправить, затем ранжируйте по риску и эффекту. UTM и click ID обычно низкорисковые и высокообъёмные. Session ID могут быть выше по риску, потому что иногда влияют на загрузку страниц для вошедших пользователей.

Практическая последовательность выглядит так:

- Определите целевой URL для каждого шаблона параметров (например, убрать

utm_*,gclid,fbclid,sessionid). - Добавьте 301 редиректы там, где параметризованный URL явно дубликат той же страницы. Держите редирект в один прыжок.

- Используйте

rel=canonicalна страницах, где редиректы непрактичны (например, когда параметры меняют содержимое, но вы всё равно хотите один основной URL в индексе). - Исправьте генерацию URL у источника (маршрутизатор приложения, шаблоны CMS, внутренний поиск, фильтры, кэширование, генерация sitemap).

- Тестируйте реальные URL «от начала до конца», затем мониторьте результаты 2–4 недели, пока поисковики пересканируют и сигналы не консолидируются.

Тестирование важно. Выберите примеры из реальных обратных ссылок (авторитетный сайт, рассылка, пост в соцсетях) и подтвердите, что конечный URL стабилен, быстро загружается и показывает ожидаемое содержимое.

Пример: если сильная ссылка ведёт на /pricing?utm_source=partner\u0026utm_campaign=spring, правило должно 301 перенаправлять её на /pricing (без лишних параметров). Если атрибуция важна, сохраняйте UTM в настройках аналитики, но не позволяйте им создавать отдельные индексируемые страницы.

После запуска следите за циклами редиректов, неожиданными 404 и всплесками в Search Console таких отчётов, как «Duplicate» или «Alternate page with proper canonical».

Трекинговые параметры: сохраняем атрибуцию, но не создаём дубликаты

UTM-метки и другие параметры трекинга полезны тем, что показывают, откуда пришёл визит. Проблема возникает, когда эти параметризованные URL становятся сканируемыми, индексируемыми и удобными для шаринга. Тогда вы получаете множество версий одной страницы, конкурирующих за сигналы и захламляющих отчёты.

Цель простая: сохранить атрибуцию, но убедиться, что URL, который индексируют поисковики (и который получает долгосрочную ценность ссылок), — это чистая каноническая версия.

Как обращаться с трекинговыми параметрами, не теряя данных

Определите, какие параметры — только для трекинга (например: utm_source, utm_medium, utm_campaign, utm_term, utm_content, gclid, fbclid). Они не должны создавать новые индексируемые страницы.

По возможности удаляйте известные трекинговые параметры как можно раньше. Частый подход — 301-редирект с параметризованного URL на тот же путь без трекинговых параметров.

Чтобы сделать это безопасно и предсказуемо:

- Редиректьте только по параметрам, в которых вы уверены как в трекинговых.

- Держите назначение идентичным той же странице, только без параметров.

- Убедитесь, что чистый URL используется в канонических тегах и внутренних ссылках.

- Протестируйте несколько реальных URL кампаний перед массовым развёртыванием.

Исключения, для которых нужно спланировать

Иногда партнёр или рекламная платформа требует параметр для отчётности или подтверждения. В таких случаях вы можете позволить параметру существовать для пользователей, но при этом сохранять чистый канонический URL для поисковиков. Главное — чтобы поисковые системы понимали предпочитаемую версию и не индексировали трекинговый вариант.

Также согласуйте правила с командами email и рекламы. Заведите короткое правило по тегированию (разрешённые параметры, нейминг, нижний vs верхний регистр), чтобы будущие кампании не придумывали новые варианты и не вернули дубликаты.

Фильтры и фасетированная навигация: где очистка становится сложной

Фасетированная навигация — это место, где очистка URL перестаёт быть простым «убрать параметры» заданием. Фильтры могут создавать тысячи вариаций страницы, которые для пользователя выглядят по-разному, но для поисковика — почти-дубликаты. Частые виновники: параметры sort=, color=, size=, price=, brand=, inStock=.

Некоторые отфильтрованные страницы действительно полезны. «Мужские беговые кроссовки» может быть широким запросом, но «мужские беговые кроссовки размер 12» может иметь реальный спрос. Если вы отметите все фильтрованные страницы как мусор, вы можете убрать страницы, которые должны ранжироваться.

Практическое правило — разрешать для сканирования лишь небольшой набор высокопросматриваемых фильтров и держать остальные вне индекса. Это значит заранее решить, какие фильтры — настоящие поисковые посадочные страницы, а какие — просто элементы интерфейса.

Что часто работает — смесь подходов:

- Канонизировать большинство отфильтрованных страниц на базовую категорию, когда содержимое в основном совпадает.

- Использовать

noindexдля отфильтрованных страниц, которые нужны пользователям, но не должны индексироваться. - Сокращать трату бюджета сканирования для очевидно низкозначимых вариантов (особенно

sort=и опции вида). - Создать короткий список «индексируемых фасетов» со стабильными, целевыми URL.

Будьте осторожны с массовыми редиректами. Редирект всех параметризованных URL на базовую категорию может сломать пользовательские выбранные представления (например, ссылка с color=black внезапно ведёт на нефильтрованную страницу). Это также усложняет отчётность, если маркетинг полагается на определённые параметры.

Более безопасный подход — выборочная очистка: нормализуйте то, что не хотите индексировать, и сохраните то, что намеренно хотите видеть в выдаче.

Распространённые ошибки, которые тратят ссылочный капитал при очистке

Цель — направлять авторитет на один чистый, последовательный URL. Большинство проблем возникает, когда исправление делают поспешно и правила назначения не ясны.

Перенаправление всех параметризованных URL на главную страницу (или «достаточно близкую» категорию) — частая ошибка. Поисковики часто рассматривают это как мягкую ошибку, когда исходный URL явно указывал на конкретный продукт, статью или страницу местоположения. Даже если редирект технически работает, релевантность может упасть, и польза от ссылки ослабнет.

Цепочки редиректов — ещё один тихий разряд. Например, обратная ссылка попадает на /page?utm_source=x, затем редиректит на /page?ref=y, а затем уже на /page. Цепочки замедляют сканирование, повышают риск ошибок и делают консолидацию менее надёжной. Стремитесь к одному прыжку: параметризованный URL идёт прямо на канонический.

Также следите за использованием 302 (временных) редиректов для перманентной очистки. Если параметризованный URL не должен индексироваться, используйте постоянный редирект. Иначе обе версии могут оставаться в индексе.

Канонические теги могут навредить, если они указывают на URL, который не возвращает 200, или когда смешиваются HTTP и HTTPS. Канонический должен указывать на точную версию, которую вы хотите индексировать, и эта страница должна корректно загружаться.

Один неожиданный момент — преждевременная блокировка параметризованных URL в robots.txt. Если Google не может просканировать параметризованный URL, он может не увидеть ваш редирект или тег canonical, что замедлит консолидацию. Сначала дайте поработать редиректам и каноникам, а уже потом ужесточайте правила сканирования при необходимости.

И, наконец, очистка терпит неудачу, когда маркетинг продолжает генерировать новые шаблоны параметров без правил. Вы исправили utm_, затем следующая кампания придумывает campaignId, ref или session ID, и дубликаты возвращаются.

Быстрый чек-лист до и после деплоя изменений

Обращайтесь к очистке как к небольшому релизу: определите, как выглядит «правильно», затем проверьте это в браузерах, краулерах и инструментах поиска.

До деплоя

Выберите несколько реальных параметризованных URL, которые уже присутствуют в обратных ссылках (UTM, session ID, сортировка, фильтры). Для каждого запишите единственный чистый URL, на котором он должен завершаться.

- Подтвердите, что каждый пример параметризованного URL заканчивается на один конечный чистый URL (а не на несколько исходов).

- Проверьте цепочки и петли редиректов (идеально — один шаг).

- Убедитесь, что канонический тег на финальной странице точно соответствует финальному URL.

- Проверьте, что важные страницы доступны без параметров и загружаются быстро.

- Решите, как будете обрабатывать «разрешённые» параметры (например: хранить UTM для аналитики, но не делать их индексируемыми).

После деплоя

Начните с выборочной проверки, затем наблюдайте тренды в течение нескольких недель. Редиректы и каноники могут выглядеть корректно по отдельности, но вести себя иначе в масштабе.

- Повторно протестируйте набор образцов и подтвердите, что они разрешаются одинаково в браузере и краулере.

- Проверьте, не потеряли ли ваши наиболее ссылочные страницы внутренние ссылки или навигацию.

- Следите за Search Console: ожидайте постепенного снижения числа дубликатов и альтернативных URL, связанных с параметрами.

- Подтвердите, что отчёты всё ещё корректно атрибутируют кампании, без появления новых параметризованных страниц как страниц входа.

Пример: исправление авторитетных обратных ссылок, ведущих на UTM и session URL

Авторитетный сайт ссылается на вашу страницу с прайсом, но URL у них «грязный»: /pricing?utm_source=techblog\u0026utm_medium=referral.

Второй сайт ссылается на версию с сессией вроде /pricing?sessionid=9f3a.... Обе ссылки ценны, но их целевые URL — нет.

До очистки пользователи и пауки видят множество версий одной и той же страницы. В аналитике может появиться несколько «pricing» страниц. Поисковики могут индексировать более одного URL. Ссылочный капитал распределяется между дубликатами.

Примените ясное правило: канонический URL — /pricing, а трекинг и сессионные параметры не должны создавать новую версию.

Для session ID обычно решение — убрать их полностью. Если ваш сайт всё ещё генерирует sessionid в URL, это более серьёзная проблема, но вы можете защитить SEO, перенаправляя любые входящие URL с sessionid на /pricing.

Для UTM можно сохранить атрибуцию, не оставляя «грязный» URL в индексе. Один распространённый подход: при заходе с utm_ параметры читаются сервером и сохраняются (например, в first-party cookie или логах сервера), а затем отдаётся 301-редирект на /pricing.

Со временем вы увидите консолидацию:

- Меньше параметризованных URL в индексе

- Ранжирование и показы концентрируются на главной странице

/pricing - Инструменты обратных ссылок атрибутируют больше ценности каноническому URL

Если вы активно размещаете авторитетные ссылки, эту очистку стоит сделать как можно раньше. Когда вы размещаете или заказываете ссылки через провайдера вроде SEOBoosty (seoboosty.com), отправляйте чистый канонический URL заранее, чтобы сильные упоминания усиливали ту страницу, которую вы действительно хотите продвигать.

FAQ

What counts as a query parameter in a backlink URL?

Параметры запроса — это всё, что идёт после ? в URL, например ?utm_source=newsletter или ?sessionid=123. Они часто меняют способ отслеживания или отображения страницы, но могут также создавать множество «разных» URL, которые загружают одно и то же содержимое.

Why can backlinks with parameters hurt rankings?

Потому что поисковые системы рассматривают разные URL как разные страницы, даже если они выглядят одинаково. Если обратные ссылки ведут на множество версий с параметрами, авторитет может распыляться между дубликатами, и версия, которую вы хотите продвигать, будет укрепляться медленнее.

How do I find which parameterized URLs are getting backlinks?

Начните с экспорта точных «целевых URL» из инструмента проверки обратных ссылок и Google Search Console, затем найдите в них ?. Сгруппируйте по базовому пути (всё до ?), чтобы понять, какие параметры — просто трекинговые, а какие создают много почти-дубликатов.

Should I redirect UTM-tagged backlinks to the clean URL?

Обычно да для параметров, используемых только для трекинга, если содержимое совпадает и вы не ломаете функциональность. Самый чистый подход — сделать так, чтобы такие запросы consistently вели на канонический URL, чтобы долгосрочная ценность ссылок концентрировалась на одной странице.

What about ad click IDs like gclid or fbclid—do they need special handling?

Относитесь к идентификаторам кликов вроде gclid и fbclid как к трекинговым параметрам: обычно они не должны становиться индексируемыми вариантами страниц. Если вы их удаляете, убедитесь, что система аналитики всё ещё фиксирует данные кампании до нормализации URL.

Why are session ID parameters especially dangerous for backlinks?

Session ID опасны тем, что могут истекать или меняться для каждого посетителя, превращая хорошие обратные ссылки в нестабильные или нерабочие. Практическое решение — перестать генерировать session ID в URL, а входящие URL с такими параметрами нормализовать на стабильную каноническую страницу.

Should I remove or keep filter and sort parameters on category pages?

Не всегда. Некоторые фильтрованные страницы могут быть законными посадочными страницами для поиска, если они стабильны и действительно уникальны. По умолчанию безопасно не позволять большинству вариантов фильтров соревноваться с основной категорией и позволять в индексе только небольшой набор целевых, стабильных фильтрованных страниц.

When should I use 301 redirects vs canonical tags vs noindex for parameter URLs?

Используйте 301-редирект, когда версия с параметрами очевидный дубликат и вы хотите один окончательный URL. Используйте тег canonical, когда параметр нужен пользователям, но вы хотите, чтобы поисковики считали другой URL основным. Рассмотрите noindex для страниц, которые нужны пользователям, но вы не хотите видеть в поиске.

Should I block parameter URLs in robots.txt to stop duplicates?

Раннее блокирование через robots.txt может замедлить консолидацию: если Google не сможет просканировать параметризованный URL, он не увидит ваш редирект или тег canonical. Обычно лучше сначала дать работать редиректам и каноникам, а уж потом при необходимости ограничивать сканирование.

What URL should I provide to partners or SEOBoosty when building backlinks?

Дайте партнёрам точный чистый канонический URL, который вы хотите продвигать, без трекинговых или сессионных параметров, и укажите предпочитаемый формат HTTPS и хоста. Если вы размещаете авторитетные ссылки через провайдера вроде SEOBoosty, отправка чистого URL заранее помогает обеспечить, что сильные упоминания усиливают нужную страницу, а не её «грязную» версию.