Дока́жите влияние беклинков по логам сервера до изменения позиций

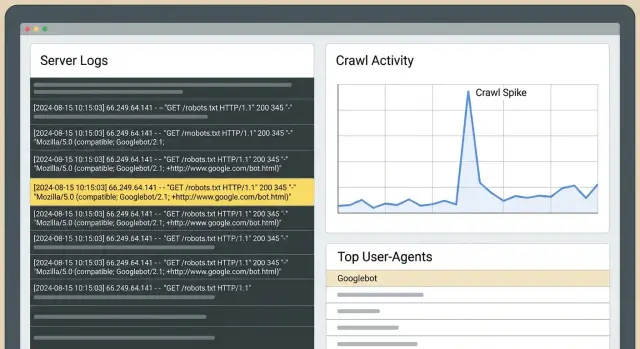

Докажите влияние беклинков через логи сервера: отслеживайте всплески краулинга Googlebot, пути бота и частоту фетчей, чтобы подтвердить эффект ссылок до изменения позиций.

Что можно доказать с помощью логов до изменения позиций

Позиции часто отстают. Google нужно повторно просканировать страницы, обработать новые сигналы, обновить индекс и затем принять решение о смене позиций. Это задержка — причина, почему вы можете проделать хорошую работу, а счётчики позиций не покажут изменений в течение дней или недель.

Логи сервера находятся раньше в этой цепочке. Они помогают ответить на более простую задачу: изменил ли Googlebot своё поведение на вашем сайте после появления ссылок? Если ответ «да», у вас есть доказательство, что что‑то действительно произошло, даже если трафик и позиции ещё не сдвинулись.

Самые быстрые и заметные сдвиги в логах обычно выглядят так:

- Нацеленная страница начинает сканироваться чаще или начинает сканироваться вообще.

- Googlebot возвращается к этой странице быстрее (короче интервалы между фетчами).

- Googlebot использует эту страницу как точку входа и затем глубже переходит по внутренним ссылкам.

- Вы видите всплески краулинга вскоре после размещения, особенно если сайт‑источник сам часто сканируется.

Это отличается от Search Console и трекеров позиций. Search Console полезна, но запаздывает и группирует данные. Трекеры показывают исходы, а не причины. Логи показывают сырое поведение: каждый запрос с отметкой времени, какой бот какие URL запрашивал и какой код ответа вернул ваш сервер.

Основной метод прост: выберите чистое окно «до» и окно «после», затем сравните активность Googlebot для конкретных URL, которые вы целили. Если в окне «после» видно более частый краулинг и более целенаправленные пути, можно утверждать, что ссылки привлекли внимание Google.

Пример: вы направляете новый беклинк на страницу продукта. Через два дня в логах видно, что Googlebot многократно фетчит эту страницу, затем запрашивает страницу с характеристиками и страницу с прайсом, на которые она ссылается. Рейтинги могут ещё не сдвинуться, но Google явно тратит там краул‑бюджет. Это часто первый видимый шаг перед более широкими улучшениями.

Основы логов сервера (простыми словами)

Лог сервера — это дневник запросов к вашему сайту. Каждый раз, когда браузер, приложение или поисковый бот запрашивает страницу или файл, сервер (или CDN) записывает строку.

Для SEO‑проверок важнее всего поля: timestamp, запрошенный URL, user‑agent (например, Googlebot), код статуса (200, 301, 404) и обычно IP. Не нужно запоминать каждую колонку. Каждая строка отвечает на вопросы: кто что запросил, когда и что произошло.

Какие логи использовать?

Начните с origin access logs, если это возможно. Они ближе всего к «истине» и содержат точные URL и коды ответа.

Если вы используете CDN/WAF/слой защиты от ботов, его логи дают контекст (блокировки, челленджи), но могут фильтровать или помечать трафик так, что часть картины скрывается. По возможности храните оба набора и учитывайте правила фильтрации, которые меняют видимость.

Как долго хранить логи?

Ретеншн важен для сравнений «до‑и‑после». 30 дней — практический минимум. 60–90 дней лучше, если вы размещаете ссылки пачками или часто публикуете. Нужно достаточно данных «до», чтобы понять нормальный краулинг, и достаточно «после», чтобы увидеть, изменились ли частота посещений и маршруты краулинга.

Про приватность: храните только нужное, ограничьте доступ и удаляйте по расписанию. Если в логах есть персональные данные (например, полные IP или строки запроса с емейлами), маскируйте или удаляйте эти поля. Для такого анализа важны поведение ботов, коды ответа и пути страниц.

Как отличить реальный Googlebot от шума

Прежде чем интерпретировать любой «всплеск», убедитесь, что трафик, помеченный как Googlebot, действительно принадлежит Google. Фейковые боты часто копируют user‑agent. Если вы их посчитаете, можно «доказать» всплеск краулинга, которого на самом деле не было.

Строки user‑agent — это отправная точка (Googlebot, Googlebot‑Image, AdsBot‑Google), но они не являются доказательством.

Почему появляются фейковые боты

Спуфинг Google помогает скрейперам избежать блокировок, пробовать сайт или массово вытягивать контент. Они также могут накручивать запросы к конкретным URL и создавать видимость интереса Google сразу после размещения ссылки.

Простые способы верифицировать Googlebot

Выберите один подход и используйте его последовательно:

- Проверка обратного DNS: IP должен резолвиться в hostname, принадлежащий Google, и этот hostname должен резолвиться обратно в тот же IP.

- Санитарные проверки по паттернам: реальный Googlebot демонстрирует стабильное поведение (регулярные fetch robots.txt, логичные переходы по сайту).

Если возможно, разделяйте Googlebot Smartphone и Googlebot Desktop — они часто ведут себя по‑разному. Изменение может сначала появиться на Smartphone, в то время как Desktop остаётся неизменным.

Четыре сигнала в логах, которые указывают, что ссылки изменили поведение

Рейтинги отстают от того, что Googlebot уже делает. После выхода размещения эти ранние сигналы в логах стоит отслеживать.

Сигнал 1: Устойчивый рост краулинга на целевой странице

Сильный признак — заметное увеличение запросов Googlebot к странице, на которую направлен беклинк, устойчивое в течение нескольких дней. Сравнивайте аналогичные периоды (одни и те же дни недели), чтобы не принять обычные недельные колебания за «успех».

Сигнал 2: Более частые фетчи (короче циклы повторного сканирования)

Когда Google начинает уделять больше внимания, он часто возвращается быстрее. В логах это видно как сокращение интервалов между обращениями к одному и тому же URL. Это может произойти задолго до подъёма позиций, особенно для страниц, которые раньше сканировались редко.

Сигнал 3: Пути бота расширяются от целевой страницы

После того как Googlebot заходит на связанную страницу, проверьте, что он запрашивает дальше в той же сессии или в коротком временном окне. Если обнаружение улучшилось, вы увидите более последовательное движение от целевой страницы к соседним URL (категории, вспомогательные статьи, ключевые продуктовые страницы).

Сигнал 4: Первичные сканирования соседних URL

Если целевая страница ссылается на другие URL, которые раньше почти не сканировались, следите за их первыми фетчами. Шаблон «вентиляторного» распространения обычно означает, что Googlebot исследует сайт, а не просто перепроверяет одну страницу.

Во всех четырёх сигналах коды статуса решают, полезен ли краулинг:

- 200 — Googlebot получил контент для оценки.

- 301 — не всегда плохо, но длинные цепочки редиректов тратят краул‑бюджет.

- 404 — создают шумовую активность без ценности.

- 5xx — часто ведут к падению краулинга впоследствии.

Как настроить надёжное сравнение «до‑и‑после»

Главный риск при валидации по логам — грязное сравнение. Googlebot меняет поведение по множеству причин, поэтому ваша настройка должна сделать «публикация ссылки» основной переменной.

Используйте два равных окна: обычно 14–28 дней до публикации (база) и такое же количество дней после.

Затем отслеживайте небольшой, конкретный набор страниц:

- URL, на который указывает новый беклинк.

- Страница, за которую вы действительно боретесь (если это не тот же URL).

- 2–3 тесно связанные страницы в том же разделе сайта.

- Одна контрольная страница в том же шаблоне/папке, на которую новые ссылки не указывали.

Для каждой страницы отслеживайте ежедневные хиты Googlebot, уникальные URL, просканированные в этом кластере, и медиану времени между фетчами. Медиана более устойчива, чем среднее, когда всплески краулинга искажают данные.

Перед сравнением сделайте быстрые проверки: подтвердите, что ссылка активна и индексируема в окне «после», держите основные изменения сайта вне окон (миграции, серьёзные изменения шаблонов), применяйте одинаковые правила валидации бота и фильтрации, и держите контрольную страницу сопоставимой.

Пошагово: как верифицировать влияние ссылки по логам

Вам не нужны изменения позиций, чтобы увидеть ранние изменения поведения. Если ссылка обнаружена и воспринята как значимый сигнал, логи обычно покажут это первыми.

Практический рабочий процесс:

- Вытяните сырые логи для чистого окна «до» и совпадающего окна «после».

- Отфильтруйте проверенные запросы Googlebot и разделите Smartphone и Desktop, если есть такая возможность.

- Группируйте по URL и по дням. Ищите концентрированные подъёмы на целевых страницах, а не просто общий рост по сайту.

- Проверьте пути: что Googlebot запрашивает после фетча целевой страницы?

- Пишите одно итоговое предложение на страницу, используя один и тот же шаблон каждый раз.

Держите выводы строгими и тестируемыми. Пример: «После публикации ссылки Googlebot Smartphone увеличил фетчи /pricing с 3 в неделю до 11 в неделю и затем в течение 10 минут просканировал /features и /checkout, чего не было в базовом окне.»

Если вы не можете сформулировать чистое такое предложение, скорее всего окно сравнения слишком шумное или вы смешали Googlebot с другими краулерами.

Как интерпретировать пути бота: что делает Googlebot после найденной ссылки

Когда обнаруживается новый беклинк, Google редко меняет позиции за одну ночь. Сначала он обычно меняет маршрут по вашему сайту. Анализ путей — это чтение шагов Googlebot: что он запросил первым, что дальше и как часто возвращается.

Разделите в голове два URL:

- Связанная страница (куда указывает беклинк).

- «Денежная» страница (страница, которую вы хотите продвинуть).

Часто связанная страница разогревается первой, а затем передаёт внимание через внутренние ссылки.

Полезное сравнение — точки входа. До ссылки Googlebot мог заходить через главную страницу или sitemap. После ссылки вы можете увидеть прямые заходы на связанный URL с последующим углублением по внутренним ссылкам.

Следите за изменениями:

- Более частые хиты на связанном URL.

- Более глубокие страницы, которые сканируются раньше и регулярнее.

- Сокращение циклов обновления по страницам кластера.

- Всплески параметризованных или дублирующих URL (часто признак траты краул‑бюджета, а не прогресса).

Если параметры вроде ?sort= или пагинация начинают расти, беклинк всё ещё может помогать, но логи одновременно подсказывают, что нужно убрать ловушки краулинга, чтобы Google тратил время на важные страницы.

Частые ошибки, приводящие к ложным выводам

Логи могут давать раннее подтверждение, но также усиливать обычный шум.

Самая частая ошибка — сравнивать периоды, которые на самом деле не сопоставимы. Подъёмы краулинга могут вызываться редизайнами, изменениями навигации, запуском новых страниц, правками robots.txt, правилами WAF/фаервола и проблемами со статусами (цепочки редиректов, всплески 404, 5xx).

Ещё одна частая ошибка — считать всех ботов, включая поддельные user‑agent.

Прежде чем верить «выигрышу», проверьте базовые вещи: сравнивайте одинаковые дни недели, просмотрите изменения robots и индексации в окне, разделяйте коды статусов (200 vs 3xx vs 4xx/5xx), фильтруйте проверенный Googlebot и ищите устойчивое повышение, а не однодневный пик.

Пример: вы купили ссылку на /pricing, и через два дня Googlebot стал фетчить /pricing в 5 раз чаще. Но если вы также развернули редизайн, который добавил хедер‑ссылки на /pricing, подъём может быть следствием внутреннего обнаружения, а не внешнего беклинка.

Быстрый чеклист: изменила ли новая ссылка поведение Google?

Используйте одинаковые окна с обеих сторон (например, 14 дней до публикации vs 14 дней после). Отфильтруйте проверенные запросы Googlebot и ответьте на вопросы:

- Увеличилось ли число запросов к целевому URL в значимой степени?

- Становился ли краулинг более равномерным в течение недели, а не единичными пиками?

- Уменьшилось ли типичное время между фетчами для целевой страницы и близких поддерживающих страниц?

- Оставались ли уровни ошибок стабильными при увеличении краулинга?

- Оставалась ли похожая контрольная страница примерно неизменной?

Если на три и более вопроса ответ «да», поведение Googlebot, вероятно, изменилось, даже если позиции ещё не сдвинулись.

Две дополнительные проверки сохранят честность: убедитесь, что изменение не глобальное для всего сайта, и что тайминг совпадает (начало вскоре после публикации и стабильно повышенное значение).

Пример сценария: доказать влияние для одной страницы за 3 недели

SaaS‑компания имеет страницу фичи с хорошей конверсией, но пока мало органического трафика. Они добавляют три новых беклинка прямо на эту страницу и хотят доказать, что что‑то изменилось, не дожидаясь позиций.

До выхода ссылок они выгружают базу из логов для этого URL: хиты Googlebot в день, интервалы между визитами и какие URL Googlebot посещает сразу после него.

Неделя 1: через несколько дней логи показывают рост краулинга. Ещё более важно, Googlebot не останавливается на странице фичи: он начинает исследовать соседние пути, такие как pricing, integrations и сопутствующие статьи. Такой «фан‑аут» часто сигнализирует о новом пути входа.

Неделя 2–3: частота возвратов растёт, интервалы между сканированиями сокращаются. Вы также можете увидеть больше 304 (Not Modified), что нормально, когда Google часто проверяет страницу и контент не меняется.

Чтобы объяснить это стейкхолдеру без обсуждения позиций, покажите изменение поведения: до vs после — ежедневные запросы к странице фичи, медиану часов между визитами и наиболее частые последующие URL после фичи.

Если логи не показывают изменений через 2–3 недели, не делайте вывод о провале. Проверьте блокировки (robots.txt, noindex, 4xx/5xx), укрепите внутренние ссылки на страницу и пересмотрите, не стоило бы направлять ссылку на hub‑страницу вместо конечной landing‑страницы.

Следующие шаги: сделать верификацию по логам повторяемой

Когда вы научитесь валидировать эффект ссылок по логам, превратите это в ежемесячную рутину. Держите постоянное окно (например, последние 30 дней) и отчитывайтесь по одним и тем же метрикам каждый раз: какие страницы получили наибольшее число хитов Googlebot, где концентрировались подъёмы после работ по ссылкам, как изменились медианные интервалы фетчей на ключевых страницах, какие пути появились или усилились и какие ошибки тратят краул‑бюджет.

Если вы пользуетесь провайдером вроде SEOBoosty (seoboosty.com) для закрепления размещений, фиксируйте точные даты go‑live и целевые URL. Чистый тайминг делает сравнения «до‑и‑после» по логам гораздо надёжнее.

FAQ

Почему логи могут показывать прогресс, даже когда рейтинги не меняются?

Рейтинги требуют повторного сканирования страниц, обработки сигналов, обновления индекса и затем переоценки позиций. Логи находятся раньше в этой цепочке, поэтому они могут показать, изменилось ли поведение Googlebot вскоре после публикации ссылки, даже когда трекеры позиций остаются неизменными.

Какой самый очевидный признак в логах того, что беклинк замечен?

Ищите устойчивое увеличение проверенных хитов Googlebot на точный URL, на который указывает новая ссылка, а также сокращение интервалов между обращениями. Самое сильное подтверждение — когда Googlebot попадает на связанную страницу и затем последовательно сканирует важные соседние страницы в ближайшее время.

Какой длины должны быть окна «до» и «после»?

Используйте равные окна по обе стороны от даты публикации, обычно 14–28 дней до и столько же после. Сравнивайте одинаковые дни недели, потому что поведение краулера часто отличается в будни и выходные.

Какие логи лучше использовать: origin или CDN/WAF?

Начните с origin access logs — они ближе всего к «истине» и показывают точные URL и коды ответа. Логи CDN, WAF или защиты ботов полезны как дополнительный контекст, но там может быть фильтрация или пометки, которые искажают картину.

Как убедиться, что «Googlebot» в логах — настоящий Google?

Не доверяйте только user-agent, потому что фейковые боты копируют его. Практический минимум — проверка через обратный DNS: IP должен резолвиться в hostname, принадлежащий Google, и этот hostname должен резолвиться обратно в тот же IP.

Стоит ли разделять Googlebot Smartphone и Desktop в анализе?

Разделяйте их, если можете: Googlebot Smartphone и Googlebot Desktop часто краулит по‑разному, и изменение может проявиться сначала в одном из них. Если смотреть только объединённый вид, реальный сдвиг может размыться и показаться как «без изменений».

Как отличить реальный подъем краулинга от обычного шума?

Реальный сдвиг обычно устойчив во времени (несколько дней) и сосредоточен на целевых страницах, а не разовый пик. Также проверьте, что тайминг совпадает с публикацией ссылки и что контрольная страница остаётся примерно стабильной.

Какие коды ответа важны при оценке изменений краулинга?

Код 200 означает, что Googlebot получил контент для оценки — значит, увеличение краулинга полезно. Частые 301 и длинные цепочки редиректов съедают краул‑бюджет, всплески 404 дают ложную активность, а 5xx могут привести к снижению краулинга позже.

Как анализировать пути бота после сканирования связанной страницы?

Отслеживайте точки входа и какие URL Googlebot запрашивает дальше после посещения связанной страницы в коротком временном окне. Если связанная страница становится постоянной точкой входа, а затем краулер переходит на связанные страницы (pricing, спецификации, сопут. материалы), это сильный сигнал, что ссылка улучшила обнаружение.

Как лучше всего отчитаться перед заинтересованными лицами о влиянии беклинков по логам?

Пишите одно строгое, проверяемое предложение на целевой URL, указывающее изменение «до» и «после» по объёму обращений и частоте возвратов, плюс одну наблюдаемую смену пути, если она есть. Если вы работаете с провайдером вроде SEOBoosty, фиксируйте точные даты go‑live и целевые URL, чтобы окна сравнения были чистыми и выводы — правдоподобными.